2009年12月1日

2009年12月1日

通过本教程,您将了解到什么是Mondiran,及如何将mondrian支持添加到您的Java Web项目中。

在阅读本教程之前,您可能需要掌握以下概念:

OLAP(联机分析处理On-Line Analytical Processing),您可以通过阅读ROLAP的概念.pptx来了解OLAP

MDX多维表达式,您可以通过阅读MDX的基本语法及概念.pptx来了解MDX

1. Mondrian是什么?

Mondrian是一个开源项目。一个用Java写成的OLAP引擎。它用MDX语言实现查询,从关系数据库(RDBMS)中读取数据。然后经过Java API以多维的方式对结果进行展示。

Mondrian的使用方式同JDBC驱动类似。可以非常方便的与现有的Web项目集成

1.1 Mondrian的体系结构(Architecture)

Mondrian OLAP 系统由四个层组成; 从最终用户到数据中心, 顺序为:

1.1.1 表现层(the presentation layer)

1.1.2 维度层(the dimensional layer)

1.1.3 集合层(the star layer)

1.1.4 存储层(the storage layer)

结构图如下:

1.1.1 表现层(the presentation layer)

表现层决定了最终用户将在他们的显示器上看到什么, 及他们如何同系统产生交互。

有许多方法可以用来向用户显示多维数据集, 有 pivot 表 (一种交互式的表), pie, line 和图表(bar charts)。它们可以用Swing 或 JSP来实现。

表现层以多维"文法(grammar)(维、度量、单元)”的形式发出查询,然后OLAP服务器返回结果。

1.1.1.1 Jpivot表现层

JPivot 是Mondrian的表现层TagLib,一直保持着良好的开发进度。

您可以通过访问jpivot的官方网站http://jpivot.sourceforge.net/以获得更多的帮助及支持

jpivot使用XML/ XSLT渲染OLAP报表:

JPivot 使用 WCF (Web Component Framework) ,基于XML/XSLT来渲染Web UI组件。这使它显得十分另类。不过,OLAP报表这种非常复杂但又有规律可循的东西,最适合使用XSLT来渲染。

jpivot完全基于JSP+TagLib:

JPivot另外一个可能使人不惯的地方是它完全基于taglib而不是大家熟悉的MVC模式。

但它可以很方便的将多维数据展示给最终用户,如下表格:

jpivot其实是一个自定义jsp的标签库。它基于XML/XSLT配置来生成相应的html。所幸的是,我们并不需要了解太多关于这方面的内容,我们只要掌握相应jsp标签的使用即可。

在本教程的实例中,我们将会对一些常用到的jpivot标签进行讲解。

您还可以通过汉化WEB-INF/jpivot下的xml文件来完成对jpivot的汉化工作

1.1.2 维度层(the dimensional layer)

维度层用来解析、验证和执行MDX查询要求。

一个MDX查询要通过几个阶段来完成:首先是计算坐标轴(axes),再者计算坐标轴axes 中cell的值。

为了提高效率,维度层把要求查询的单元成批发送到集合层,查询转换器接受操作现有查询的请求,而不是对每个请求都建立一个MDX 声明。

1.1.3 集合层(the star layer)

集合层负责维护和创建集合缓存,一个集合是在内存中缓存一组单元值, 这些单元值由一组维的值来确定。

维度层对这些单元发出查询请求,如果所查询的单元值不在缓存中,则集合管理器(aggregation manager)会向存储层发出查询请求

1.1.4 存储层(the storage layer)

存储层是一个关系型数据库(RDBMS)。它负责创建集合的单元数据,和提供维表的成员。

1.2 API

Mondrian 为客户端提供一个用于查询的API

因为到目前为止,并没有一个通用的用于OLAP查询的API,因此Mondrian提供了它私有的API.

尽管如此,一个常使用JDBC的人将同样发现它很熟悉.不同之处仅在于它使用的是MDX查询语言,而非SQL

下面的java片段展示了如何连接到Mondrian,然后执行一个查询,最后打印结果.

- import mondrian.olap.*;

- import java.io.PrintWriter;

- Connection connection = DriverManager.getConnection("Provider=mondrian;"

- +"Jdbc=jdbc:odbc:MondrianFoodMart;"

- +"Catalog=/WEB-INF/FoodMart.xml;",null,false);

- Query query = connection.parseQuery("SELECT {[Measures].[Unit Sales], [Measures].[Store Sales]} on columns,"

- +" {[Product].children} on rows "

- +"FROM [Sales] " +"WHERE ([Time].[1997].[Q1], [Store].[CA].[San Francisco])");

- Result result = connection.execute(query);

- result.print(new PrintWriter(System.out));

与JDBC类似,一个Connection由DriverManager创建,Query 对象类似于JDBC 的Statement,它通过传递一个MDX语句来创建.Result对象类似于JDBC的ResultSet,只不过它里面保存的是多维数据

您可以通过查看Mondrian帮助文档里的javadoc来获取更多关于Mondrian API的资料

通过上面的介绍,您应该对mondrian的体系有一个基本的了解。

下面我们将通过一个简单的例子来加深您的理解。

2. 一个简单的Mondrian例子

现在让我们用一个简单的例子来说明将Mondrian支持添加到您java web的具体步骤。

2.1 准备开发工具及环境

本测试需要的环境:

操作系统:Windows 2000;

Web服务器:tomcat6.0;

关系数据库:sql server 2000;

开发工具:eclipse + myeclipse;

JDBC驱动:jtds-1.2.2;

您可以在http://tomcat.apache.org/上下载到tomcat的最新版本及帮助;

您可以在http://www.myeclipseide.com/上下载到myeclipse的最新版本及相应的eclipse开发平台版本

2.2 准备Mondrian资源:

从http://sourceforge.net/projects/mondrian/下载Mondrian的最新版本(目前版本为3.0,大约有50M+大小)。

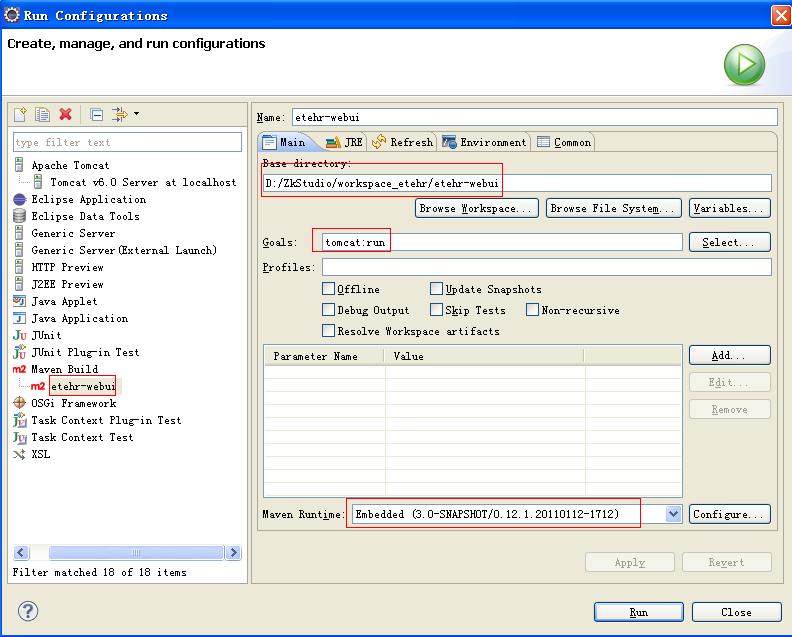

2.3 创建项目

启动eclipse。

在eclipse中新创建一个web项目,名为Tezz。注意需要加入JSTL支持。

具体步骤如下:

2.3.1 打开新建web项目对话框

一个新项目Tezz的文件结构如下:

一个新项目Tezz的文件结构如下:

2.4 添加必须的文件

将下载的压缩包进行解压。完成后,进入文件夹可以看到如下目录结构。双击进入lib文件夹。

Lib文件夹有如下内容:注意到这里的mondrian.war文件是一个可直接布署的项目,我们需要将它解压,然后从中取出我们所需要的文件。(建议将其扩展名改成zip,然后直接右键解压)

进入解压后的文件夹,选中jpivot、wcf二个文件夹及busy.jsp、error.jsp、testpage.jsp三个文件,我们需要将这些资源复制到我们测试项目的WebRoot文件夹中。按ctrl+C键复制。

注:jpivot、wcf这两个文件夹包含mondrian使用的图像和css文件。Busy.jsp显示等待页面、error.jsp显示出错页面、testpage.jsp这文件的用处将在后面介绍。

切换到eclipse界面,在我们的Tezz项目的WebRoot文件夹处右击鼠标,在弹出的菜单中选择Paste(粘贴)即可

粘贴完成后的项目结构如下

注意:因为我们还未将所有资料复制到项目中,因此eclipse会显示错误图标

最后进入WEB-INF文件夹(在上面步骤中解压的项目文件mondrian.war里),选中jpivot、lib、wcf这三个文件夹,同样需要复制它们到测试项目的WEB-INF文件夹中。

Jpivot、wcf这两个文件夹包含jpivot和wcf用于生成用户界面的配置文件(*.xml、*.xsl)及标签文件(*.tld)的定义。Lib文件夹包含的是mondrian所要用的java包。

切换到eclipse界面,在我们的Tezz项目的WebRoot文件夹处右击鼠标,在弹出的菜单中选择Paste(粘贴)

至此Mondrian的支持添加完毕,下面我们将配置web.xml,让我们的项目能够使用到mondrian的功能。

2.5 配置web.xml

用eclipse打开我们在上面解压的布署项目的WEB-INF/web.xml文件

过滤器(filter)

复制如下所示的xml代码到我们测试项目Tezz的web.xml文件中。

作用:这个过滤器在访问/testpage.jsp前被调用。它被设计成jpivot的前端控制器,用于判断并将用户的请求发送到某个页面。

注:在实际项目中可以使用您自己定义的servlet或使用其他技术来替代它以提供更多的功能

- <filter>

- <filter-name>JPivotController</filter-name>

- <filter-class>com.tonbeller.wcf.controller.RequestFilter</filter-class>

- <init-param>

- <param-name>indexJSP</param-name>

- <param-value>/index.html</param-value>

- <description>如果这是一个新的会话,则转到此页面</description>

- </init-param>

- <init-param>

- <param-name>errorJSP</param-name>

- <param-value>/error.jsp</param-value>

- <description>出错时显示的页面</description>

- </init-param>

- <init-param>

- <param-name>busyJSP</param-name>

- <param-value>/busy.jsp</param-value>

- <description>这个页面用于当用户点击一个查询时,在这个查询还未将结果还回给用户时所显示的界面</description>

- </init-param>

- </filter>

-

- <filter-mapping>

- <filter-name>JPivotController</filter-name>

- <url-pattern>/testpage.jsp</url-pattern>

- </filter-mapping>

复制下面的listener到我们的web.xml文件中(用于初始化一些资源)

- <listener>

- <listener-class>mondrian.web.taglib.Listener</listener-class>

- </listener>

-

- <!– 资源初始化-->

- <listener>

- <listener-class>com.tonbeller.tbutils.res.ResourcesFactoryContextListener</listener-class>

- </listener>

Print servlet,该servlet用于将数据生成Excel文件或pdf文件并返回给用户,如果您需要用到该功能,则需要将其copy到您项目的web.xml文件中

- <servlet>

- <servlet-name>Print</servlet-name>

- <display-name>Print</display-name>

- <description>Default configuration created for servlet.</description>

- <servlet-class>com.tonbeller.jpivot.print.PrintServlet</servlet-class>

- </servlet>

- <servlet-mapping>

- <servlet-name>Print</servlet-name>

- <url-pattern>/Print</url-pattern>

- </servlet-mapping>

MDXQueryServlet用于接受并执行一个MDX查询,然后将该查询以Html表格的形式返回。其中的参数connectString用于指定连接到数据库的字符串,例如使用jtds驱动连接到sql server 2000的字符串如下:

Provider=mondrian;Jdbc=jdbc:jtds:sqlserver://localhost/Tezz;user=sa;password=123456;Catalog=/WEB-INF/queries/tezz.xml;JdbcDrivers=net.sourceforge.jtds.jdbc.Driver;

如果您需要用到该功能,则需要将其copy到您项目的web.xml文件中。

- <servlet>

- <servlet-name>MDXQueryServlet</servlet-name>

- <servlet-class>mondrian.web.servlet.MDXQueryServlet</servlet-class>

- <init-param>

- <param-name>connectString</param-name>

- <param-value>@mondrian.webapp.connectString@</param-value>

- </init-param>

- </servlet>

- <servlet-mapping>

- <servlet-name>MDXQueryServlet</servlet-name>

- <url-pattern>/mdxquery</url-pattern>

- </servlet-mapping>

DisplayChart 和GetChart 这两个Servlet 用于生成图表和将其显示给最终用户,如果您需要用到该功能,则需要将其copy到您项目的web.xml文件中。

- <!-- jfreechart provided servlet -->

- <servlet>

- <servlet-name>DisplayChart</servlet-name>

- <servlet-class>org.jfree.chart.servlet.DisplayChart</servlet-class>

- </servlet>

- <!-- jfreechart provided servlet -->

- <servlet>

- <servlet-name>GetChart</servlet-name>

- <display-name>GetChart</display-name>

- <description>Default configuration created for servlet.</description>

- <servlet-class>com.tonbeller.jpivot.chart.GetChart</servlet-class>

- </servlet>

- <servlet-mapping>

- <servlet-name>DisplayChart</servlet-name>

- <url-pattern>/DisplayChart</url-pattern>

- </servlet-mapping>

- <servlet-mapping>

- <servlet-name>GetChart</servlet-name>

- <url-pattern>/GetChart</url-pattern>

- </servlet-mapping>

它们用于向用户生成和显示如下所示的各种图表:

最后添加以下标签库到我们的web.xml项目中即可

- <taglib>

- <taglib-uri>http://www.tonbeller.com/wcf</taglib-uri>

- <taglib-location>/WEB-INF/wcf/wcf-tags.tld</taglib-location>

- </taglib>

-

- <taglib>

- <taglib-uri>http://www.tonbeller.com/jpivot</taglib-uri>

- <taglib-location>/WEB-INF/jpivot/jpivot-tags.tld</taglib-location>

- </taglib>

到这里,您应该对mondrian在web.xml的配置有一定的了解,并可按需要添加相应的功能。

接下来我们将要创建本例子所要用到的表格及数据。

2.6 准备测试用表

本例使用的表结构如下所示:

Sale是事实表,它有两个维:客户(customer)维和由两个表组成的产品(Product)维。

表格的创建很简单,您只需要将下面的sql语句导入数据库即可

2.6.1 使用以下sql语句创建表

- /**销售表*/

- create table Sale (

- saleId int not null,

- proId int null,

- cusId int null,

- unitPrice float null, --单价

- number int null, --数量

- constraint PK_SALE primary key (saleId)

- )

- /**用户表*/

- create table Customer (

- cusId int not null,

- gender char(1) null, --性别

- constraint PK_CUSTOMER primary key (cusId)

- )

- /**产品表*/

- create table Product (

- proId int not null,

- proTypeId int null,

- proName varchar(32) null,

- constraint PK_PRODUCT primary key (proId)

- )

- /**产品类别表*/

- create table ProductType (

- proTypeId int not null,

- proTypeName varchar(32) null,

- constraint PK_PRODUCTTYPE primary key (proTypeId)

- )

2.6.2 使用以下sql语句导入数据

- insert into Customer(cusId,gender) values(1,'F')

- insert into Customer(cusId,gender) values(2,'M')

- insert into Customer(cusId,gender) values(3,'M')

- insert into Customer(cusId,gender) values(4,'F')

- insert into producttype(proTypeId,proTypeName) values(1,'电器')

- insert into producttype(proTypeId,proTypeName) values(2,'数码')

- insert into producttype(proTypeId,proTypeName) values(3,'家具')

- insert into product(proId,proTypeId,proName) values(1,1,'洗衣机')

- insert into product(proId,proTypeId,proName) values(2,1,'电视机')

- insert into product(proId,proTypeId,proName) values(3,2,'mp3')

- insert into product(proId,proTypeId,proName) values(4,2,'mp4')

- insert into product(proId,proTypeId,proName) values(5,2,'数码相机')

- insert into product(proId,proTypeId,proName) values(6,3,'椅子')

- insert into product(proId,proTypeId,proName) values(7,3,'桌子')

- insert into sale(saleId,proId,cusId,unitPrice,number) values(1,1,1,340.34,2)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(2,1,2,140.34,1)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(3,2,3,240.34,3)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(4,3,4,540.34,4)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(5,4,1,80.34,5)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(6,5,2,90.34,26)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(7,6,3,140.34,7)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(8,7,4,640.34,28)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(9,6,1,140.34,29)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(10,7,2,740.34,29)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(11,5,3,30.34,28)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(12,4,4,1240.34,72)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(13,3,1,314.34,27)

- insert into sale(saleId,proId,cusId,unitPrice,number) values(14,3,2,45.34,27)

2.7 建立模式(schema)文件

一个模式定义了一个多维数据库. 它包含一个逻辑模型(logical model)、一组数据立方(consisting of cubes)、层次(hierarchies)、和成员(members), 并映射到物理模型(关系数据库)上。

简单的说,配置一个模式就是配置一个关系数据结构到多维数据结构的映射。

注:关于mondrian的模式及模式的配置,您可以通过阅读mondrian的基本模式.pptx来了解。这里我们只对其进行了简单介绍。

2.7.1 创建模式文件:

模式文件的创建很简单。首先在WEB-INF下新建一个queries的文件夹,然后在该文件夹下创建一个名为tezz.xml的文件。再按下面的步骤将xml元素添加入即可。

2.7.2 配置模式文件:

2.7.2.1 添加数据立方Sales:

2.7.2.2 添加数据立方Sales的维:

添加产品维(因为产品维由两个表连接而成,因此比客户维复杂些):

添加度量(共有三个度量:数量、平均单价和总销售额):

最后生成的tezz.xml文件内容如下:

- <?xml version="1.0" encoding="UTF-8"?>

- <Schema name="tezz">

- <Cube name="Sales">

- <!-- 事实表(fact table) -->

- <Table name="sale" />

- <!-- 客户维 -->

- <Dimension name="客户性别" foreignKey="cusId">

- <Hierarchy hasAll="true" allMemberName="所有性别" primaryKey="cusId">

- <Table name="Customer"></Table>

- <Level name="gender" column="gender"></Level>

- </Hierarchy>

- </Dimension>

- <!-- 产品类别维 -->

- <Dimension name="产品类别" foreignKey="proId">

- <Hierarchy hasAll="true" allMemberName="所有产品" primaryKey="proId" primaryKeyTable="product">

- <join leftKey="proTypeId" rightKey="proTypeId">

- <Table name="product" />

- <Table name="producttype"></Table>

- </join>

- <Level name="proTypeId" column="proTypeId"

- nameColumn="proTypeName" uniqueMembers="true" table="producttype" />

- <Level name="proId" column="proId" nameColumn="proName"

- uniqueMembers="true" table="product" />

- </Hierarchy>

- </Dimension>

- <Measure name="数量" column="number" aggregator="sum" datatype="Numeric" />

- <Measure name="总销售额" aggregator="sum" formatString="¥#,##0.00">

- <!-- unitPrice*number所得值的列 -->

- <MeasureExpression>

- <SQL dialect="generic">(unitPrice*number)</SQL>

- </MeasureExpression>

- </Measure>

- <CalculatedMember name="平均单价" dimension="Measures">

- <Formula>[Measures].[总销售额] / [Measures].[数量]</Formula>

- <CalculatedMemberProperty name="FORMAT_STRING" value="¥#,##0.00" />

- </CalculatedMember>

- </Cube>

- </Schema>

2.8 编写MDX查询语句

在模式文件定义完成之后,我们就可以根据它来编写相应MDX查询语句了。

本例所用的MDX语句如下:

2.9 创建查询文件

现在我们将创建一个jsp文件,该jsp使用jpivot的mondrianQuery标签来完成查询。

该文件最后将被testpage.jsp使用。

在/WEB-INF/queries文件夹下面创建一名为tezz的jsp文件。该jsp包含如下内容:

2.10 布署项目

至此我们已经全部配置完成,文件结构如下:

布署项目,启动Tomcat,在浏览器上输入http://localhost:8080/Tezz/testpage.jsp?query=tezz即可看到如下结果:

注:testpage.jsp?query=tezz,这里的tezz即刚我们创建的用于查询jsp文件名称

3. testpage.jsp的流程

testpage.jsp文件用于发出查询及将结果转换成html格式。它使用一组jsp标签来完成这些复杂的工作。

在本教程的最后一章里,我们对testpage.jsp的流程及用到的主要标签进行简单介绍。

3.1 wcf:include标签:

3.2 jp:table标签:

<jp:table id="table01" query="#{query01}"/>

jp:table根据query01中保存的结果(领域数据)准备显示OLAP表格所需的数据(显示数据)

<wcf:render ref="table01" xslUri="/WEB-INF/jpivot/table/mdxtable.xsl"/>

根据table01的结果,使用mdxtable.xsl中的配置,渲染出OLAP表格。

3.3 其他jp、wcf标签

同样,其他jp标签,如<jp:chart id=“chart01“ ---/>等标签准备待渲染的数据,再由相应的<wcf:render ref=“chart01” ---/>标签将它们渲染成html格式。

这样,用户将在浏览器上看到最终的结果。

至此,一个完整的mondrian查询结束。

http://blog.csdn.net/ozwarld/article/details/7735915

IBM MQ 6.0中设置两个队列,(远程队列、通道之类都不设置)。

队列管理器是XIR_QM_1502

队列名称是ESBREQ

IP地址是10.23.117.134(远程的一台电脑,跟我的电脑不在一个局域网内)

端口1414

CCSID 1208

MQ配置可以参考这个,有配图http://wenku.baidu.com/view/06d108d0360cba1aa811daa3.html

程序如下,发送线程两个,接收线程一个。接收完毕后就结束。

运行结果如下:

进入线程Sender2

进入线程Sender

Sender2 Connecting to queue manager: XIR_QM_1502

Sender Connecting to queue manager: XIR_QM_1502

Sender2 Accessing queue: ESBREQ

Sender2 Sending a message...

Sender Accessing queue: ESBREQ

Sender Sending a message...

Sender2 putting the message... 1

Sender putting the message... 1

Sender2 putting the message... 2

Sender putting the message... 2

Sender2 putting the message... 3

Sender putting the message... 3

Sender2 putting the message... 4

Sender putting the message... 4

Sender2 Done!

==========

Sender Done!

==========

进入线程Receiver

Receiver Connecting to queue manager: XIR_QM_1502

Receiver Accessing queue: ESBREQ

... Receiver getting the message back again

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 1

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 1

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 2

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 2

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 3

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 3

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 4

ID: MSGID Num: 1 Type: 1 Flag: 0

The message is: Salemetsizbe Yerasel 4

Receiver Closing the queue

Receiver Disconnecting from the Queue Manager

Receiver Done!

2013 年 3 月 11 日 – 09:41 | 2,420 views |  收藏

收藏 PDO_MYSQL以下操作都在Linux 系统下操作

1、下载 文件 或者 进入 在PHP源码包中进入ext/pdo_mysql

http://pecl.php.net/get/PDO_MYSQL-1.0.2.tgz

2、解压文件

tar zxvf PDO_MYSQL-1.0.2.tgz

3、配置和编译文件

#cd PDO_MYSQL-1.0.2

#/usr/local/php5/bin/phpize

#./configure –with-php-config=/usr/local/php5/bin/php-config –with-pdo-mysql=/usr/local/mysql

#make

#make install

注: 我的PHP安装在 : /usr/local/php5/ mysql 安装在 : /usr/local/mysql 编译的时候注意你自己的安装目录在哪里

3、安装到PHP配置下

把这个记住,然后打开 php.ini文件,

并添加一行

extension=pdo_mysql.so

并将上面编译产生的so复制到 php.ini文件中extension_dir指定的目录中

重新启动!

说明:

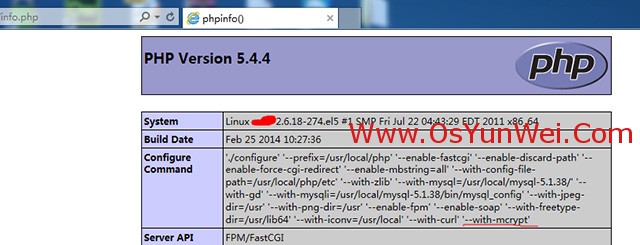

操作系统:CentOS 5.x 64位

已安装php版本:php-5.4.4

已安装php路径:/usr/local/php

实现目的:

在不影响网站访问的情况下,重新编译php,增加对mcrypt扩展的支持

具体操作:

一、下载软件包

1、下载php(版本要与系统安装的一致)

http://museum.php.net/php5/php-5.4.4.tar.gz

2、下载libmcrypt(安装mcrypt需要此软件包)

http://nchc.dl.sourceforge.net/project/mcrypt/Libmcrypt/2.5.8/libmcrypt-2.5.8.tar.gz

3、下载mhash(安装mcrypt需要此软件包)

https://acelnmp.googlecode.com/files/mhash-0.9.9.9.tar.gz

4、下载mcrypt

https://lcmp.googlecode.com/files/mcrypt-2.6.8.tar.gz

以上软件包下载之后,上传到/usr/local/src目录

二、安装软件包

1、安装libmcrypt

cd /usr/local/src #进入软件包存放目录

tar zxvf libmcrypt-2.5.8.tar.gz #解压

cd libmcrypt-2.5.8 #进入安装目录

./configure #配置

make #编译

make install #安装

2、安装mhash

cd /usr/local/src

tar zxvf mhash-0.9.9.9.tar.gz

cd mhash-0.9.9.9

./configure

make

make install

3、安装mcrypt

cd /usr/local/src

tar zxvf mcrypt-2.6.8.tar.gz

cd mcrypt-2.6.8

ln -s /usr/local/bin/libmcrypt_config /usr/bin/libmcrypt_config #添加软连接

export LD_LIBRARY_PATH=/usr/local/lib:$LD_LIBRARY_PATH #添加环境变量

./configure

make

make install

三、重新编译php

1、查看系统之前安装的php编译参数

系统运维 www.osyunwei.com 温馨提醒:qihang01原创内容 版权所有,转载请注明出处及原文链接

/usr/local/php/bin/php -i |grep configure #查看php编译参数,记录下编译参数,后面会用到

2、安装php

cd /usr/local/src

tar zxvf php-5.4.4.tar.gz

cd php-5.4.4

'./configure' '--prefix=/usr/local/php' '--enable-mbstring=all' '--with-config-file-path=/usr/local/php/etc' '--with-zlib' '--with-mysql=/usr/local/mysql-5.1.38/' '--with-gd' '--with-mysqli=/usr/local/mysql-5.1.38/bin/mysql_config' '--with-jpeg-dir=/usr' '--with-png-dir=/usr' '--enable-fpm' '--enable-soap' '--with-freetype-dir=/usr/lib64' '--with-iconv=/usr/local' '--with-curl' '--with-mcrypt'

#在之前的编译参数后面增加'--with-mcrypt' 回车

make #编译

make install #安装

/usr/local/src/php-5.4.4/sapi/fpm/init.d.php-fpm reload #重新加载php-fpm

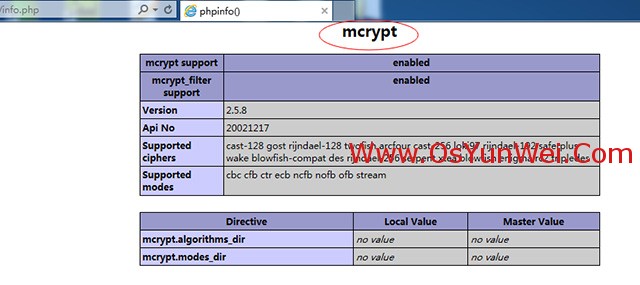

四、测试mcrypt扩展是否已安装成功

在网站目录下新建一个info.php测试页面,写上下面代码,保存

<?php

phpinfo();

?>

在浏览器中打开info.php 会看到如下的信息

说明mcrypt扩展已经安装成功

至此,Linux下php安装mcrypt扩展完成。

注册表中查看outlook临时目录

HK_CURRENT_USER\software\microsoft\Office\11.0\Outlook\Security\OutlookSecureTempFolder

查看键值 OutlookSecureTempFolder

C:\Documents and Settings\li.shi\Local Settings\Temporary Internet Files\OLK11\

删除临时目录下文件即可

RedHat Linux6.0安装Oracle 11g单机

Ø 第一步配置YUM仓库

1、 挂载光盘

mount /dev/cdrom /media

2、 复制光盘里头的rpm包到rpm包源目录

cp –rf /media/Packages /mnt (也可以直接通过桌面COPY)

(这里可以取消挂在了 umount /dev/cdrom,顺便删除media目录 rm –rf /media)

3、 进入你自己创建的YUM仓库,并安装createrepo工具

cd /mnt/Packages

rpm –ivh createrepo-0.4.11-3.e15.noarch.rpm(可以在桌面手动双击安装)

4、 重建仓库信息配置文件

createrepo /mnt (这个配置文件在 /mnt/repodata/下)

5、 创建YUM配置文件

cd /etc/yum.repos.d/

touch yumredhat.repo

vim yumredhat.repo

添加如下信息:

[rhel6]

name=Red Hat Enterprise Linux6

baseurl=file:///mnt

enabled=1

gpgcheck=0

gpgfile=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release

6、测试

yum list

yum clear all

Ø 第二步Oracle安装前系统参数的配置以及包的安装

(安装Oracle必须关闭掉防火墙以及selinux)

service iptables stop

vim /etc/selinux/config

SELINUX=disabled

========================

想办法把下面2个文件传进 Linux 操作系统里面去

linux_11gR2_database_1of2.zip

linux_11gR2_database_2of2.zip

要借助一个软件 FileZilla_3.3.3_win32-setup.exe

上传完毕后, 使用 unzip 命令解压刚才上传的2个文件, 命令格式如下:

unzip 文件名

======================================

检查相关的开发工具和一些包

检查命令格式如下:

rpm -qa | grep 名字

binutils-2.17.50.0.6

compat-libstdc++-33-3.2.3

elfutils-libelf-0.125

elfutils-libelf-devel-0.125

#elfutils-libelf-devel-static-0.125 (RedHat Linux6.0中无此包,CentOS中有)

gcc-4.1.2

gcc-c++-4.1.2

glibc-2.5-24

glibc-common-2.5

glibc-devel-2.5

glibc-headers-2.5

kernel-headers-2.6.18

ksh-20060214

libaio-0.3.106

libaio-devel-0.3.106

libgcc-4.1.2

libgomp-4.1.2

libstdc++-4.1.2

libstdc++-devel-4.1.2

make-3.81

numactl-devel-0.9.8.i386

sysstat-7.0.2

unixODBC-2.2.11

unixODBC-devel-2.2.11

======================================

利用配置好的YUM仓库安装包

yum install (包名).rpm

创建用户以及修改配置参数

groupadd oinstall

groupadd dba

mkdir -p /u01/oracle //路径可修改,看实际的生产环节

添加一个oracle用户, 根目录是 /u01/oracle, 主的组是 oinstall 副的组是dba

useradd -g oinstall -G dba -d /u01/oracle oracle

cp /etc/skel/.bash_profile /u01/oracle

cp /etc/skel/.bashrc /u01/oracle

cp /etc/skel/.bash_logout /u01/oracle

为oracle用户设置密码 123456 /111111

passwd oracle

/]#ls -l

/]#chown -R oracle:oinstall u01

/]#ls -l

检查 nobody 是否存在 , id nobody

缺省存在的。如果不存在 # /usr/sbin/useradd -g nobody

========================================

vi /etc/sysctl.conf

fs.aio-max-nr = 1048576

fs.file-max = 6815744

kernel.shmall = 2097152

kernel.shmmax = 536870912

kernel.shmmni = 4096

kernel.sem = 250 32000 100 128

net.ipv4.ip_local_port_range = 9000 65500

net.core.rmem_default = 262144

net.core.rmem_max = 4194304

net.core.wmem_default = 262144

net.core.wmem_max = 1048586

-------------

vi /etc/security/limits.conf

oracle soft nproc 2047

oracle hard nproc 16384

oracle soft nofile 1024

oracle hard nofile 65536

------------

vi /etc/pam.d/login

session required pam_limits.so

=================================================

设置oracle 用户环境变量

su - oracle

pwd

ls -la

---------------

vi .bash_profile

ORACLE_BASE=/u01

ORACLE_HOME=$ORACLE_BASE/oracle

ORACLE_SID=ORCLTEST

PATH=$ORACLE_HOME/bin:$PATH:$HOME/bin

export ORACLE_BASE ORACLE_HOME ORACLE_SID PATH

===================================

mv database /u01/

cd /u01

ls -l

chown -R oracle:oinstall database/

===========

Ø 第三步正式开始安装.Oracle.11g.r2(图形界面安装)

使用oracle账号 登陆图形界面 进行安装

运行终端 Terminal

cd /u01/database

./runInstaller

运行./runInstaller【INS-06101】IP address of localhost could not be determined

Are you sure you want to continue?

这里需要指定一个IP与localhost

Vi /etc/hosts

#127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

10.110.12.132 ORCLDEV ORCLDEV.ELLINGTON

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

运行./runInstaller出现中文汉字为方框

在运行runinstaller之前,

export LANG=C

export LC_ALL=C

Installation Optiong

install database software only

Grid Options

Single instance database installation

Product Languages

English

Database Edition

Enterprise Edition (3.95)

Installation Location

Oracle Base: /u01

Software Loacation: /u01/oracle

提示: yes

Create Inventory

mkdir /oraInventory

chown -R oracle:oinstall oraInventory

Operating System Groups

Next

Prerequis ite Checks

Ignore All

Summary

Finish

Install Product

安装完毕, 提示执行 2个脚本

//root用户执行

/oraInventory/orainstRoot.sh

/u01/oracle/root.sh

直接按回车, 缺省值就可以

Finish

The installation of Oracle Database was successful

====================================

上面只是安装了软件, 数据库没有创建, 还有配置 监听器 Listener

netca

一直默认下一步 , 呵呵, 最后 Finish

ps -ef 可以查看Listener是否配置成功

-----------

dbca

一直 Next, Global Database Name 和 SID 都是输入 wilson

选择 User the Same.....All Accounts

密码: 123456

选择 Sample Schemas

Memory 内存分配,默认就可以了

Character Sets 选择 中文GBK Use Unicode(AL32UTF8)

然后一直 Next , 到最后 Finish

弹出一个 Confirmation , 点击 OK 就可以了, 然后自动进行安装

安装到目录 /u01/oradata/wilson

/u01/等等。。。 会发现多了很多文件。

[oracle@localhost ~]$ sqlplus /nolog

//中文字符显示?号解决方法

编辑并运行.bash_profile

export NLS_LANG=AMERICAN_AMERICA.UTF8

(如果是GBK

export NLS_LANG=american_america.ZHS16GBK)

export NLS_LANG=AMERICAN_AMERICA.ZHS16GBK

注销后生效

这样再重新进入sqlplus

已经不会是乱码。

SQL*Plus: Release 11.2.0.1.0 Production on Fri Jun 25 15:05:54 2010

Copyright (c) 1982, 2009, Oracle. All rights reserved.

SQL> conn / as sysdba

Connected to an idle instance.

出现错误

SQL> startup

查看当前用户的表名

SQL> select table_name from user_tables;

SQL> create table testUser( id integer,name char(10));

Table created.

SQL> insert into testUser values(0,'Jack');

1 row created.

SQL> commit;

Commit complete.

SQL> select * from testUser;

ID NAME

---------- ----------

0 Jack

关闭数据库

SQL> shutdown immediate

SQL> quit

SELECT TOP 10

[Total Cost] = ROUND(avg_total_user_cost * avg_user_impact * (user_seeks + user_scans),0)

, avg_user_impact

, TableName = statement

, [EqualityUsage] = equality_columns

, [InequalityUsage] = inequality_columns

, [Include Cloumns] = included_columns

FROM sys.dm_db_missing_index_groups g

INNER JOIN sys.dm_db_missing_index_group_stats s

ON s.group_handle = g.index_group_handle

INNER JOIN sys.dm_db_missing_index_details d

ON d.index_handle = g.index_handle

ORDER BY [Total Cost] DESC;

================================

CREATE NONCLUSTERED INDEX IX_Kq_RecordQk_QKRMan

ON Kq_RecordQk ([QKRMan])

include([COMP_CODE], [QKREMPID], [ApStatus])

http://www.itokit.com/2012/1018/74794.html

MySQL的max_connections参数用来设置最大连接(用户)数。每个连接

MySQL的用户均算作一个连接,max_connections的默认值为100。本文将讲解此参数的详细作用与性能影响。

max_connections配置参数的相关的特性

1、MySQL无论如何都会保留一个用于管理员(SUPER)登陆的连接,用于管理员连接数据库进行维护操作,即使当前连接数已经达到了max_connections。因此MySQL的实际最大可连接数为max_connections+1;

2、这个参数实际起作用的最大值(实际最大可连接数)为16384,即该参数最大值不能超过16384,即使超过也以16384为准;

3、增加max_connections参数的值,不会占用太多系统资源。系统资源(CPU、内存)的占用主要取决于查询的密度、效率等;

4、该参数设置过小的最明显特征是出现“Too many connections”错误;

如何去调整max_connections参数的值(有以下三个方法可调整)

调整此参数的方法有几种,既可以在编译的时候设置,也可以在MySQL配置文件 my.cnf 中设置,也可以直接使用命令调整并立即生效。

1、在编译的时候设置默认最大连接数

打开MySQL的源码,进入sql目录,修改mysqld.cc文件:

C/C++ Code复制内容到剪贴板

- {“max_connections”, OPT_MAX_CONNECTIONS,

- “The number of simultaneous clients allowed.”, (gptr*) &max_connections,

- (gptr*) &max_connections, 0, GET_ULONG, REQUIRED_ARG, 100, 1, 16384, 0, 1,

- 0},

红色的“100”即为该参数的默认值,修改为想要的数值,存盘退出。然后执行

C/C++ Code复制内容到剪贴板

- ./configure;make;make install

重新编译安装MySQL;注意,由于编译安装且修改了MySQL源码,此操作最好在安装MySQL之前进行;

2、在配置文件my.cnf中设置max_connections的值

打开MySQL配置文件my.cnf

- [root@www ~]# vi /etc/my.cnf

找到max_connections一行,修改为(如果没有,则自己添加),

max_connections = 1000

上面的1000即该参数的值。

3、实时(临时)修改此参数的值

首先登陆mysql,执行如下命令:

C/C++ Code复制内容到剪贴板

- [root@www ~]# mysql -uroot -p

然后输入MySQL Root的密码。

查看当前的Max_connections参数值:

- mysql> SELECT @@MAX_CONNECTIONS AS 'Max Connections';

设置该参数的值:

- mysql> set GLOBAL max_connections=1000;

(注意上面命令的大小写)

修改完成后实时生效,无需重启MySQL。

mysql的max_connections的总结

总体来说,该参数在服务器资源够用的情况下应该尽量设置大,以满足多个客户端同时连接的需求。否则将会出现类似“Too many connections”的错误。

SPComm的一点小诀窍 spcomm的问题导致数据丢失

2010-01-08 09:50:51| 分类: 串口 |字号 订阅

最近几天完成了BiasDAC的程序编写。调试的过程还算比较顺利,除了几个有点bt的小问题。其中一个困扰了我两三天的时间,今天上午终于将其解决。

由于BiasDAC是用RS232 Serial Port通信的,延用之前的程序,使用了Delphi的SPComm控件。在之前的使用中,SPComm控件一直工作正常,使用的是一般的string进行消息的传递。

而BiasDAC由于通信协议的限制,消息的发送使用的是hex方式,会用到从0x00到0xFF所有的这些字符。在调试中发现,发送0x11和0x13之后,SPComm的工作就会不正常。

首先是0x11发送之后,返回的0x11消息会被忽略;其次0x13发送之后,只能返回很有限的消息,而且似乎Serial Port就此关闭,如果再发送消息,就会造成Serial Port失去响应,只能通过重新启动计算机才能恢复。

后来上网上查询,原来不能正常处理0x11和0x13的问题早就存在,原因是SPComm空间中两个属性的存在。

OutX_XonXOffFlow/InX_XonXoffFlow:这个属性是指进行发送/接收时的软件握手标志,两个握手信号之间的数据被认为是通讯数据,收到握手信号后,通讯就中止了。

FOutx_XonXoffFlow := True;

FInx_XonXoffFlow := True;

默认的初始化中,这两个属性是默认开启的。

XOffChar/XOnChar:这是指握手的字节,默认的初始中,有

FXonChar := chr($11);

FXoffChar := chr($13);

至此,真相大白。0x11,0x13被占用为通讯握手信号,自然不会得到正确的处理。

问题找到了,解决也很容易。只需要在Comm的初始化中,自己定义

Comm.Inx_XonXoffFlow:=False;

Comm.Outx_XonXoffFlow:=False;

关闭软件握手功能即可。在一般通讯中,硬件已经具备了握手功能,所以也不会影响到正常的Comm通讯。

在通达OA2009中,“数据选择控件”目前只有自带的三种类型数据。

现增加第三方的数据来源,以增强其功能。

一、

MYOA\webroot\general\system\workflow\flow_form\cool_form\data\config.php在Config.php 增加

'TX_USERS' => array("NAME" => "同享系统用户" , "CONTENT" => array("EMP_NAME" => "工号姓名",

"DEPT_NAME" => "部门","ZHIWEI" => "职位","ZHIWU" => "职务","ZHIJI" => "职级"))

二、

MYOA\webroot\general\workflow\list\input_form

增加连接MSSQL-SERVER的输出

if ($dataSrc == 'TX_USERS') {

if($act=="count")

$query = "select count(*) from OA_Employee_View where 1=1";

else

$query = "select top 10 $dataField from OA_Employee_View where 1=1";

if(strstr($dataQuery,"1,"))

{

$array1 = explode(",",$dataQuery);

$array2 = explode(",",$dataField);

$array3 = explode(",",$dataFieldName);

foreach($array1 as $k => $v)

{

if($v==1)

{

$name = $array2[$k];

$value = $$name;

if($value!="")

$query .= " and $name like '%$value%'";

}

}

}

$txconn=mssql_connect($MSSQL_TX_SERVER,$MSSQL_TX_USER,$MSSQL_TX_PASS);

mssql_select_db($MSSQL_TX_DB,$txconn);

if($act=="count")

{

$cursor = mssql_query($query);

if($ROW=mssql_fetch_array($cursor))

$COUNT=$ROW[0];

echo $COUNT;

exit;

}

$cursor = mssql_query($query);

$COUNT=0;

$dataField_arr = explode(",",$dataField);

$dataFieldName_arr = explode(",",$dataFieldName);

while($ROW=mssql_fetch_array($cursor))

{

$COUNT++;

if($COUNT%2==1)

$TableLine="TableLine1";

else

$TableLine="TableLine2";

foreach($dataField_arr as $k=> $v)

{

if($v=="") continue;

if($COUNT==1)

{

if($k==0)

$thead.='<table class="TableList" align="center" width="90%"><tr class="TableHeader">';

$thead.='<td nowrap align="center">'.$dataFieldName_arr[$k].'</td>';

}

if($k==0)

$tbody.='<tr class="'.$TableLine.'">';

$tbody.='<td nowrap align="center">'.$ROW[$v].'</td>';

}

if($COUNT==1) $thead.='<td nowrap align="center">操作</td></tr>';

$tbody.='<td nowrap align="center"> <a href="#" class="orgAdd" onclick="addData(this)">添加</a></td></tr>';

}

$tbody.="</table>";

echo $thead.$tbody;

一、增加流程定义时可以选择项目

MYOA\webroot\general\system\workflow\flow_type\flow_design\view_list\edit.php

794行

<option value="11" <? if($AUTO_TYPE=="11")echo "selected";?>>按表单字段选择的直属上司</option>

\\10.110.2.210\d$\MYOA\webroot\general\workflow\list\turn\condition.php

765行处增加

}elseif($AUTO_TYPE==11) //根据表单字段的主属上司来处理

{

if(is_numeric($AUTO_USER))

{

$query3 = "SELECT ITEM_DATA from FLOW_RUN_DATA where RUN_ID='$RUN_ID' AND ITEM_ID='$AUTO_USER'";

$cursor3= exequery($connection,$query3);

if($ROW=mysql_fetch_array($cursor3))

$ITEM_DATA = $ROW["ITEM_DATA"];

$APPLY_USER_ID = substr($ITEM_DATA,strpos($ITEM_DATA,"_")-1);

//根据前一节点的直属上司

$query = "select EMP_MANAGECODE from user where user_id ='$APPLY_USER_ID'";

$cursor= exequery($connection,$query);

if($ROW=mysql_fetch_array($cursor))

{

$USER_ID=$ROW["EMP_MANAGECODE"];

$query1 = "SELECT * from USER where USER_ID='$USER_ID'";

$cursor1= exequery($connection,$query1);

if($ROW=mysql_fetch_array($cursor1))

{

$PRCS_NEW_USER_ID=$USER_ID;

$PRCS_NEW_USER_NAME=$ROW["USER_NAME"];

$PRCS_NEW_DEPT_ID=$ROW["DEPT_ID"];

$PRCS_NEW_USER_PRIV=$ROW["USER_PRIV"];

$PRCS_NEW_USER_PRIV_OTHER=$ROW["USER_PRIV_OTHER"];

}

}

$PRCS_OP_USER=$PRCS_NEW_USER_ID;

$PRCS_OP_USER_NAME=$PRCS_NEW_USER_NAME;

$PRCS_USER_AUTO=$PRCS_NEW_USER_ID.",";

$PRCS_USER_NAME=$PRCS_NEW_USER_NAME.",";

/*//检查该发起人是否有经办权限

if($PRCS_DEPT=="ALL_DEPT"||find_id($PRCS_USER,$PRCS_NEW_USER_ID)||find_id($PRCS_DEPT,$PRCS_NEW_DEPT_ID)||find_id($PRCS_PRIV,$PRCS_NEW_USER_PRIV)||priv_other($PRCS_PRIV,$PRCS_NEW_USER_PRIV_OTHER))

{

$PRCS_OP_USER=$PRCS_NEW_USER_ID;

$PRCS_OP_USER_NAME=$PRCS_NEW_USER_NAME;

$PRCS_USER_AUTO=$PRCS_NEW_USER_ID.",";

$PRCS_USER_NAME=$PRCS_NEW_USER_NAME.",";

}*/

}

}

3.在流程定义处保存的地方也要修改

MYOA\webroot\general\system\workflow\flow_type\flow_design\view_list\update.php

的66修改成:

if($AUTO_TYPE==7 || $AUTO_TYPE==11)

select * from sysprocesses

where dbid in (select dbid from sysdatabases where name='overtime')

and program_name ='PHP 5'

USE master

DECLARE @spid int

DECLARE CUR CURSOR

FOR SELECT spid FROM sysprocesses WHERE dbid = 11 and program_name ='PHP 5'

OPEN CUR

FETCH NEXT FROM CUR INTO @spid

WHILE @@FETCH_STATUS = 0

BEGIN

EXEC ('KILL ' + @spid )

FETCH NEXT FROM CUR INTO @spid

END

CLOSE CUR

DEALLOCATE CUR

1)interactive_timeout:

参数含义:服务器关闭交互式连接前等待活动的秒数。交互式客户端定义为在mysql_real_connect()中使用CLIENT_INTERACTIVE选项的客户端。

参数默认值:28800秒(8小时)

(2)wait_timeout:

参数含义:服务器关闭非交互连接之前等待活动的秒数。

在线程启动时,根据全局wait_timeout值或全局interactive_timeout值初始化会话wait_timeout值,取决于客户端类型(由mysql_real_connect()的连接选项CLIENT_INTERACTIVE定义)。

参数默认值:28800秒(8小时)

MySQL服务器所支持的最大连接数是有上限的,因为每个连接的建立都会消耗内存,因此我们希望客户端在连接到MySQL Server处理完相应的操作后,应该断开连接并释放占用的内存。如果你的MySQL Server有大量的闲置连接,他们不仅会白白消耗内存,而且如果连接一直在累加而不断开,最终肯定会达到MySQL Server的连接上限数,这会报'too many connections'的错误。对于wait_timeout的值设定,应该根据系统的运行情况来判断。在系统运行一段时间后,可以通过show processlist命令查看当前系统的连接状态,如果发现有大量的sleep状态的连接进程,则说明该参数设置的过大,可以进行适当的调整小些。

问题:

如果在配置文件my.cnf中只设置参数wait_timeout=100,则重启服务器后进入,执行:

Mysql> show variables like “%timeout%”;

会发现参数设置并未生效,仍然为28800(即默认的8个小时)。

查询资料后,要同时设置interactive_timeout和wait_timeout才会生效。

【mysqld】

wait_timeout=100

interactive_timeout=100

重启MySQL Server进入后,查看设置已经生效。

问题1:这里为什么要同时设置interactive_timeout,wait_timeout的设置才会生效?

问题2:interactive的值如果设置的和wait_timeout不同,为什么Interactive_timeout会覆盖wait_timeout?

问题3:在进行MySQL优化时,因为interactive_timeout决定的是交互连接的时间长短,而wait_timeout决定的是非交互连接的时间长短。如果在进行连接配置时mysql_real_connect()最后一个参数client_flag不设置为CLIENT_INTERACTIVE,是不是interactive_timeout的值不会覆盖wait_timeout?

问题4:为了减少长连接的数量,在设置优化时是不是可以将interactive_timeout的值设置的大些,而wait_timeout的值设置的小些?但是问题2的描述好像又不允许这样。。。

1、查询oracle被锁对象及其语句

SELECT a_s.owner,

a_s.object_name,

a_s.object_type,

VN.SID,

VN.SERIAL#,

VS.SPID "OS_PID",

VN.PROCESS "CLIENT_PID",

VN.USERNAME,

VN.OSUSER,

VN.MACHINE "HOSTNAME" ,

VN.TERMINAL,

VN.PROGRAM,

TO_CHAR(VN.LOGON_TIME,'YYYY-MM-DD HH24:MI:SS')"LOGIN_TIME",

'alter system kill session '''||vn.sid||','||vn.serial#||''';' "ORACKE_KILL",

'kill -9 '|| VS.SPID "OS_KILL"

FROM ALL_OBJECTS A_S,

V$LOCKED_OBJECT V_T,

V$SESSION VN,

V$PROCESS VS

WHERE A_S.OBJECT_ID=V_T.OBJECT_ID

AND V_T.SESSION_ID =VN.SID

AND VS.ADDR=VN.PADDR

AND VN.USERNAME NOT IN('SYSMAN','SYS');

|

2、查询该sid的sql语句

select * from v$sql vl,v$session vn

where vl.ADDRESS= decode(vn.SQL_ADDRESS,null,vn.PREV_SQL_ADDR,VN.SQL_ADDRESS)

and vn.sid=&sid;

|

3、解锁

alter system kill session 'sid,serial#';

|

4、查询被锁对象增强版

SELECT DDL.OWNER AS 用户,

DDL.NAME AS 对象,

DDL.type AS 类型,

VS.OSUSER AS OS_USER,

VS.MACHINE,

VS.STATUS,

VS.PROGRAM,

VS.LOGON_TIME AS "LOGIN_TIME",

VP.SPID,

'kill -9 ' || VP.SPID AS OS_KILL,

vs.sid,

vs.SERIAL#,

'alter system kill session ''' || vs.sid || ',' || vs.serial# ||

''';' "ORACKE_KILL"

FROM DBA_DDL_LOCKS DDL, V$SESSION VS, V$PROCESS VP

WHERE DDL.SESSION_ID = VS.SID

AND VS.PADDR = VP.ADDR;

|

在日常的sql server开发中,经常会用到Identity类型的标识列作为一个表结构的自增长编号。比如文章编号、记录序号等等。自增长的标识列的引用很大程度上方便了数据库程序的开发,但有时这个固执的字段类型也会带来一些麻烦。

一、修改标识列字段值:

有时,为了实现某种功能,需要修改类型为Identity自增长类型的字段的值,但由于标识列的类型所限,这种操作默认是不允许的。比如目前数据库有5条正常添加的数据,此时删除2条,那么如果再添加数据时,自增长的标识列会自动赋值为6,可这时如果想在插入数据时给赋值3呢,默认是不允许的。如果您特别想改变这个字段的值,完全由自己控制该标识字段值的插入,方法还是有的,哈哈。

SET IDENTITY_INSERT [TABLE] [ON|OFF]

使用上述语句,可以方便的控制某个表的某个自增长标识列是否自动增长,也就是说是否允许你在insert一条记录时手动指定标识列字段的值。如果指定为on,则可以insert时指定标识列字段的值,该值不自动增长赋值。当然,如果使用完毕,还需使用这个语句将开关关闭到默认状态off,不然下次insert数据时该字段还是不会自动增长赋值的,有始有终嘛。

如:

SET IDENTITY_INSERT [TABLE_NAME] ON

----------- INSERT SEG--------

SET IDENTITY_INSERT [TABLE_NAME] OFF

二、重置标识列字段值:

当数据记录被删除一部分后,后面再添加的新数据记录,标识列数值会有很大的空闲间隔,看上去是不是很不爽呢。即使你删除表中全部记录,identity标识列的值还是会无休止的自动增加变大,而不是从头开始增长。通过下面这条语句可以重置自增长字段的种子值:

DBCC CHECKIDENT(TABLE, [RESEED|NORESEED], 200)上述语句将把指定表的种子值强制重设为1。然而,如果你不想将种子重设为1,你可以用你想用的种子值替代第三个参数。如果你想知道当前的种子,而不是想重设标识种子,这时你就要用NORESEED,而不用再去设置第三个参数。

如 DBCC CHECKIDENT(Product, RESEED, 210)

测试人:QQ -- 35629400 子夜时分,如有错误,请指出。

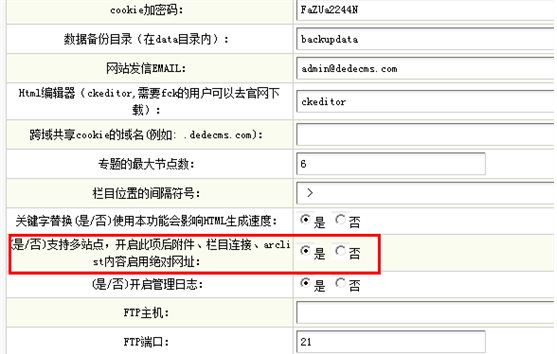

环境:Win7+Phpnow+V57_UTF8_SP1(2013-6-7版本)

一、系统设置

1.【后台管理】--》【系统】--》【核心设置】,红色区域设置成“是”

2.【后台管理】--》【核心】--》【网站栏目管理】--》选择一个顶级栏目进行修改。

在【高级选项】中“启用”【多站点支持】

在【绑定域名】中输入所要的域名,如:http://webbase.chugui.com

二、Apache中设置

打开Apache的虚拟主机配置文件。

如我的文件在:D:\Phpnow\Apache-22\conf\extra\httpd-vhosts.conf

<Directory ../vhosts>

AllowOverride All

Order allow,deny

Allow from all

</Directory>

NameVirtualHost * #这个必须有

<VirtualHost *>

DocumentRoot ../htdocs

ServerName default:80

ErrorLog logs/default-error_log

</VirtualHost>

<VirtualHost *>

<Directory "D:/Phpnow/htdocs/dedecms">

Options -Indexes FollowSymLinks

Allow from all

AllowOverride All

</Directory>

ServerAdmin admin@ww2.chugui.com

DocumentRoot "D:/Phpnow/htdocs/dedecms"

ServerName ww2.chugui.com:80

ServerAlias *.ww2.chugui.com

ErrorLog logs/ww2.chugui.com-error_log

php_admin_value open_basedir "D:\Phpnow\htdocs\dedecms;C:\Windows\Temp;"

</VirtualHost>

<VirtualHost *>

<Directory "D:/Phpnow/htdocs/dedecms/html/webbase">

Options -Indexes FollowSymLinks

Allow from all

AllowOverride All

</Directory>

ServerAdmin admin@webbase.chugui.com

DocumentRoot "D:/Phpnow/htdocs/dedecms/html/webbase"

ServerName webbase.chugui.com:80 #二级域名指定处

ErrorLog logs/webbase.chugui.com-error_log

php_admin_value open_basedir "D:\Phpnow\htdocs\dedecms\html\webbase;C:\Windows\Temp;"

</VirtualHost>

三、如果公网上做以上两步就行了,为了在本地测试,需要修改host文件。

在文件中加入以下几行:(目的告诉浏览器以下地址不用去公网上解析)

127.0.0.1 ww2.chugui.com

127.0.0.1 chugui.com

127.0.0.1 webbase.chugui.com

四、针对网上有些人说要修改channelunit.help.php里面的内容,否则会现部门分js,css有引用的问题,我没有修改,貌似也没有发现错。这个有待后期考证。

//是否强制使用绝对网址

if($GLOBALS['cfg_multi_site']=='Y')

{

if($siteurl=='')

{

$siteurl = $GLOBALS['cfg_basehost'];

}

if($moresite==1)

{

$articleUrl = preg_replace("#^".$sitepath."#", '', $articleUrl);

}

if(!preg_match("/http:/", $articleUrl))

{

$articleUrl = $siteurl.$articleUrl;

}

}

五、至此查看结果如下:

六、

广州白马档口出租

番禺大石空调维修中心

重启dbmail

EXEC msdb.dbo.sysmail_stop_sp

EXEC msdb.dbo.sysmail_start_sp

http://social.msdn.microsoft.com/Forums/en-US/sqldatabaseengine/thread/fabfecfe-f493-4628-a355-79a4322ca7e1/

广州白马档口出租

番禺大石空调维修中心

package com.ellington.test;

import java.io.FileInputStream;

import java.io.FileOutputStream;

import java.io.IOException;

import java.io.InputStream;

import java.io.OutputStream;

import java.util.Date;

import java.util.Properties;

import javax.mail.BodyPart;

import javax.mail.Message;

import javax.mail.MessagingException;

import javax.mail.Multipart;

import javax.mail.Session;

import javax.mail.Transport;

import javax.mail.internet.InternetAddress;

import javax.mail.internet.MimeBodyPart;

import javax.mail.internet.MimeMessage;

import javax.mail.internet.MimeMultipart;

import sun.misc.BASE64Decoder;

import sun.misc.BASE64Encoder;

public class Mailer {

private String host;

private String auth;

private String username;

private String domainUser;

private String password;

public boolean send(String[] to, String[] cc, String[] bcc, String subject, String content) throws MessagingException {

Properties props = new Properties();

props.put("mail.smtp.host", host);

props.put("mail.smtp.auth", auth);

Session s = Session.getInstance(props);

// s.setDebug(true);

MimeMessage message = new MimeMessage(s);

InternetAddress from = new InternetAddress(username);

message.setFrom(from);

InternetAddress[] Toaddress = new InternetAddress[to.length];

for (int i = 0; i < to.length; i++)

Toaddress[i] = new InternetAddress(to[i]);

message.setRecipients(Message.RecipientType.TO, Toaddress);

if (cc != null) {

InternetAddress[] Ccaddress = new InternetAddress[cc.length];

for (int i = 0; i < cc.length; i++)

Ccaddress[i] = new InternetAddress(cc[i]);

message.setRecipients(Message.RecipientType.CC, Ccaddress);

}

if (bcc != null) {

InternetAddress[] Bccaddress = new InternetAddress[bcc.length];

for (int i = 0; i < bcc.length; i++)

Bccaddress[i] = new InternetAddress(bcc[i]);

message.setRecipients(Message.RecipientType.BCC, Bccaddress);

}

message.setSubject(subject);

message.setSentDate(new Date());

BodyPart mdp = new MimeBodyPart();

mdp.setContent(content, "text/html;charset=utf-8");

Multipart mm = new MimeMultipart();

mm.addBodyPart(mdp);

message.setContent(mm);

message.saveChanges();

Transport transport = s.getTransport("smtp");

transport.connect(host, (null == domainUser) ? username : domainUser, password);

transport.sendMessage(message, message.getAllRecipients());

transport.close();

return true;

}

public Mailer(String host, String auth, String domainUser, String username, String password) {

super();

this.host = host;

this.auth = auth;

this.domainUser = domainUser;

this.username = username;

this.password = password;

}

/**

* @param args

* @throws MessagingException

*/

public static void main(String[] args) throws MessagingException {

// TODO Auto-generated method stub

System.out.println(GetImageStr());

new Mailer("10.110.4.4", "false", "abc\\sysadmin", "sysadmin@abc.com", "sysadmin").send(new String[] { "G@abc.com","F@abc.com" }, null, null, "邮件中发送文字与图片", "<h3>hello html5</h3><img src=\"data:image/png;base64,"+GetImageStr()+"\">" );

}

public static String GetImageStr()

{//将图片文件转化为字节数组字符串,并对其进行Base64编码处理

String imgFile = "d:\\111.jpg";//待处理的图片

InputStream in = null;

byte[] data = null;

//读取图片字节数组

try

{

in = new FileInputStream(imgFile);

data = new byte[in.available()];

in.read(data);

in.close();

}

catch (IOException e)

{

e.printStackTrace();

}

//对字节数组Base64编码

BASE64Encoder encoder = new BASE64Encoder();

return encoder.encode(data);//返回Base64编码过的字节数组字符串

}

public static boolean GenerateImage(String imgStr)

{//对字节数组字符串进行Base64解码并生成图片

if (imgStr == null) //图像数据为空

return false;

BASE64Decoder decoder = new BASE64Decoder();

try

{

//Base64解码

byte[] b = decoder.decodeBuffer(imgStr);

for(int i=0;i<b.length;++i)

{

if(b[i]<0)

{//调整异常数据

b[i]+=256;

}

}

//生成jpeg图片

String imgFilePath = "d:\\222.jpg";//新生成的图片

OutputStream out = new FileOutputStream(imgFilePath);

out.write(b);

out.flush();

out.close();

return true;

}

catch (Exception e)

{

return false;

}

}

}

广州白马档口出租

番禺大石空调维修中心

1.查看系统当前时间

>date

2.修改正确的时间

>date 04180819 ==4月18号8点19分

>确认当前时间:

>clock -w

广州白马档口出租

番禺大石空调维修中心

http://www.centos.bz/2011/03/auto-run-task-crontab/

1.进行编辑

>crontab -e

*/10 * * * * /usr/bin/wget -q -O /usr/local/oataskrun.log http://10.110.8.41:81/task/pe_geber_remind.php

每10钟执行一次任务。

>service crond restart 重启服务使其生效。

crontab简介

crontab命令常见于Unix和类Unix的操作系统之中,用于设置周期性被执行的指令。该命令从标准输入设备读取指令,并将其存放于 “crontab”文件中,以供之后读取和执行。该词来源于希腊语 chronos(χρόνος),原意是时间。 通常,crontab储存的指令被守护进程激活, crond常常在后台运行,每一分钟检查是否有预定的作业需要执行。这类作业一般称为cron jobs。

crontab用法

crontab的格式如下面:

f1 f2 f3 f4 f5 program

其中 f1 是表示分钟,f2 表示小时,f3 表示一个月份中的第几日,f4 表示月份,f5 表示一个星期中的第几天。program 表示要执行程式的路径。

- 当 f1 为 * 时表示每分钟都要执行 program,f2 为 * 时表示每小时都要执行程式,其余类推

- 当 f1 为 a-b 时表示从第 a 分钟到第 b 分钟这段时间内要执行,f2 为 a-b 时表示从第 a 到第 b 小时都要执行,其余类推

- 当 f1 为 */n 时表示每 n 分钟个时间间隔执行一次,f2 为 */n 表示每 n 小时个时间间隔执行一次,其余类推

- 当 f1 为 a, b, c,… 时表示第 a, b, c,… 分钟要执行,f2 为 a, b, c,… 时表示第 a, b, c…个小时要执行,其余类推

管理员登录SSH,输入命令crontab -e编辑crontab文件,根据上面的格式输入并保存。

crontab例子

每月每天每小时的第 0 分钟执行一次 /bin/ls :

在 12 月内, 每天的早上 6 点到 12 点中,每隔 20 分钟执行一次 /usr/bin/backup :

- */20 6-12 * 12 * /usr/bin/backup

周一到周五每天下午 5:00 寄一封信给 alex@domain.name :

- 0 17 * * 1-5 mail -s "hi" alex@domain.name < /tmp/maildata

每月每天的午夜 0 点 20 分, 2 点 20 分, 4 点 20 分….执行 echo “haha”

- 20 0-23/2 * * * echo "haha"

晚上11点到早上8点之间每两个小时,早上8点

在hp unix,中,每20分钟执行一次,表示为:0,20,40 * * * * 而不能采用*/n方式,否则出现语法错误

crontab用法其实很容易掌握,懂得使用crontab,对网站和服务器维护起到很大的帮助,比如定时备份,定时优化服务器

前一段时间修改了主机的hostname,重启oracle是提示错误ORA-00119: invalid specification for system parameter LOCAL_LISTENER。

分析原因可能在于hostname进行了修改。

解决方法:

首先仍然是了解错误信息:oerr ora 00119

00119, 00000, "invalid specification for system parameter %s"

// *Cause: The syntax for the specified parameter is incorrect.

// *Action: Refer to the Oracle Reference Manual for the correct syntax.

既然参数出现错误,那么需要调整参数LOCAL_LISTENER

1、创建pfile:SQL>create pfile from spfile

2、修改pfile,pfile的命名方式为init$ORACLE_SID.ora,存储位置为$ORACLE_HOME/dbs,检查LOCAL_LISTENER这个参数,如果没有,则在最后一行添加:

*.local_listener='(ADDRESS_LIST=(ADDRESS=(PROTOCOL=TCP)(HOST=ip)))',此处的ip就是oracle数据库所在服务器的ip

3、修改完成后,保存退出

4、SQL>startup pfile='$ORACLE_HOME/dbs/init$ORACLE_SID.ora';

可以看到,数据库启动成功

5、重新创建spfile SQL>create spfile from pfile

--打开高级设置

EXEC sp_configure 'show advanced options', 1

RECONFIGURE

--打开xp_cmdshell扩展存储过程

EXEC sp_configure 'xp_cmdshell', 1

RECONFIGURE

exec master..xp_cmdshell 'net use I: \\10.110.2.192\e\sqlbackup

A /User:

B\

C'A:密码

B:域或工作组

C:登录名

--以上设定一次即可

把以下命令放到定时任务器中。

BACKUP DATABASE [MyDB] TO DISK = N'I:\MyDB.bak' WITH RETAINDAYS = 2, NOFORMAT, NOINIT, NAME = N'MyDBTest', SKIP, REWIND, NOUNLOAD, COMPRESSION, STATS = 10

---以下不用的时候删除所建的盘

--删除映射

exec master..xp_cmdshell 'net use I: /delete'

--关闭xp_cmdshell扩展存储过程、高级设置

EXEC sp_configure 'xp_cmdshell', 0

RECONFIGURE

EXEC sp_configure 'show advanced options', 0

RECONFIGURE

广州白马档口出租

番禺大石空调维修中心

http://www.cnblogs.com/sopost/archive/2011/10/22/2221498.htmlexec dbms_workload_repository.modify_snapshot_settings(interval=>0) ;//60分中为一小时,0是自动关闭

1.查看当前的AWR保存策略

select * from dba_hist_wr_control;

DBID,SNAP_INTERVAL,RETENTION,TOPNSQL

860524039,+00 01:00:00.000000,+07 00:00:00.000000,DEFAULT

以上结果表示,每小时产生一个SNAPSHOT,保留7天

2.调整AWR配置

AWR配置都是通过dbms_workload_repository包进行配置

2.1调整AWR产生snapshot的频率和保留策略,如:如将收集间隔时间改为30 分钟一次。并且保留5天时间(注:单位都是为分钟):

exec dbms_workload_repository.modify_snapshot_settings(interval=>30, retention=>5*24*60);

2.2关闭AWR,把interval设为0则关闭自动捕捉快照

2.3手工创建一个快照

exec DBMS_WORKLOAD_REPOSITORY.CREATE_SNAPSHOT ();

2.4 查看快照

select * from sys.wrh$_active_session_history

2.5手工删除指定范围的快照

exec WORKLOAD_REPOSITORY.DROP_SNAPSHOT_RANGE(low_snap_id => 22, high_snap_id => 32, dbid => 3310949047);

2.6创建baseline

exec dbms_workload_repository.create_baseline (56,59,'apply_interest_1')

2.7删除baseline

exec DBMS_WORKLOAD_REPOSITORY.DROP_BASELINE(baseline_name => ' apply_interest_1', cascade => FALSE);

3.生产AWR报告

$ORACLE_HOME/rdbms/admin/awrrpt.sql

4.1 Snapshots( 快照)

前面操作报表生成时,snap这个关键字已经出现过多次了,想必你对它充满了疑惑,这个东西是哪来的咋来的谁让它来的呢?事实上,Snap是Snapshot的简写,这正是AWR在自动性方面的体现,虽然你没有创建,但是AWR自动帮你创建了(当然也可以手动创建snapshot),并且是定时(每小时)创建,定期清除(保留最近7天)。

Snapshots 是一组某个时间点时历史数据的集合,这些数据就可被ADDM(Automatic Database Diagnostic Monitor)用来做性能对比。默认情况下,AWR能够自动以每小时一次的频率生成Snapshots性能数据,并保留7天,,如果需要的话,DBA可以通过DBMS_WORKLOAD_REPOSITORY过程手动创建、删除或修改snapshots。

提示:调用DBMS_WORKLOAD_REPOSITORY包需要拥有DBA权限。

4.1.1 手动创建Snapshots

手动创建Snapshots,通过DBMS_WORKLOAD_REPOSITORY.CREATE_SNAPSHOT过程,例如:

SQL> exec dbms_workload_repository.create_snapshot();

PL/SQL procedure successfully completed.

然后可以通过DBA_HIST_SNAPSHOT 视图查看刚刚创建的Snapshots信息。

4.1.2 手动删除Snapshots

删除Snapshots是使用DBMS_WORKLOAD_REPOSITORY包的另一个过程:DROP_SNAPSHOT_RANGE,该过程在执行时可以通过指定snap_id的范围的方式一次删除多个Snapshots,例如:

SQL> select count(0) from dba_hist_snapshot where snap_id between 7509 and 7518;

COUNT(0)

----------

10

SQL> begin

2 dbms_workload_repository.drop_snapshot_range(

3 low_snap_id => 7509,

4 high_snap_id => 7518,

5 dbid => 3812548755);

6 end;

7 /

PL/SQL procedure successfully completed.

SQL> select count(0) from dba_hist_snapshot where snap_id between 7509 and 7518;

COUNT(0)

----------

注意当snapshots被删除的话,与其关联的ASH记录也会级联删除。

4.1.3 修改Snapshots设置

通过MODIFY_SNAPSHOT_SETTINGS过程,DBA可以调整包括快照收集频率、快照保存时间、以及捕获的SQL数量三个方面的设置。分别对应MODIFY_SNAPSHOT_SETTINGS的三个参数:

- Retention :设置快照保存的时间,单位是分钟。可设置的值最小为1天,最大为100年。设置该参数值为0的话,就表示永久保留收集的快照信息。

- Interval :设置快照收集的频率,以分钟为单位。可设置的值最小为10分钟,最大为1年。如果设置该参数值为0,就表示禁用AWR特性。

- Topnsql :指定收集的比较占用资源的SQL数量,可设置的值最小为30,最大不超过100000000。

查看当前快照收集的相关设置,可以通过DBA_HIST_WR_CONTROL视图查看,例如:

SQL> select * from dba_hist_wr_control;

DBID SNAP_INTERVAL RETENTION TOPNSQL

---------- ------------------------ -------------------- ----------

3812548755 +00000 01:00:00.0 +00007 00:00:00.0 DEFAULT

又比如通过MODIFY_SNAPSHOT_SETTTINGS过程修改snap_intrval的设置:

SQL> exec dbms_workload_repository.modify_snapshot_settings(interval=>120);

PL/SQL procedure successfully completed.

SQL> select * from dba_hist_wr_control;

DBID SNAP_INTERVAL RETENTION TOPNSQL

---------- ------------------------ -------------------- ----------

3812548755 +00000 02:00:00.0 +00007 00:00:00.0 DEFAULT

4.2 Baselines( 基线)

Baseline ,直译的话叫做基线,顾名思义的方式理解,就是用于比较的基本线。因为Baseline中包含指定时间点时的性能数据,因此就可以用来与其它时间点时的状态数据做对比,以分析性能问题。

创建Baseline时,Snapshots是做为其中的一个组成部分存在,因此一般来说当AWR自动维护快照时,如果定义过baseline,与baseline相关的快照不会被删除,即使是过期的快照,这样就相当于手动保留了一份统计数据的历史信息,DBA可以在适当的时间将其与现有的快照进行对比,以生成相关的统计报表。

用户可以通过DBMS_WORKLOAD_REPOSITORY包中的相关过程,手动的创建或删除Baseline。

4.2.1 创建Baseline

创建Baseline使用CREATE_BASELINE过程,执行该过程时分别指定开始和结果的snap_id,然后为该baseline定义一个名称即可,例如:

SQL> BEGIN

2 DBMS_WORKLOAD_REPOSITORY.CREATE_BASELINE(start_snap_id => 7550,

3 end_snap_id => 7660,

4 baseline_name => ¨am_baseline¨);

5 END;

6 /

PL/SQL procedure successfully completed.

SQL> select dbid,baseline_name,start_snap_id,end_snap_id from dba_hist_baseline;

DBID BASELINE_NAME START_SNAP_ID END_SNAP_ID

---------- -------------------- ------------- -----------

3812548755 am_baseline 7550 7660

4.2.2 删除Baseline

删除Baseline使用DROP_BASELINE过程,删除时可以通过cascade参数选择是否将其关联的Snapshots级别进行删除,例如:

SQL> BEGIN

2 DBMS_WORKLOAD_REPOSITORY.DROP_BASELINE(baseline_name => ¨am_baseline¨,

3 cascade => true);

4 END;

5 /

PL/SQL procedure successfully completed.

SQL> select * from dba_hist_baseline;

no rows selected

SQL> select * from dba_hist_snapshot where snap_id between 7550 and 7660;

如上例中所示,删除时指定了cascade参数值为true,对应的snap也被级联删除了。

不管是EM也好,或是前面演示中使用的awr*.sql脚本也好,实质都是访问ORACLE中的部分相关视图来生成统计数据,因此如果DBA对自己的理解能力有足够的自信,也可以直接查询动态性能视图(或相关数据字典)的方式来获取自己想要的那部分性能数据。ORACLE将这部分性能统计数据保存在DBA_HIST开头的数据字典中,要查询当前实例所有能够访问的DBA_HIST字典,可以通过下列语句:

SQL> select * from dict where table_name like ¨DBA_HIST%¨;

TABLE_NAME COMMENTS

------------------------------ --------------------------------------------------------------------------------

DBA_HIST_DATABASE_INSTANCE Database Instance Information

DBA_HIST_SNAPSHOT Snapshot Information

DBA_HIST_SNAP_ERROR Snapshot Error Information

DBA_HIST_BASELINE Baseline Metadata Information

DBA_HIST_WR_CONTROL Workload Repository Control Information

DBA_HIST_DATAFILE Names of Datafiles

DBA_HIST_FILESTATXS Datafile Historical Statistics Information

DBA_HIST_TEMPFILE Names of Temporary Datafiles

DBA_HIST_TEMPSTATXS Temporary Datafile Historical Statistics Information

DBA_HIST_COMP_IOSTAT I/O stats aggregated on component level

DBA_HIST_SQLSTAT SQL Historical Statistics Information

DBA_HIST_SQLTEXT SQL Text

......................

ORACLE 数据库中以DBA_HIST命名的视图非常多,下面简单介绍几个,比如说:

该视图由ASH自动维护,以每秒一次的频率收集当前系统中活动session的信息。虽然说是记录SESSION的历史记录,不过该视图与V$SESSION还是有差异的。

SQL> desc v$active_session_history;

Name Type Nullable Default Comments

------------------------- ------------ -------- ------- --------

SAMPLE_ID NUMBER Y

SAMPLE_TIME TIMESTAMP(3) Y

SESSION_ID NUMBER Y

SESSION_SERIAL# NUMBER Y

USER_ID NUMBER Y

SQL_ID VARCHAR2(13) Y

SQL_CHILD_NUMBER NUMBER Y

SQL_PLAN_HASH_VALUE NUMBER Y

FORCE_MATCHING_SIGNATURE NUMBER Y

SQL_OPCODE NUMBER Y

PLSQL_ENTRY_OBJECT_ID NUMBER Y

PLSQL_ENTRY_SUBPROGRAM_ID NUMBER Y

PLSQL_OBJECT_ID NUMBER Y

PLSQL_SUBPROGRAM_ID NUMBER Y

SERVICE_HASH NUMBER Y

SESSION_TYPE VARCHAR2(10) Y

SESSION_STATE VARCHAR2(7) Y

QC_SESSION_ID NUMBER Y

QC_INSTANCE_ID NUMBER Y

BLOCKING_SESSION NUMBER Y

BLOCKING_SESSION_STATUS VARCHAR2(11) Y

BLOCKING_SESSION_SERIAL# NUMBER Y

EVENT VARCHAR2(64) Y

EVENT_ID NUMBER Y

EVENT# NUMBER Y

SEQ# NUMBER Y

P1TEXT VARCHAR2(64) Y

P1 NUMBER Y

P2TEXT VARCHAR2(64) Y

P2 NUMBER Y

P3TEXT VARCHAR2(64) Y

P3 NUMBER Y

WAIT_CLASS VARCHAR2(64) Y

WAIT_CLASS_ID NUMBER Y

WAIT_TIME NUMBER Y

TIME_WAITED NUMBER Y

XID RAW(8) Y

CURRENT_OBJ# NUMBER Y

CURRENT_FILE# NUMBER Y

CURRENT_BLOCK# NUMBER Y

PROGRAM VARCHAR2(48) Y

MODULE VARCHAR2(48) Y

ACTION VARCHAR2(32) Y

v$session 中与操作相关的列均被收集,除此之外还冗余了部分列,这是为了方便DBA查询V$ACTIVE_SESSION_HISTORY时能够快速获取到自己需要的数据。

-

DBA_HIST_ACTIVE_SESS_HISTORY

该视图与V$ACTIVE_SESSION_HISTORY的结构灰常灰常灰常的想像,功能也灰常灰常灰常的类似,都是记录活动session的操作记录,所不同点在于,V$ACTIVE_SESSION_HISTORY是ORACLE自动在内存中维护的,受制于其可用内存区限制,并非所有记录都能保存,而DBA_HIST_ACTIVE_SESS_HISTORY视图则是维护到磁盘中的。简单理解的话,就是说通常情况下,DBA_HIST_ACTIVE_SESS_HISTORY视图的数据量要比V$ACTIVE_SESSION_HISTORY的多。

提示:上述结构并不绝对,因为默认情况下DBA_HIST_ACTIVE_SESS_HISTORY字典的数据每10秒收集一次,而V$ACTIVE_SESSION_HISTORY中则是每秒一次,因此也有可能V$ACTIVE_SESSION_HISTORY中记录量更大。不过相对来说,DBA_HIST字典中保存的数据更长久。

-

DBA_HIST_DATABASE_INSTANCE

该视图用来显示数据库和实例的信息,比如DBID,实例名,数据库版本等等信息,生成报表中第一行表格,就是由该视图生成的。如图:

如果你去分析awrrpt.sql脚本的话,会发现其中有如下脚本,上述表格中显示的内容信息,正是来自于下列脚本:

select distinct

(case when cd.dbid = wr.dbid and

cd.name = wr.db_name and

ci.instance_number = wr.instance_number and

ci.instance_name = wr.instance_name

then ¨* ¨

else ¨ ¨

end) || wr.dbid dbbid

, wr.instance_number instt_num

, wr.db_name dbb_name

, wr.instance_name instt_name

, wr.host_name host

from dba_hist_database_instance wr, v$database cd, v$instance ci;

该视图用来记录当前数据库收集到的快照信息。相信朋友应该还记得之前使用脚本生成报表时,输入完快照区间后显示的一堆列表,没错,那正是DBA_HIST_SNAPSHOT记录的内容,该段功能对应的代码如下:

select to_char(s.startup_time,¨dd Mon "at" HH24:mi:ss¨) instart_fmt

, di.instance_name inst_name

, di.db_name db_name

, s.snap_id snap_id

, to_char(s.end_interval_time,¨dd Mon YYYY HH24:mi¨) snapdat

, s.snap_level lvl

from dba_hist_snapshot s

, dba_hist_database_instance di

where s.dbid = :dbid

and di.dbid = :dbid

and s.instance_number = :inst_num

and di.instance_number = :inst_num

and di.dbid = s.dbid

and di.instance_number = s.instance_number

and di.startup_time = s.startup_time

and s.end_interval_time >= decode( &num_days

, 0 , to_date(¨31-JAN-9999¨,¨DD-MON-YYYY¨)

, 3.14, s.end_interval_time

, to_date(:max_snap_time,¨dd/mm/yyyy¨) - (&num_days-1))

order by db_name, instance_name, snap_id;

http://www.doc88.com/p-692153078075.html

参考:http://www.cnblogs.com/xiaochaohuashengmi/archive/2011/07/29/2121347.html

http://www.soitway.com/woaibiancheng/19.html

记得重启一下office_anywhere

另:mssql.secure_connection = Off 要设置为 off

在td_config.php(webroot\inc目录下)增加变量。

//-- OT 数据库配置

$MSSQL_OT_SERVER="192.168.1.1";

$MSSQL_OT_USER="sa";

$MSSQL_OT_DB="DBName";

$MSSQL_OT_PASS="XXXX";

function OpenOTConnection()

{

global $otconnection,$MSSQL_OT_SERVER,$MSSQL_OT_USER,$MSSQL_OT_DB,$MSSQL_OT_PASS;

if(!$otconnection)

{

if(!function_exists("mssql_pconnect"))

{

echo "PHP配置有误,不能调用Mssql函数库,请检查有关配置";

exit;

}

$C=@mssql_pconnect($MSSQL_OT_SERVER,$MSSQL_OT_USER,$MSSQL_OT_PASS);

//$C=@mssql_connect($MSSQL_OT_SERVER,$MSSQL_OT_USER,$MSSQL_OT_PASS);

}

else

$C=$otconnection;

$result=mssql_select_db($MSSQL_OT_DB,$C);

if(!$result)

{

PrintError("数据库 ".$MSSQL_OT_DB."不存在");

//exit;

}

return $C;

}

function exemsqlquery($C,$Q)

{

$cursor = mssql_query($Q,$C);

if(!$cursor)

{

PrintError("<b>SQL语句:</b> ".$Q);

//exit;

}

return $cursor;

}

function send_webmail_ext($USER_STR, $CC_STR,$SUBJECT,$CONTENT)

{

global $connection,$LOGIN_USER_ID,$LOGIN_USER_NAME,$RUN_ID;

$query = "SELECT * from WEBMAIL where USER_ID='admin'";

$cursor= exequery($connection,$query);

if($ROW=mysql_fetch_array($cursor))

{

$EMAIL=$ROW["EMAIL"];

$SMTP_SERVER=$ROW["SMTP_SERVER"];

$LOGIN_TYPE=$ROW["LOGIN_TYPE"];

$SMTP_PASS=$ROW["SMTP_PASS"];

$SMTP_PORT=$ROW["SMTP_PORT"];

$SMTP_SSL=$ROW["SMTP_SSL"]=="1" ? "ssl":"";

$EMAIL_PASS=$ROW["EMAIL_PASS"];

$EMAIL_PASS=decrypt_str($EMAIL_PASS,"webmail");

if($LOGIN_TYPE=="1")

$SMTP_USER = substr($EMAIL,0,strpos($EMAIL,"@")); // SMTP username

else

$SMTP_USER =$EMAIL;

if($SMTP_PASS=="yes")

$SMTP_PASS = $EMAIL_PASS; // SMTP password

else

$SMTP_PASS = "";

$USER_ARRAY=explode(",",$USER_STR);

//接收人

$query = "select USER_ID,EMAIL from USER WHERE find_in_set(USER_ID,'$USER_STR')";

echo $query;

$cursor = exequery($connection,$query);

while($ROW=mysql_fetch_array($cursor))

{

$USER_ID=$ROW["USER_ID"];

/*if($USER_ID==$LOGIN_USER_ID)

continue;*/

$TO_EMAIL=$ROW["EMAIL"];

/*if($TO_EMAIL=="")

{

$query1 = "select EMAIL from WEBMAIL WHERE USER_ID='$USER_ID' limit 1";

$cursor1 = exequery($connection,$query1);

if($ROW1=mysql_fetch_array($cursor))

$TO_EMAIL=$ROW["EMAIL"];

}

if($TO_EMAIL != "") */

$TO_WEBMAIL.=$TO_EMAIL.",";

}

//抄送

$query = "select USER_ID,EMAIL from USER WHERE (EMAIL IS NOT NULL AND EMAIL<>'') AND find_in_set(USER_ID,'$CC_STR')";

$cursor = exequery($connection,$query);

while($ROW=mysql_fetch_array($cursor))

{

$USER_ID=$ROW["USER_ID"];

/*if($USER_ID==$LOGIN_USER_ID)//本人

continue;*/

$CC_EMAIL=$ROW["EMAIL"];

/*if($TO_EMAIL=="")

{

$query1 = "select EMAIL from WEBMAIL WHERE USER_ID='$USER_ID' limit 1";

$cursor1 = exequery($connection,$query1);

if($ROW1=mysql_fetch_array($cursor))

$TO_EMAIL=$ROW["EMAIL"];

}*/

$CC_WEBMAIL.=$CC_EMAIL.",";

}

$result=send_mail($EMAIL,$TO_WEBMAIL,$SUBJECT,$CONTENT,$SMTP_SERVER,$SMTP_USER,$SMTP_PASS,true,$LOGIN_USER_NAME,'',$CC_WEBMAIL,'','',true,$SMTP_PORT,$SMTP_SSL);

if($result===true)

{

Message("提示","外部邮件发送成功");

}

else

{

Message("外部邮件发送失败",$result);

}

}

}

--工作流中表单控件中返回“工号_姓名”格式,目前只返回“姓名”。

1.在 selected.php中(webroot\module\user_select目录下)的12行"USERNAME"修改为

concat(USER_ID,'_',USER_NAME)USER_NAME

2.在 query.php中(webroot\module\user_select目录下)41行,修改同上

3.同理,将这个目录下所有查询 from USER中字段的 USERNAME修改同上。

4.修改这里会造成以下问题:

如果流程走向是根据表单内容来选择的,比哪"A1974_徐进海",就不会自动匹配人员

要修改 condition.php 的657行加入以下(webroot\general\workflow\list\turn 目录下)

$ITEM_DATA = preg_replace('/([x80-xff])/',"",$ITEM_DATA);//将非中文去掉 GBK模式下

$ITEM_DATA = str_replace("_","",$ITEM_DATA);

--增加超时邮件自动提醒功能

要求:定时启动任务当发生超时将邮件发给任务启动者,任务主办者,主办者直属上司(部门负责人),HR相关人员

1.在user表中增加 EMP_MANAGECODE varchar(20)

2.修改user_edit.php(webroot\general\system\user目录下),用以填写直属上司工号。

修改update.php(webroot\general\system\user目录下),用以保存直属上司工号。

3.增加workflow_timeout_remind.php(webroot\task\目录下)

4.以管理员进入“系统管理”,增加定时任务调度。

执行如下命令编辑文件/etc/exports:

# vi /etc/exports

在该文件里添加如下内容:

/home/work 192.168.0.*(rw,sync,no_root_squash)

然后保存退出。

添加的内容表示:允许ip 地址范围在192.168.0.*的计算机以读写的权限来访问/home/work 目录。

/home/work 也称为服务器输出共享目录。

括号内的参数意义描述如下:

rw:读/写权限,只读权限的参数为ro;

sync:数据同步写入内存和硬盘,也可以使用async,此时数据会先暂存于内存中,而不立即写入硬盘。

no_root_squash:NFS 服务器共享目录用户的属性,如果用户是 root,那么对于这个共享目录来说就具有 root 的权限。

接着执行如下命令,启动端口映射:

# /etc/rc.d/init.d/portmap start

最后执行如下命令启动NFS 服务,此时NFS 会激活守护进程,然后就开始监听 Client 端的请求:

--# /etc/rc.d/init.d/NFS start

# service nfs start

在客户端:

mount -t nfs 10.110.2.29:/mnt/d /home/oracle/backup

一、准备工作

查看是否处在归档模式

SQL> archive log list;

Database log mode No Archive Mode

Automatic archival Disabled

Archive destination USE_DB_RECOVERY_FILE_DEST

Oldest online log sequence 28

Current log sequence 30

如果是"No Archive Mode"

修改为归档模式

首先要关闭数据库,启动到mount状态。

SQL> shutdown immediate;

SQL> startup mount;

修改为归档模式

SQL>alter database archivelog;

验证修改结果

SQL> select log_mode from v$database;

LOG_MODE

------------

ARCHIVELOG

打开数据库

SQL> alter database open;

二、RMAN Catalog 配置

创建 RMAN Calalog表空间

SQL>create tablespace RMAN_TS datafile '/opt/oracle/oradata/orcl/RMAN_TS01.dbf' size 500M;

--创建用户rman/rman 默认表空间味RMAN_TS允许自由使用

SQL> create user rman identified by rman default tablespace RMAN_TS quota unlimited on RMAN_TS;

用户授权

SQL>grant connect, resource,recovery_catalog_owner to rman;

创建恢复目录

在命令终端

[oracle@localhost ~]$rman catalog rman/rman

RMAN> CREATE CATALOG;

连接,注册目标数据库,同步catalog和控制文件

[oracle@localhost ~]$rman target sys/wxbwer catalog rman/rman

连接成功出现下面的信息

connected to target database: ORCL (DBID=1325399111)

connected to recovery catalog database

RMAN> REGISTER DATABASE;

RMAN> RESYNC CATALOG;

下面是否有注册信息即可

RMAN>LIST INCARNATION;

List of Database Incarnations

DB Key Inc Key DB Name DB ID STATUS Reset SCN Reset Time

------- ------- -------- ---------------- --- ---------- ----------

2 36 ORCL 1325399111 PARENT 1 13-AUG-09

2 4 ORCL 1325399111 CURRENT 754488 25-OCT-12

三、创建RMAN备份脚本

来自:http://blog.csdn.net/robinson_0612/article/details/8029245

##===========================================================

## db_bak_rman.sh

## created by Robinson

## 2011/11/07

## usage: db_bak_rman.sh <$ORACLE_SID> <$BACKUP_LEVEL>

## BACKUP_LEVEL:

## F: full backup

## 0: level 0

## 1: level 1

##============================================================

#!/bin/bash

# User specific environment and startup programs

if [ -f ~/.bash_profile ];

then

. ~/.bash_profile

fi

ORACLE_SID=${1}; export ORACLE_SID

RMAN_LEVEL=${2}; export RMAN_LEVEL

TIMESTAMP=`date +%Y%m%d%H%M`; export TIMESTAMP

DATE=`date +%Y%m%d`; export DATE

#RMAN_DIR=/u02/database/${ORACLE_SID}/backup/rman; export RMAN_DIR

#RMAN_DATA=${RMAN_DIR}/${DATE}; export RMAN_DATA

#RMAN_LOG=/u02/database/${ORACLE_SID}/backup/rman/log export RMAN_LOG

RMAN_DIR=/opt/oracle/oradata/backup/rman; export RMAN_DIR

RMAN_DATA=${RMAN_DIR}/${DATE}; export RMAN_DATA

RMAN_LOG=${RMAN_DIR}/log export RMAN_LOG

# Check rman level

#======================================================================

if [ "$RMAN_LEVEL" == "F" ];

then unset INCR_LVL

BACKUP_TYPE=full

else

INCR_LVL="INCREMENTAL LEVEL ${RMAN_LEVEL}"

BACKUP_TYPE=lev${RMAN_LEVEL}

fi

RMAN_FILE=${RMAN_DATA}/${ORACLE_SID}_${BACKUP_TYPE}_${TIMESTAMP}; export RMAN_FILE

SSH_LOG=${RMAN_LOG}/${ORACLE_SID}_${BACKUP_TYPE}_${TIMESTAMP}.log; export SSH_LOG

MAXPIECESIZE=4G; export MAXPIECESIZE

#Check RMAN Backup Path

#=========================================================================

if ! test -d ${RMAN_DATA}

then

mkdir -p ${RMAN_DATA}

fi

echo "---------------------------------" >>${SSH_LOG}

echo " " >>${SSH_LOG}

echo "Rman Begin to Working ........." >>${SSH_LOG}

echo "Begin time at:" `date` --`date +%Y%m%d%H%M` >>${SSH_LOG}

#Startup rman to backup

#=============================================================================

$ORACLE_HOME/bin/rman log=${RMAN_FILE}.log <<EOF

connect target /

connect catalog rman/rman

run {

CONFIGURE RETENTION POLICY TO RECOVERY WINDOW OF 3 DAYS;

CONFIGURE BACKUP OPTIMIZATION ON;

CONFIGURE CONTROLFILE AUTOBACKUP ON;

CONFIGURE CONTROLFILE AUTOBACKUP FORMAT FOR DEVICE TYPE DISK TO '${RMAN_FILE}_%F';

ALLOCATE CHANNEL 'ch1' TYPE DISK maxpiecesize=${MAXPIECESIZE};

ALLOCATE CHANNEL 'ch2' TYPE DISK maxpiecesize=${MAXPIECESIZE};

set limit channel ch1 readrate=10240;

set limit channel ch1 kbytes=4096000;

set limit channel ch2 readrate=10240;

set limit channel ch2 kbytes=4096000;

CROSSCHECK ARCHIVELOG ALL;

DELETE NOPROMPT EXPIRED ARCHIVELOG ALL;

BACKUP

#AS COMPRESSED BACKUPSET

${INCR_LVL}

DATABASE FORMAT '${RMAN_FILE}_%U' TAG '${ORACLE_SID}_${BACKUP_TYPE}_${TIMESTAMP}';

SQL 'ALTER SYSTEM ARCHIVE LOG CURRENT';

BACKUP ARCHIVELOG ALL FORMAT '${RMAN_FILE}_arc_%U' TAG '${ORACLE_SID}_arc_${TIMESTAMP}'

DELETE INPUT;

DELETE NOPROMPT OBSOLETE;

RELEASE CHANNEL ch1;

RELEASE CHANNEL ch2;

}

sql "alter database backup controlfile to ''${RMAN_DATA}/cntl_${BACKUP_TYPE}.bak''";

exit;

EOF

RC=$?

cat ${RMAN_FILE}.log >>${SSH_LOG}

echo "Rman Stop working @ time:"`date` `date +%Y%m%d%H%M` >>${SSH_LOG}

echo >>${SSH_LOG}

echo "------------------------" >>${SSH_LOG}

echo "------ Disk Space ------" >>${SSH_LOG}

df -h >>${SSH_LOG}

echo >>${SSH_LOG}

if [ $RC -ne "0" ]; then

echo "------ error ------" >>${SSH_LOG}

else

echo "------ no error found during RMAN backup peroid------" >>${SSH_LOG}

rm -rf ${RMAN_FILE}.log

fi

#Remove old backup than 3 days

#============================================================================

RMDIR=${RMAN_DIR}/`/bin/date +%Y%m%d -d "3 days ago"`; export RMDIR

echo >>${SSH_LOG}

echo -e "------Remove old backup than 3 days ------\n" >>${SSH_LOG}

if test -d ${RMDIR}

then

rm -rf ${RMDIR}

RC=$?

fi

echo >>${SSH_LOG}

if [ $RC -ne "0" ]; then

echo -e "------ Remove old backup exception------ \n" >>${SSH_LOG}

else

echo -e "------ no error found during remove old backup set peroid------ \n" >>${SSH_LOG}

fi

exit

[oracle@localhost backup]$ pwd

/opt/oracle/oradata/backup

[oracle@localhost backup]$vi db_bak_rman.sh

将上面脚本复制进去,并保存,且设置权限

[oracle@localhost backup]$ chmod 755 db_bak_rman.sh

测试脚本

orcl 为 SID

0: 代表0级备份

[oracle@localhost backup]$ ./db_bak_rman.sh orcl 0

四、crontab 定时任务 以 oralce用户登录

[oracle@localhost backup]$crontab -e

45 23 * * 0 /opt/oracle/oradata/backup/db_bak_rman.sh orcl 0

45 23 * * 1-3 /opt/oracle/oradata/backup/db_bak_rman.sh orcl 2

45 23 * * 4 /opt/oracle/oradata/backup/db_bak_rman.sh orcl 1

45 23 * * 5-6 /opt/oracle/oradata/backup/db_bak_rman.sh orcl 2

以root用户登录

[root@localhost backup]$/etc/init.d/crond restart

Stopping crond: [ OK ]

Starting crond: [ OK ]

脚本的增量备份策略: 周日0级备份,周四1级备份,其他2级备份

差异备份有3个级别:

0级:相当于全备,不同的是0级可用于增量备份,全备不行。

1级:备份自上次0级备份以来的数据

2级:备份自上次备份依赖的数据

logminer的安装配置使用

安装

环境:linux AS5,oracle 11gR2

2.添加补充日志

如果数据库需要使用logminer,就应该添加,只有添加这个日志之后的才能捕获DML

ALTER DATABASE ADD SUPPLEMENTAL LOG DATA (PRIMARY KEY, UNIQUE INDEX) COLUMNS;

3.开启归档(对logminer来说不是必须)

alter system set log_Archive_dest_1='/opt/oracle/flash_recovery_area' scope=both;

shutdown immediate

startup mount

alter database archivelog;

alter database open;

创建DBMS_LOGMNR包

SQL>@?/rdbms/admin/dbmslm.sql

创建相关数据字典

SQL>@?/rdbms/admin/dbmslmd.sql

修改初始化参数UTL_FILE_DIR,指定分析数据的存放处

SQL>alter system set UTL_FILE_DIR='/opt/oracle/oradata/logminer' scope=spfile;

重启数据库

SQL>shutdown immediate

SQL>startup

SQL> show parameter utl;

NAME TYPE VALUE

------------------------------------ ----------- ------------------------------

create_stored_outlines string

utl_file_dir string /opt/oracle/oradata/logminer

生成字典信息文件:

SQL> execute dbms_logmnr_d.build(dictionary_filename=>'/opt/oracle/oradata/logminer/sqltrace.ora',dictionary_location=>'/opt/oracle/oradata/logminer');

PL/SQL 过程已成功完成。

查当前日志组

SQL>select Group#, Status from v$log;

GROUP# STATUS

---------- ----------------

1 INACTIVE

2 CURRENT

3 INACTIVE

SQL>select Group#, MEMBER from v$logfile;

GROUP# MEMBER

---------- ----------------------------------------

3 /opt/oracle/oradata/orcl/redo03.log

2 /opt/oracle/oradata/orcl/redo02.log

1 /opt/oracle/oradata/orcl/redo01.log

添加需要分析的日志文件(在线日志)

SQL> execute dbms_logmnr.add_logfile(options=>dbms_logmnr.new,logfilename=>'/opt/oracle/oradata/orcl/redo02.log');

#归档日志

execute dbms_logmnr.add_logfile(options=>dbms_logmnr.new,logfilename=>'/opt/oracle/oradata/logminer/1_6356_704818301.dbf');

PL/SQL 过程已成功完成。

SQL> execute dbms_logmnr.add_logfile(options=>dbms_logmnr.addfile,logfilename=>'opt/oracle/oradata/orcl/redo03.log');

PL/SQL 过程已成功完成。

options选项有三个参数可选:

NEW - 表示创建一个新的日志文件列表

ADDFILE - 表示向这个列表中添加日志文件

REMOVEFILE - 和addfile相反。

开始分析

SQL> execute dbms_logmnr.start_logmnr(dictfilename=>'/opt/oracle/oradata/logminer/sqltrace.ora');

#设置 STARTTIME / ENDTIME

SQL>execute dbms_logmnr.start_logmnr(dictfilename=>'/u01/app/oracle/logminer/sqltrace.ora',starttime => to_date('2012/11/01-08:00:00','yyyy/mm/dd-hh24:mi:ss'),endtime => to_date('2012/11/02-12:30:00','yyyy/mm/dd-hh24:mi:ss'));

#也可以设置不用数据字典,只是看不到解释过来,没有意义了。

begin

dbms_logmnr.start_logmnr(starttime => to_date('2012/09/29-08:55:00','yyyy/mm/dd-hh24:mi:ss'),

endtime => to_date('2012/09/29-15:30:00','yyyy/mm/dd-hh24:mi:ss')

);

PL/SQL 过程已成功完成。

dbms_logmnr.start_logmnr()过程还有其它几个用于定义分析日志时间/SCN窗口的参数,它们分别是:

STARTSCN / ENDSCN - 定义分析的起始/结束SCN号,

STARTTIME / ENDTIME - 定义分析的起始/结束时间。

查询分析的日志文件包含的scn范围和日期范围。

SQL> select low_time,high_time,low_scn,next_scn from v$logmnr_logs;

LOW_TIME HIGH_TIME LOW_SCN NEXT_SCN

-------------- -------------- ---------- ----------

08-8月 -07 08-8月 -07 626540 637998

08-8月 -07 01-1月 -88 637998 2.8147E+14

SQL> create table ELLINGTON.log_content NOLOGGING Tablespace Users as select timestamp,sql_redo,sql_undo,USERNAME,OS_USERNAME,MACHINE_NAME from v$logmnr_contents;

将内容复制到一张表中查询并指定存储表空间,desc v$logmnr_contents

结束分析

SQL> execute dbms_logmnr.end_logmnr;

结束后视图v$logmnr_contents中的分析结果也不再存在,关闭sqlplus自动结束。

注意:1. LogMiner必须使用被分析数据库实例产生的字典文件,而不是安装LogMiner的数据库产生的字典文件,另外必须保证安装LogMiner数据库的字符集和被分析数据库的字符集相同。

2. 被分析数据库平台必须和当前LogMiner所在数据库平台一样,也就是说如果我们要分析的文件是由运行在UNIX平台上的Oracle 8i产生的,那么也必须在一个运行在UNIX平台上的Oracle实例上运行LogMiner,而不能在其他如Microsoft NT上运行LogMiner。当然两者的硬件条件不一定要求完全一样。

3. 生产库的归档日志拿到测试机上来分析,虽然可以分析,但是由于db_id不同,不能使用数据字典,也就看不到翻译过的语句(16进制的东西)

一。查出原系统有多少表空间:

select a.tablespace_name,total,free,round(free/total*100,2) free_precent,total-free used from

( select tablespace_name,sum(bytes)/1024/1024 total from dba_data_files

group by tablespace_name) a,

( select tablespace_name,sum(bytes)/1024/1024 free from dba_free_space

group by tablespace_name) b

where a.tablespace_name=b.tablespace_name

order by tablespace_name;

TABLESPACE_NAME TOTAL FREE FREE_PRECENT USED

------------------------------ ---------- ---------- ------------ ----------

AUDTOOL 5120 959.9375 18.75 4160.0625

DBA01_2001 500 499.9375 99.99 0.0625

DBA01_2002 500 499.9375 99.99 0.0625

DBA01_2003 500 499.9375 99.99 0.0625

DBA01_2004 500 499.9375 99.99 0.0625

DBA01_2005 1024 1023.9375 99.99 0.0625

DBA01_2006 1024 1023.9375 99.99 0.0625

DBA01_2007 1024 1023.9375 99.99 0.0625

DBA01_2008 1024 1023.9375 99.99 0.0625

DBA01_2009 1024 1023.9375 99.99 0.0625

DBA01_2010 1024 1023.9375 99.99 0.0625

DBA01_2011 1024 1023.9375 99.99 0.0625

INDX 98816 19484.3125 19.72 79331.6875

SYSAUX 27080.9375 1126.6875 4.16 25954.25

SYSTEM 2788 1626.3125 58.33 1161.6875

UNDOTBS2 3524 3299 93.62 225

USERS 92160 54093.875 58.7 38066.125

二。查出各表空间数据文件大小

SQL> SELECT TABLESPACE_NAME ,FILE_NAME, BYTES/1024/1024 SIZE_M from dba_data_files WHERE TABLESPACE_NAME = 'USERS';

TABLESPACE FILE_NAME SIZE_M

---------- ------------------------------ ----------

USERS /u02/oradata/orcl/users01.dbf 30720

USERS /u02/oradata/orcl/users02.dbf 30720

USERS /u02/oradata/orcl/users03.dbf 30720

SQL>SELECT TABLESPACE_NAME ,FILE_NAME, BYTES/1024/1024 SIZE_M from dba_data_files WHERE TABLESPACE_NAME = 'DBA01_2001';

TABLESPACE FILE_NAME SIZE_M

---------- ---------------------------------------- ----------

DBA01_2001 /u02/oradata/orcl/users_2001.dbf 500

SQL> SELECT TABLESPACE_NAME ,FILE_NAME, BYTES/1024/1024 SIZE_M from dba_data_files WHERE TABLESPACE_NAME = 'DBA01_2002';

TABLESPACE FILE_NAME SIZE_M

---------- ---------------------------------------- ----------

DBA01_2002 /u02/oradata/orcl/users_2002.dbf 500

SQL> SELECT TABLESPACE_NAME ,FILE_NAME, BYTES/1024/1024 SIZE_M from dba_data_files WHERE TABLESPACE_NAME = 'DBA01_2003';

TABLESPACE FILE_NAME SIZE_M

---------- ---------------------------------------- ----------

DBA01_2003 /u02/oradata/orcl/users_2003.dbf 500

SQL> SELECT TABLESPACE_NAME ,FILE_NAME, BYTES/1024/1024 SIZE_M from dba_data_files WHERE TABLESPACE_NAME = 'DBA01_2004';

TABLESPACE FILE_NAME SIZE_M

---------- ---------------------------------------- ----------

DBA01_2004 /u02/oradata/orcl/users_2004.dbf 500

SQL> SELECT TABLESPACE_NAME ,FILE_NAME, BYTES/1024/1024 SIZE_M from dba_data_files WHERE TABLESPACE_NAME = 'DBA01_2005';

TABLESPACE FILE_NAME SIZE_M

---------- ---------------------------------------- ----------

DBA01_2005 /u02/oradata/orcl/users_2005.dbf 1024

SQL> SELECT TABLESPACE_NAME ,FILE_NAME, BYTES/1024/1024 SIZE_M from dba_data_files WHERE TABLESPACE_NAME = 'DBA01_2006';

TABLESPACE FILE_NAME SIZE_M

---------- ---------------------------------------- ----------

DBA01_2006 /u02/oradata/orcl/users_2006.dbf 1024