2012年12月25日

最近准备将redis升级到最新版2.6,就简单从官网上寻找了一下最近的改动点.

2.2-2.4的改进

* 编码sorted sets, 小的soted sets将会使用非常小的内存

* 编码数据类型(ziplists,zipmaps,intsets)的本地持久化,更多的数据sets的保存和加载速度提高了一个数量级.

* 命令(SADD,HDEL,SREM,ZREM,ZADD,L/RPUSH)支持可变参数输入

* 为了避免减少内存碎片,支持jemalloc(linux系统默认开启)

* 保存时降低内存使用率

* 更多的信息field (peak memory, fork time, )

* OBJECT 命令 支持对象自检

* CLIENT 命令支持clients自检

* 非阻塞的从->主连接

* 更好的redis-cli连接处理,新的redis-cli特征

* 更好的redis-benchmark,现在能benchmark用户提供的命令.

* 色彩化Make命令.

* VM废弃,仍然支持,但是给出警告不要使用它.

* LRANGE优化,可以在查询一个长list的最后一部分时显著提高性能,。

* redis-cli 现在实现了一个延迟模式来监控redis的延迟

* Hash type settings 从INFO中移除 (一样的信息可以通过配置GET来获取)

* 在无法bind的时候 在错误信息中包含端口号

* AOF fsync 当fsync策略是'everysec'的时候,运行在后台.

* AOF performances improved moving in background a possibly slow close(2) call.

* AOF protocol synthesis speedup.

* 新的maxmemory测试.

* redis-check-dump: RDB version 2 now supported.

* 为一个uinx socket mask增加一个配置说明.

* CONFIG SET/GET 设置 loglevel.

* 在/utils 中增加redis 全系统(Debian/Ubuntu)安装脚本.

* redis-cli 现在支持单引号风格的字符串

* 通过CONFIG SET 命令关闭密码认证.

* redis.conf 部分更好地 better documented.

* 客户端默认超时timeout是0,即永不超时.

* 调整I/O缓存长度为了提高大负载的性能.

* Fixed crash on SPARC due to improper alighment due to bad assumptions about data types size.

* CLIENT LIST 输出加强,代码重构.

* CLIENT LIST 输出修改,包括客户端最后执行的命令.

* 协议错误现在记录log loglevel>=verbose.

* 两个新的INFO field关联到AOF,对于调查redis问题非常有用.

* 在redis的测试中实现--quiet选项

* 在INFO 中包含每个连接的slave的ip/端口/状态.

* 在INFO output信息中展示GCC版本.

* redis-cli增加 --pipe 模式, see http://redis.io/topics/mass-insert

* 更好地改进失效key收集算法,当大量keys在同时失效的时候, 使得server响应性能更快.

* INFO 命令展示slaves(包括端口号) 建议使用2.4.16以上的版本作slave

This makes Redis 2.4.16 compatible with Redis Sentinel. This fix required the introduction of a new internal command called REPLCONF, see commit b998ebe for more information.

* INFO 命令现在包含run_id字段保证Redis Sentinel的兼容性

* 支持参数'slave priority' 通过INFO发布,主要用于Redis Sentinel.

2.4-2.6的改进

* SORT现在会拒绝无法转换为数字的数字模型元素进行排序

* EXPIREs现在支持微秒失效. (but this is very unlikely to

break code that was not conceived exploting the previous resolution error

in some way.)

* INFO输出现在一点不同,包含空line和'#'开通的注释.所有主流的客户端现在已经支持新的INFO格式.

* Slaves 现在默认是只读模式(但是可以通过修改配置文件red is.conf的'slave-read-only'项 为'no' 来取消只读 ,或者使用CONFIG SET来取消).

下面的INFO field为了一致性调整了名字:

changes_since_last_save -> rdb_changes_since_last_save

bgsave_in_progress -> rdb_bgsave_in_progress

last_save_time -> rdb_last_save_time

last_bgsave_status -> rdb_last_bgsave_status

bgrewriteaof_in_progress -> aof_rewrite_in_progress

bgrewriteaof_scheduled -> aof_rewrite_scheduled

下面的redis.conf配置文件和 CONFIG GET / SET 参数做了调整:

* hash-max-zipmap-entries, 替换为 hash-max-ziplist-entries

* hash-max-zipmap-value, 替换为 hash-max-ziplist-value

* glueoutputbuf option 现在已经完全废弃 (was deprecated)

* Server 端支持Lua脚本, see http://redis.io/commands/eval

* Virtual Memory 完全去掉(was deprecated in 2.4)

* 关于客户端最大数量限制的硬编码去掉.

* AOF 低级的语义更明智,尤其是使用在slaves中的时候.

* 微秒级的expires,也增加了一些新的命令(PEXPIRE,PTTL,…) .

* 为了小集合(lists,ziplists和hashes里只包含小integer的时候)提供更好的内存使用率. * slaves只读.

* 新增位操作: BITCOUNT 和 BITOP 命令.

* 客户端最大输出缓存的软件限制和硬件限制.可以根据不同的客户端类型(normal,pubsub,slave)来指定不同的限制.

*更多地增量过期(减少阻塞)的过期key收集算法 ,当非常多的key在同一时间失效的时候,意味着redis可以提高响应的数据.

* AOF is now able to rewrite aggregate data types using variadic commands,

often producing an AOF that is faster to save, load, and is smaller in size.

* Every redis.conf directive is now accepted as a command line option for the

redis-server binary, with the same name and number of arguments.

* 为了减少碰撞攻击,hash表的种子采用随机产生

* 写大量object到red is的性能提高

* 集成内存测试.见命令:redis-server --test-memory.

* INCRBYFLOAT 和 HINCRBYFLOAT命令

* 新的命令 DUMP, RESTORE, MIGRATE(从 Redis Cluster 移植到 2.6).

* CRC64 校验 in RDB files.

* 更好的监控输出log(现在命令在执行前记录log)

* "Software Watchdog" feature to debug latency issues.

* 启动时增加Redis的ASCII码的艺术logo标记.

* 内存冲突的崩溃报告 或者失败断言 使得调试定位bug的困难程度得到一定地降低 .

* redis-benchmark 增强: 运行选择的测试,CSV输出,更快,更好的help

* redis-cli 增强: --eval lua脚本的开发

* SHUTDOWN 现在支持两个可选参数 'SAVE' 和 'NOSAVE' .

* INFO 输出分解为几个部分,这个命令可以指定输出某个部分.

* 增加新的统计,一个命令被调用了多少次,被执行了多少时间(INFO commandstats) .

* More predictable SORT behavior in edge cases.

* Build模块代码改进.

* 现在当slave-serve-stale-data 设置为yes并且master挂掉的时候, 代替报告一个通常的错误的red is回复 -MASTERDOWN

Now when slave-serve-stale-data is set to yes and the master is down, instead of reporting a generic error Redis replies with -MASTERDOWN.

2012年12月12日

metamorphosis 是通过jmx原理实现的监控,重载配置等服务.所以需要对metaq监控就有两个条件必须满足:

1 使用metamorphosis-server-wrapper

2 metaq的java启动参数中必须开启jmx的相关参数(-Dcom.sun.management.jmxremote )

才能使用metaServer.sh命令监控

stats命令

不加任何参数,展示metaq的整个程序的相关参数.

./metaServer.sh stats

结果

STATS

pid 16585

broker_id 1002

port 8123

uptime 691558

version 1.4.3

slave false

curr_connections 3

threads 134

cmd_put 1142

cmd_get 437188

cmd_offset 0

tx_begin 0

tx_xa_begin 0

tx_commit 0

tx_rollback 0

get_miss 437123

put_failed 0

total_messages 3192

topics 14

config_checksum 3605506033

END

-item参数 brokers

./metaServer.sh stats -item brokers

结果

STATS

brokers

resultCode 1

partitions 0

message_count 0

bytes 0

topic_realtime_put Invalid keyTwo:brokers

topic_realtime_get Invalid keyTwo:brokers

topic_realtime_offset null

topic_realtime_get_miss Invalid keyTwo:brokers

topic_realtime_put_failed null

topic_realtime_message_size Invalid keyTwo:brokers

END

topics

./metaServer.sh stats -item

执行结果

STATS

category partitions 1 message_count 28 accept_publish true accept_subscribe true

metatest2 partitions 1 message_count 1000 accept_publish true accept_subscribe true

test partitions 1 message_count 31 accept_publish true accept_subscribe true

metatest partitions 1 message_count 1058 accept_publish true accept_subscribe true

user_fav partitions 1 message_count 3 accept_publish true accept_subscribe true

product partitions 1 message_count 3 accept_publish true accept_subscribe true

listen_queue partitions 1 message_count 15 accept_publish true accept_subscribe true

listen_queue_confirm partitions 1 message_count 1048 accept_publish true accept_subscribe true

user_remind partitions 1 message_count 7 accept_publish true accept_subscribe true

cart *Empty*

listen_queue_success *Empty*

order *Empty*

user_changePass *Empty*

user_reg *Empty*

END

topic名称(比如:test)

./metaServer.sh stats -item test

执行结果

STATS

test

resultCode 0

partitions 1

message_count 31

bytes 3855

topic_realtime_put Count=0,Value=0,Value/Count=invalid,Count/Duration=0,Duration=1251

topic_realtime_get Count=0,Value=0,Value/Count=invalid,Count/Duration=0,Duration=1251

topic_realtime_offset null

topic_realtime_get_miss Count=0,Value=0,Value/Count=invalid,Count/Duration=0,Duration=1251

topic_realtime_put_failed null

topic_realtime_message_size Count=0,Value=0,Value/Count=invalid,Count/Duration=0,Duration=1251

END

2012年11月29日

message为主要关键字,类似于java中的class。

定义简单message类型

SearchRequest.proto定义了每个查询请求的消息格式,每个请求都会有查询关键词query,查询结果的页数,每页的结果数量这三个属性。于是

message SearchRequest{

required string query = 1;

optional int32 page_number = 2;

optional int32 result_per_page =3;

repeated int32 samples = 4 [packed=true];

}

message定义了三个field,每个field由名字和类型来组成。

在这个例子中,SearchRequest的field都是基本类型,两个integer(page_number和result_per_page)和一个Stirng(query),也可以指定复杂的类型属性,包括枚举和其它类型。

每个field都是唯一数字的标记,这是用来标记这个field在message二进制格式中的位置的,一旦使用就不能再修改顺序了。

注:标记从1-15只有一个字节编码,包括自增长属性(更多的见Protocol Buffer Encoding)

标记从16-2047占用两个字节。因此尽量频繁使用1-15,记住为未来的扩展留下一些位置。

最小的tag你可以定义为1,最大2的29次方-1 536870922.你同样不能使用19000-19999(这个位置已经被GPB自己实现),

message SearchRequest{

required string query = 1;

optional int32 page_number = 2;

optional int32 result_per_page =3;

repeated int32 samples = 4 [packed=true];

}

由于历史原因,repeated字段如果是基本数字类型的话,不能有效地编码。现在代码可以使用特殊选项[packed=true]来得到更有效率的编码。

注: 由于required是永远的,应该非常慎重地给message某个字段设置为required。如果未来你希望停止写入或者输出某个required字段,那就会成为问题;因为旧的reader将以为没有这个字段无法初始化message,会丢掉这部分信息。一些来自google的工程师们指出使用required弊大于利,尽量使用optional和repeated。

这个观点并不是通用的。

多个message类型能被定义在一个简单的.proto文件中,通常是创建具有关联关系的message时候这么作。

message SearchRequest{

required string query = 1;

optional int32 page_number = 2;

optional int32 result_per_page =3;

repeated int32 samples = 4 [packed=true];

}

使用c/C++ style

message SearchRequest{

required string query = 1; //

optional int32 page_number = 2; // which page number do we want?

optional int32 result_per_page =3; // Number of results to return per page?

repeated int32 samples = 4 [packed=true];

}

protocol buffer编译一个proto文件,生成对应语言的代码。

大概包括各个字段的get和set方法,序列化message到输出流的方法,从输入流转成message的方法。

C++,为每个proto生成一个.h和.cc文件

Java,为每个proto生成一个.java文件

Python,有点不同,生成一个module

当含有optional字段的message从流转换成对象的时候,如果没有包含optional字段的数据,那么对象的optional字段会设置成默认值。

默认值可以作为message的描述出现。举个例子:

optional int32 result_per_page = 3 [default = 10];

如

pasting

果没有指定默认值的话,string 默认为空串,bool 默认为false,数字类型默认0,枚举类型,默认为类型定义中的第一个值,

如果字段的属性值是固定的几个值,可以使用枚举

message SearchRequest {

required string query = 1;

optional int32 page_number = 2;

optional int32 result_per_page = 3 [default = 10];

enum Corpus {

UNIVERSAL = 0;

WEB = 1;

IMAGES = 2;

LOCAL = 3;

NEWS = 4;

PRODUCTS = 5;

VIDEO = 6;

}

optional Corpus corpus = 4 [default = WEB];

}

可以使用message类型做字段的属性,看例子:

message SearchResponse {

repeated Result result = 1;

}

message Result {

required string url = 1;

optional string title = 2;

repeated string snippets = 3;

}

上面的例子SearchResponse 与Result在一个.proto文件中。其实也可以使用另一个.proto文件来定义字段类型。

你可以通过import来定义。

import "myproject/other_protos.proto";

protocol编译器查找引入文件是通过编译器的命令参数 -I/--proto_path

如果没有指定,就在protoc执行目录下寻找。

The protocol compiler searches for imported files in a set of directories specified on the protocol compiler command line using the -I/--proto_path flag.

If no flag was given, it looks in the directory in which the compiler was invoked.

In general you should set the --proto_path flag to the root of your project and use fully qualified names for all imports.

你可以定义和使用内部message类。

message SearchResponse {

message Result {

required string url = 1;

optional string title = 2;

repeated string snippets = 3;

}

repeated Result result = 1;

}

如果要引用内部类,则通过parent.type方式来调用

message SomeOtherMessage {

optional SearchResponse.Result result = 1;

}

还可以很深、很深的内部类

message Outer { // Level 0

message MiddleAA { // Level 1

message Inner { // Level 2

required int64 ival = 1;

optional bool booly = 2;

}

}

message MiddleBB { // Level 1

message Inner { // Level 2

required int32 ival = 1;

optional bool booly = 2;

}

}

}

message SearchResponse {

repeated group Result = 1 {

required string url = 2;

optional string title = 3;

repeated string snippets = 4;

}

}

Extentions

extensions 声明一个消息中的一定范围的field的顺序数字用于进行扩展。其它人可以在自己的.proto文件中重新定义这些消息field,而不需要去修改原始的.proto文件

message Foo {

//

extensions 100 to 199;

}

这些说明100-199的field是保留的。其它用户可以用这些field在他们自己的.proto文件中添加新的fields给Foo。举例:

extend Foo {

optional int32 bar = 126;

}

说明 Foo有一个optional的int32类型的名称为bar的field

当Foo的message编码后,数据格式就跟用户在Foo中定义一个新的field完全一样。但是你在程序中访问extension field的方式与访问正常的属性略微有点不同。生成的extensions的访问代码是不同的。举例:c++中如何set属性bar的值:

Foo foo;

foo.SetExtension(bar,15);

同样,Foo 定义了模板访问器 HasExtendsion(),ClearExtension(),GetExtension(),MutableExtension(),AddExtension().

所有 访问

注: extensions能使用任何field类型,包括自定义消息类型。

能声明extensions在另一个message中

message Baz {

extend Foo {

optional int32 bar = 126

;

}

}

在这个例子中, the C++ 代码访问访问这个属性:

Foo foo;

foo.SetExtension(Baz::bar, 15);

换句话说,这么做唯一影响是bar定义在了Baz的范围之内。

注意:容易混淆的地方 声明一个消息内部的继承类并不意味着外部类和extended类有任何关系。特别 以上的例子并不意味着Baz是任何Foo的子类。这些只是意味着符号bar是声明在Baz的范围之内的,它看起来更像是个静态成员。

一个通用的模式是在extensions的field范围内来定义extensions,举例说明,这里有一个Foo的extension作为Baz的一部分的属性类型是Baz

message Baz {

extend Foo {

optional Baz foo_ext = 127

;

}

}

没有必要非得在message内部定义一个extension的类型。你也可以这么做:

message Baz {

}

// This can even be in a different file.

extend Foo {

optional Baz foo_baz_ext = 127

;

}

事实上,上面的这个语法更加有效地避免混淆。正如上文所述,内部的那种语法语法对于不是熟悉extensions的人来说,经常会错认为子类。

非常重要的一点是双方不能使用同样数字添加一样的message类型,这样extension会被解释为错误类型。

可能需要有一个关于field的数字顺序的约定来保证你的project不会发生这样的重复的问题。

如果你的field数字比较大的话,可以使用max来指定你的textension范围上升到最大的范围

message Foo {

extensions 1000 to max;

}

max is 229 - 1, or 536,870,911.

19000-19999是protocol buffers的使用的字段,所以这个范围内的数字需要区别开来。

Packages

可以给一个.protol文件增加一个optional的package描述,来保证message尽量不会出现名字相同的重名。

package foo.bar

;

message Open {

}

也可以在指定field类型的时候使用

message Foo {

required foo.bar.Open open = 1

;

}

package会根据选择的语言来生成不同的代码:

C++ 生成的classes是用C++的namespace来区分的。举例:Open would be in the namespace foo::bar。

Java package用于Java的package,除非你单独的指定一个option java_package 在.proto文件中。

Python package是被忽略的,因为Python的modules是通过它们的文件位置来组织的。

在protocol buffer中package名称的方案看起来像C++,首先,最里面的范围被搜索,然后搜索次一级的范围,

每个package被认为在他的父package内。一个. (.foo.bar.Baz)意味着从最外层开始.

options

在一个proto文件中,还可以存在一些options。Options不能改变一个声明的整体的意义,但是可以影响一定的上下文。

可用的options的完整list定义在 Google/protobuf/descriptor.proto

一些options是第一级的,意味着它们应该被写在顶级范围,而不是在任何message,enum,sercie的定义中。

一些options是message级别的,意味着它们应该被写入message的描述中,

一些options是field-level级别的,意味着它们应该被写入field的描述中,

options也可以被写入enum类型中,enum的值,service类型 和service方法;

列举了常用的options:

java_package(file option)

定义生成的java class的package。如果在proto文件中没有明确的java_package选项,那么默认会使用package关键字指定的package名。

但是proto package通常不会好于Java packages,因为proto packages通常不会以domain名称开始。

如果不生成java代码,此选项没有任何影响。

option java_package = "com.example.foo";

java_outer_classname:(file option)

指定想要生成的class名称,如果此参数没有指定的话,那么默认使用.proto文件名来做为类名,并且采用驼峰表示(比如:foo_bar.proto 为 FooBar.java)

如果不生成java代码,此选项没有影响。

option java_outer_classname = "Ponycopter";

optimize_for (file option)

可以设置为speed、code_size或者lite_runtime.

SPEED:默认。protocol编译器会生成classes代码,提供了message类的序列化、转换和其它通用操作。这个代码是被高度优化过的。

CODE_SIZE: protocol编译器会生成最小的classes,并且依赖共享、基于反射的代码实现序列化、转换和其它通用操作。生成的classes代码小于speed,但是操作会慢一点。classes会实现跟SPEED模式一样的公共API。这个模式通常用在一个应用程序包含了大量的proto文件,但是并不需要所有的代码都执行得很快

LITE_RUNTIME: protocol编译器会生成仅仅依赖 lite 运行库(libprotobuf-lite代替libprotobuf)。lite运行时比全量库小很多,省略了某种特性(如: descriptors and reflection)这个选项对于运行在像移动手机这种有约束平台上的应用更有效。 编译器仍然会对所有方法生成非常快的代码实现,就像SPEED模式一样。protocol编译器会用各种语言来实现MessageList接口,但是这个接口仅仅提供了其它模式实现的Message接口的一部分方法子集。

例子

option optimize_for = CODE_SIZE;

cc_generic_services, java_generic_services, py_generic_services (file options)

无论如何,protoc编译器会生成基于C++,Java,Python的抽象service代码,这些默认都是true。截至到2.3.0版本,RPC实现提供了代码生成插件去生成代码,不再使用抽象类。

// This file relies on plugins to generate service code.

option cc_generic_services = false;

option java_generic_services = false;

option py_generic_services = false;

message_set_wire_format (message option)

如果设置为true,消息使用不同的二进制格式来兼容谷歌内部使用的称为MessageSet的旧格式。用户在google以外使用,将不再需要使用这个option。

消息必须按照以下声明

message Foo {

option message_set_wire_format = true;

extensions 4 to max;

}

packed (field option)

如果设置为true, 一个repeated的基本integer类型的field,会使用一种更加紧凑的压缩编码。请注意,在2.3.0版之前,protocol生成的解析逻辑收到未预期的压缩的数据将会忽略掉。因此,改变一个已经存在的field,一定会破坏其线性兼容性。在2.3.0以后,这种改变就是安全的,解析逻辑可以识别压缩和不压缩的格式,但是,一定要小心那些使用原先旧版本的protocol的程序。

repeated int32 samples = 4 [packed=true];

deprecated (field option):

如果设置为true,表示这个field被废弃,应该使用新代码。大多数语言中,这个没有任何影响。在java中,会生成@Deprecated的注释。未来,其它语言代码在field的访问方法上也会生成相应的注释。

optional int32 old_field = 6 [deprecated=true];

protocol buffer还允许你自定义options。这是个高级特性,大多数人并不需要。options其实都定义在 google/protobuf/descriptor.proto文件中。

自定义的options是简单的,继承这些messages

import "google/protobuf/descriptor.proto";

extend google.protobuf.MessageOptions {

optional string my_option = 51234;

}

message MyMessage {

option (my_option) = "Hello world!";

}

这里我们定义了一个message级别的消息选项,当使用这个options的时候,选项的名称必须用括号括起来,以表明它是一个extension。

我们在C++中读取my_option的值就像下面这样:

string value = MyMessage::descriptor()->options().GetExtension(my_option);

这里,MyMessage::descriptor()->options()返回的MessageOptions protocol类型 message。

读取自定义就如同读取继承属性一样。

在Java中

String value = MyProtoFile.MyMessage.getDescriptor().getOptions().getExtension(MyProtoFile.myOption);

自定义options可以对任何message的组成元素进行定义

import "google/protobuf/descriptor.proto";

extend google.protobuf.FileOptions {

optional string my_file_option = 50000;

}

extend google.protobuf.MessageOptions {

optional int32 my_message_option = 50001;

}

extend google.protobuf.FieldOptions {

optional float my_field_option = 50002;

}

extend google.protobuf.EnumOptions {

optional bool my_enum_option = 50003;

}

extend google.protobuf.EnumValueOptions {

optional uint32 my_enum_value_option = 50004;

}

extend google.protobuf.ServiceOptions {

optional MyEnum my_service_option = 50005;

}

extend google.protobuf.MethodOptions {

optional MyMessage my_method_option = 50006;

}

option (my_file_option) = "Hello world!";

message MyMessage {

option (my_message_option) = 1234;

optional int32 foo = 1 [(my_field_option) = 4.5];

optional string bar = 2;

}

enum MyEnum {

option (my_enum_option) = true;

FOO = 1 [(my_enum_value_option) = 321];

BAR = 2;

}

message RequestType {}

message ResponseType {}

service MyService {

option (my_service_option) = FOO;

rpc MyMethod(RequestType) returns(ResponseType) {

// Note: my_method_option has type MyMessage. We can set each field

// within it using a separate "option" line.

option (my_method_option).foo = 567;

option (my_method_option).bar = "Some string";

}

}

如果想使用在package里面的自定义的option,必须要option前使用包名,如下

// foo.proto

import "google/protobuf/descriptor.proto";

package foo;

extend google.protobuf.MessageOptions {

optional string my_option = 51234;

}

// bar.proto

import "foo.proto";

package bar;

message MyMessage {

option (foo.my_option) = "Hello world!";

}

最后一件事:既然自定义的options是extensions,他们必须指定field number就像其它field或者extension一样。如果你要在公共应用中使用自定义的options,那么一定要确认你的field numbers是全局唯一的

你能通过多选项带有一个extension 把它们放入一个子message中

message FooOptions {

optional int32 opt1 = 1;

optional string opt2 = 2;

}

extend google.protobuf.FieldOptions {

optional FooOptions foo_options = 1234;

}

// usage:

message Bar {

optional int32 a = 1 [(foo_options.opt1) = 123, (foo_options.opt2) = "baz"];

// alternative aggregate syntax (uses TextFormat):

optional int32 b = 2 [(foo_options) = { opt1: 123 opt2: "baz" }];

}

生成class代码

为了生成java、python、C++代码,你需要运行protoc编译器 protoc 编译.proto文件。

编译器运行命令:

protoc --proto_path=IMPORT_PATH --cpp_out=DST_DIR --java_out=DST_DIR --python_out=DST_DIR path/to/file.proto

import_path 查找proto文件的目录,如果省略的话,就是当前目录。存在多个引入目录的话,可以使用--proto_path参数来多次指定,

-I=IMPORT_PATH就是--proto_path的缩写

输出目录

--cpp_out 生成C++代码在DST_DIR目录

--java_out 生成Java代码在DST_DIR目录

--python_out 生成Python代码在DST_DIR目录

有个额外的好处,如果DST是.zip或者.jar结尾,那么编译器将会按照给定名字输入到一个zip压缩格式的文件中。

输出到.jar会有一个jar指定的manifest文件。注意 如果输出文件已经存在,它将会被覆盖;编译器的智能不足以自动添加文件到一个存在的压缩文件中。

你必须提供一个或者多个.proto文件用作输入。虽然文件命名关联到当前路径,每个文件必须在import_path路径中一边编译器能规定它的规范名称

更新message如果一个message 不再满足所有需要,需要对字段进行调整.(举例:对message增加一个额外的字段,但是仍然有支持旧格式message的代码在运行)

要注意以下几点:

1、不要修改已经存在字段的数字顺序标示

2、可以增加optional或者repeated的新字段。这么做以后,所有通过旧格式message序列化的数据都可以通过新代码来生成对应的对象,正如他们不会丢失任何required元素。

你应该为这些元素添加合理的默认值,以便新代码可以与旧代码生成的消息交互。 新代码创建的消息中旧代码不存在的字段,在解析的时候,旧代码会忽略掉新增的字段。

无论如何,未知的field不会被丢弃,如果message晚点序列化,为。

注意 未知field对于Python来说当前不可用。

3、非required字段都可以转为extension ,反之亦然,只要type和number保持不变。

4、int32, uint32, int64, uint64, and bool 是全兼容的。这意味着你能改变一个field从这些类型中的一个改变为另一个,而不用考虑会打破向前、向后兼容性。

如果一个数字是通过网络传输而来的相应类型转换,你将会遇到type在C++中遇到的问题(e.g. if a 64-bit number is read as an int32, it will be truncated to 32 bits)

5、sint32 and sint64 彼此兼容,但是不能兼容其它integer类型.

6、string and bytes 在UTF-8编码下是兼容的.

7、如果bytes包含一个message的编码,内嵌message与bytes兼容.

8、fixed32 兼容 sfixed32, fixed64 兼容 sfixed64.

9、optional 兼容 repeated. 用一个repeat字段的编码结果作为输入,认为这个字段是可选择的客户端会这样处理,如果是原始类型的话,获得最后的输入作为相应的option值;如果是message 类型,合并所有输入元素.

10、更改默认值通常是OK的.要记得默认值并不会通过网络发送,如果一个程序接受一个特定字段没有设置值的消息,应用将会使用自己的版本协议定义的默认值,不会看见发送者的默认值.

2012年11月24日

Meta的client实现分析

由于meta不像activeMQ等产品,它们的broker端承载了非常多的功能,而像meta这样追求性能为目的的消息中间件,则是把broker端的功能弱化,同时加强了client端的某些功能,如当前client的消息offset的存储、从broker中pull消息等。

下面我们从消息pull这样一个client端最重要的功能作为分析的主线来了解meta中client的实现。

下面是client端执行pull消息的处理流程示意图:

1.通过ZKLoadRebalanceListener的rebalance方法,根据该client所订阅topic的分区数量来初始化对应数量的FetchRequest实例,并把它们放到FetchRequestQueue中(先进先出)。

2.消息抓取管理器初始化fetchRunners线程池,并启动所有线程对FetchRequestQueue进行读请求的操作。

3.当FetchRequestQueue中有请求时,则执行FetchRequestRunner线程中的processRequest方法,进行后续的操作。

4.通过SimpleMessageConsumer(消息消费者基类)的fetch方法从broker端获取某topic的某分区的消息数据byte组。

5.对broker端返回的消息数据byte组进行操作,解析出一条条消息,并对这些消息进行消费,具体代码实现在FetchRequestRunner类的notifyListener方法,它是消息消费的核心方法,后面我们会重点介绍。

6.FetchRequestRunner处理完一次从broker获取消息并消费的过程后,会把FetchRequest实例重新放回FetchRequestQueue中,重复进行下一轮操作。

上面是client端pull消息的主过程,由于meta的client涉及的功能也较多,为了更进一步了解client端的实现细节,我们从下面几个方面做更进一步的分析

pull模型的轮训时间

很多用户在一看到消息的获取是通过client端主动pull的方式,就感觉和activeMQ等其他消息中间件所采用的broker主动推送消息到client的方式相比较,实时性有所降低。但通过对meta源码的分析,发现它的实时性还是可以保证的,具体实现方法分析如下:

轮训时间的控制在FetchRequestQueue类的take方法中的如下几行代码:

final long delay = first.getDelay(TimeUnit.NANOSECONDS); if (delay > 0) { final long tl = this.available.awaitNanos(delay); }

delay值的设置是按照下面规则进行的:

- 初始化为0,所以第一次该请求会立即和broker端通讯,以获得消息组。

- 大部分情况下pull的轮训间隔为0,所以它的实时性还是可以保证的。

Meta使用zookeeper的细节

meta对zookeeper非常依赖,而且重要的信息同步都是通过它完成的,官方文档对这一块的说明也不多,所以,我们对meta的分析就从这开始,当我们清晰meta中zookeeper的使用细节后,meta的内部实现原理也就基本清晰了。

meta里使用zookeeper最典型的就是类ZKLoadRebalanceListener的 rebalance()方法,该方法使用到了很多zookeeper的znode,下面我们对这个方面做一个详细介绍:

rebalance方法是用来计算某消息消费者具体应该消费哪个meta服务器节点上的哪些分区中的消息(也就是“消费者的负载平衡”)。该方面在下面两种情况下被触发:

- 监视同一个消费者分组的consumer列表是否有变化;

- 监视订阅的topic下的broker节点是否有新增或删除;

当上面两种情况发生时,zookeeper的机制会自动触发到rebalance方法,它的具体算法如下:

1.从zookeeper的'/meta/consumers/某消费者组/ids/某消费者id'节点上获取该消费者的所有订阅了的主题;

2.从zookeeper的'/meta/brokers/ids'节点上获取所有的broker列表;

3.从zookeeper的'/meta/consumers/某消费者组/ids/'、'/meta/consumers/某消费者组/ids/某消费者id'这两个节点中获得每个topic下有哪些消费者;

4.从zookeeper的'/meta/brokers/topics/某topic'节点获得对应topic在broker(包括:master和slaves)里有哪些partition;

5.从上面获得的所有这些信息,调用类ZKLoadRebalanceListener中getRelevantTopicMap方法,判断最新的partition列表或consumer列表和当前在用的是否有变化,如果没有变化则再补充做一个动作(因为虽然partition和consumer都没有新增或删除,但可能cluster的结构发生变化了):对集群做一个比较,看是否有机器down或新增;如果没有变化则继续进行后续rebalance操作;

6.如果经过上面的操作确认相关partition列表或consumer列表有变化,则根据'负载均衡策略'获取某个consumer对应的partition列表,然后根据之前老的和最新的partition列表做相关操作,如新分区在zookeeper上的挂载、释放等操作;

上面是client端一个比较重要的功能,也是zookeeper在meta里一个用的较多的地方。

Meta的HA

HA是任何进入生产环境的软件都需要考虑的一个重要因素,meta提供两种HA的方式:同步和异步(推荐使用异步方式)。

官方提供的文档里已经很清晰说明了HA的场景,这里我们再补充一些官方文档中未详细说明的部分:

- meta采用冷备方式来实现HA,任何主、备的切换都得重启相关broker。

- 任何时候只有master可以执行写操作;实现代码在BrokerConnectionListener类的syncedUpdateBrokersInfo方法,该方法从zookeeper上同步最新的master列表供producer使用。

- client可以连接cluster上的任何一台机器包括master和slave,作为它的消息来源,类似数据库的读写分离。

- 如果master因为某种原因当机,则必须手动停止某台slave并对它进行相关配置操作,并启动它使它成为新的master。当那台坏了的master修复后,它将作为一台新的slave加入集群。

- 在master上不停机的情况下新增一个topic,这个新增的topic不能自动的同步到slave上,必须通过某种方式把master上的server.ini同步到所有slave上,然后通过人工重启或通过jmx重启slave。

同步HA的切换过程:

生产环境中有一台master和一个同步slave,slave是不注册到zookeeper上的,当master当机,则所有连接到该broker的生产者和消费者都停止正常工作。然后人工停止slave,并新增samsa_master.properties配置文件,修改其中recoverOffset属性为true。并且修改server.ini中的brokerId为故障master的id,这些修改做完后,重启slave。这样它就成为新的master对外提供服务了。

Meta的transaction实现

对事务的支持是meta的一个重要特点,目前它支持XA和本地事务,下面我们详细对XA事务进行分析,由于本地事务相对简单,可以参考XA的实现。

分布式事务(XA)

分布式事务介绍

分布式事务在分布式应用中是非常重要的,目前分布式事务的实现标准是XA,而在java体系中就是JTA标准。下面是XA的一个示意图:

这里我们重点说一下两阶段提交协议(2PC),它是XA的核心思想,具体示意图如下:

具体更多关于XA的细节请参考XA的接口规范。

meta的实现

meta里事务的实现主要是如下几个类:

- TransactionalCommandProcessor:事务命令处理器。它主要作用是接收client端发过来的各种请求,如beginTransaction、prepare、commit、rollback、新增消息等。

- JournalTransactionStore:基于文件方式的事务存储引擎。

- JournalStore:具体存储事务的文件存储类。

它们3者之间的关系是:TransactionalCommandProcessor接收client端的各种事务请求,然后调用JournalTransactionStore进行事务存储,JournalTransactionStore根据不同的client请求调用JournalStore具体保存事务信息到磁盘文件。

下面通过一个示意图来进一步进行说明:

client通过调用beginTransaction来新开始一个事务(在meta里就是一个Tx实例),并把它放在JournalTransactionStore类的inflightTransactions队列里,然后client就可以在这个Tx中新增消息,但这些新增的消息是放在JournalStore文件里,并且完整的保存在内存中(由于meta目前没有专门的内存管理机制,当事务数量特别大的时候,这个地方有可能会出现内存溢出)。当client进行2PC中的prepare时,事务从inflightTransactions队列移到preparedTransactions队列,并保存相关信息到JournalStore。当执行commit时,该Tx的所有消息才真正放到MessageStore里供消息消费者读取。当client端发起rollback请求后,Tx被从preparedTransactions队列中删除,并保存相关信息到JournalStore。

下面我们对meta事务实现的几个重要方面做一个详细介绍:

beginTransaction

当client端的TransactionContext(XAResource的实现)调用start方法,broker接收到请求后,启动一个新事务。

新增消息

处理序列图如下:

当事务begin后,client端向broker发送多条消息存储的请求,broker收到请求后会调用JournalTransactionStore的addMessage方法。该方法把请求存储在事务日志文件中(JournalStore),同时新建或找到对应的Tx实例,把这些消息存储请求保存在内存中。这里注意一点,在事务没有提交之前,这些消息存储是不会被放到对应topic消息存储文件中去的。

prepare的处理过程

处理序列图如下:

prepare的处理过程相对简单些,它只是把Tx实例从JournalTransactionStore类的inflightTransactions中移除到preparedTransactions中,同时在事务日志文件存储相关信息。

commit的处理过程

处理序列图如下:

commit过程相当复杂点。broker收到client端的commit请求,调用JournalTransactionStore的commit方法,从preparedTransactions里找到对应的Tx,把该Tx里的所有请求命令(PutCommand),按照topic和分区分别保存到真正的topic消息存储文件中去,当全部保存完时,就会通过回调类AppendCallback的appendComplete方法记录commit日志到事务日志文件。

recover的处理过程

处理序列图如下:

recover操作发生在系统重启的时候,主要是为了还原系统上一次停止时候的事务场景,如还原处在prepare阶段的事务,rollback所有本地事务和没有prepare的XA事务。recover的处理细节包括两部分:

- 在JournalTransactionStore的构造函数中进行JournalStore的recover操作

JournalStore的recover主要是完成从事务日志文件中按照最近的checkpoint从日志中读取所有的日志记录,并按照记录的类型APPEND_MSG和TX_OP分别进行还原操作:

APPEND_MSG类型

这种类型的日志记录就调用JournalTransactionStore的addMessage方法,但是不会往日志文件中重复记录该消息了。

TX_OP类型

这种类型的处理相当复杂点。它根据日志记录的类型又细分为下面几种

XA_PREPARE:根据TransactionId把对应的Tx实例从JournalTransactionStore类的inflightTransactions中移到preparedTransactions中。

XA_COMMIT和LOCAL_COMMIT:根据TransactionId从JournalTransactionStore类的inflightTransactions或preparedTransactions中找到对应的Tx实例。把该Tx内的所有消息请求对比相应topic消息存储文件中消息,如果topic消息存储文件中不存在这些消息则新增,如果存在则通过crc32校验码进行比对。

LOCAL_ROLLBACK和XA_ROLLBACK:根据TransactionId把对应的Tx实例从JournalTransactionStore类的inflightTransactions或preparedTransactions中删除。

在TransactionalCommandProcessor的init方法中调用JournalTransactionStore类的recover操作

经过上面的recover操作后,它已经把meta重启前的事务现场在JournalTransactionStore和JournalStore中进行了还原。接下来就是TransactionalCommandProcessor类的事务现场还原,这个过程是把JournalTransactionStore类的preparedTransactions中的所有Tx在TransactionalCommandProcessor中进行还原,该过程相对简单,可参考源码实现。

经过上面这些recover步骤后,meta作为XAResource就可以继续加入XA事务了。

2012年11月23日

Meta相比于kafka的一个重要特性就是消息高可用方案的实现,我们称之为HA方案。消息在发送到broker之后立即写入磁盘才返回客户端告诉消息生产者消息发送成功,通过unflushThreshold和unflushInterval两个参数的控制,可以保证单机消息数据的安全性,只要机器的磁盘没有永久损坏,消息总可以在重启后恢复并正常投递给消费者们。但是,如果遇到了磁盘永久损坏或者数据文件永久损坏的情况,那么该broker上的消息数据将可能永久丢失。为了防止这种情况的发生,一个可行的方案就是将消息数据复制到多台机器,类似mysql的主从复制功能。

同步复制和异步复制

meta提供类似mysql主从复制的异步复制和同步功能,分别对应不同的可靠级别。理论上说同步复制能带来更高的可靠级别,异步复制因为延迟的存在,可能会丢失极少量的消息数据,相应地,同步复制会带来性能的损失,因为要同步写入两台甚至更多的broker机器上才算写入成功。

在实际实践中,**我更推荐采用异步复制的架构**,因为异步复制的架构相对简单,并且易于维护和恢复,对性能也没有影响。而同步复制对运维要求相对很高,机制复杂容易出错,故障恢复也比较麻烦。**异步复制加上磁盘做磁盘阵列**,足以应对非常苛刻的数据可靠性要求。

异步复制配置

假设你已经根据如何开始这份文档配置了一台broker服务器,并且配置了一个topic为test,现在你希望test能复制到另一台slave broker上来保证消息数据的高可用。你可以这样做:

1.首先,你需要部署一个新的broker,具体仍然参照如何开始这份文档,配置server.ini从master broker拷贝一份。

2.其次,配置slave文件。编辑conf/async_slave.properties:

#slave编号,大于等于0表示作为slave启动,同一个master下的slave编号应该设不同值.

slaveId=0

#作为slave启动时向master订阅消息的group,如果没配置则默认为meta-slave-group

#不同的slaveId请使用不同的group

slaveGroup=meta-slave-group

#slave数据同步的最大延时,单位毫秒

slaveMaxDelayInMills=500

#是否自动从master同步server.ini, 1.4.2新增选项

#第一次仍然需要自己拷贝server.ini,后续可以通过设置此选项为true来自动同步

autoSyncMasterConfig=true

配置参数的含义请自己看注释。可见,一个master可以复制到多个slave。

3.执行下列命令启动slave:

bin/metaServer.sh start slave

4.第一次复制因为需要跟master完全同步需要耗费一定时间,你可以在数据文件的目录观察复制情况。

5.**请注意,异步复制的slave将参与消费者的消费活动,消息消费者可以从slave中获取消息并消费,消费者会随机从master和slaves中挑选一台作为消费broker。**

6.**请注意,从1.4.2开始,可以通过autoSyncMasterConfig选项配置是否自动同步master的server.ini到异步复制的slave上,当master的server.ini文件变更并通过bin/metaServer.sh reload之后,slave将监控到这一变更并自动同步。**

异步复制的局限

- 异步复制有延迟,虽然可以通过设定

slaveMaxDelayInMills来控制延迟。

异步复制的故障处理

- Master永久故障: 将slave作为master启动,去除启动参数中的slave即可,也就是

metaServer.sh restart

- Slave永久故障: 启动新的broker并配置作为master新的slave启动。

同步复制配置

Meta假定producer、broker和consumer都是分布式的集群系统。

Producer可以是一个集群,多台机器上的producer可以往同一个topic发送消息。

Meta的服务器broker一般也是一个集群,多台broker组成一个集群提供一些topic服务,生产者按照一定的路由规则往集群里某台broker发送消息,消费者按照一定的路由规则拉取某台broker上的消息。

Consumer也可以组织成一个集群来消费同一个topic,发往这个topic的消息按照一定的路由规则发送到consumer集群里的某一台机器。Consumer集群每个consumer必须拥有相同的分组名称。

Broker集群配置

Broker集群配置非常容易,假设你已经按照如何开始和服务器配置管理配置好并启用了你第一台broker,某一天你发现这个单台broker无法支撑更大的消息量,那么你可能就需要引入更多的broker作为集群来提供服务,你要做的事情很简单:

- 拷贝broker1的配置文件

conf/server.ini到新的broker,假设为broker2。 - 修改broker2的server.ini,只要修改brokerId为另一个不同于broker1的值即可

- 启动broker2,这样一来broker2将和broker1组成一个服务器集群

- 在这个过程中你不需要重启任何现有的服务,包括生产者、消费者和broker1,他们都将自动感知到新的broker2

可见,配置一个集群唯一要做的就是使用同一份配置文件并定义不同的brokerId即可。

负载均衡

负载均衡和failover分不开,我们将分别讨论下生产者和消费者的负载均衡策略。我们先假定broker是一个集群,这样每个topic必定有多个分区。

生产者的负载均衡和failover

每个broker都可以配置一个topic可以有多少个分区,但是在生产者看来,一个topic在所有broker上的的所有分区组成一个分区列表来使用。

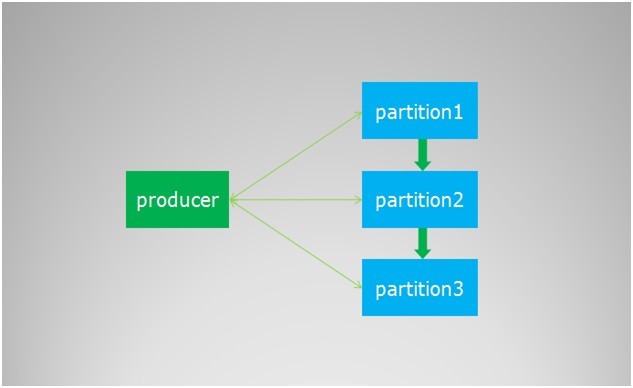

在创建producer的时候,客户端会从zookeeper上获取publish的topic对应的broker和分区列表,生产者在发送消息的时候必须选择一台broker上的一个分区来发送消息,默认的策略是一个轮询的路由规则,一张图来表示

生产者在通过zk获取分区列表之后,会按照brokerId和partition的顺序排列组织成一个有序的分区列表,发送的时候按照从头到尾循环往复的方式选择一个分区来发送消息。考虑到我们的broker服务器软硬件配置基本一致,默认的轮询策略已然足够。

如果你想实现自己的负载均衡策略,可以实现上文提到过的PartitionSelector接口,并在创建producer的时候传入即可。

在broker因为重启或者故障等因素无法服务的时候,producer通过zookeeper会感知到这个变化,将失效的分区从列表中移除做到fail over。因为从故障到感知变化有一个延迟,可能在那一瞬间会有部分的消息发送失败。

消费者的负载均衡

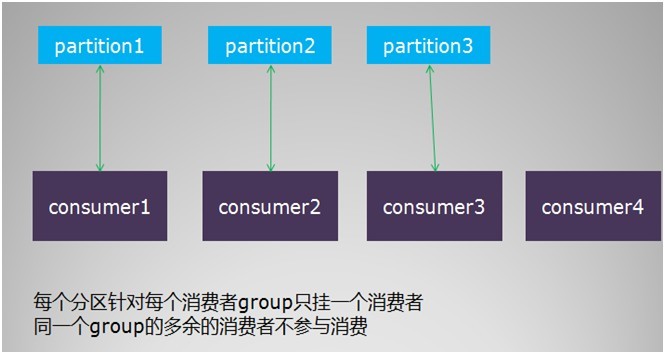

消费者的负载均衡会相对复杂一些。我们这里讨论的是单个分组内的消费者集群的负载均衡,不同分组的负载均衡互不干扰,没有讨论的必要。 消费者的负载均衡跟topic的分区数目紧密相关,要考察几个场景。 首先是,单个分组内的消费者数目如果比总的分区数目多的话,则多出来的消费者不参与消费,如图

其次,如果分组内的消费者数目比分区数目小,则有部分消费者要额外承担消息的消费任务,具体见示例图如下

综上所述,单个分组内的消费者集群的负载均衡策略如下

- 每个分区针对同一个group只挂载一个消费者

- 如果同一个group的消费者数目大于分区数目,则多出来的消费者将不参与消费

- 如果同一个group的消费者数目小于分区数目,则有部分消费者需要额外承担消费任务

Meta的客户端会自动帮处理消费者的负载均衡,它会将消费者列表和分区列表分别排序,然后按照上述规则做合理的挂载。

从上述内容来看,合理地设置分区数目至关重要。如果分区数目太小,则有部分消费者可能闲置,如果分区数目太大,则对服务器的性能有影响。

在某个消费者故障或者重启等情况下,其他消费者会感知到这一变化(通过 zookeeper watch消费者列表),然后重新进行负载均衡,保证所有的分区都有消费者进行消费。

示例配置

示例文件存放位置: metaq文件目录/conf/sample.server.ini服务端配置

Meta服务端配置主要在服务器conf目录下的server.ini文件,整体配置分为三部分:系统参数、zookeeper参数以及topic配置。系统参数在system section,zookeeper参数配置在zookeeper section,而topic的配置是在topic=xxxx section。具体说明如下:

系统参数部分

系统参数配置都放在[system]下面:

- brokerId: 服务器集群中唯一的id,必须为整型0-1024之间。对服务器集群的定义是使用同一个zookeeper并且在zookeeper上的root path相同,具体参见zookeeper配置。

hostName: 服务器hostname,默认取本机IP地址,如果你是多网卡机器,可能需要明确指定。服务器会将此hostname加上端口写入到zookeeper提供给客户端发现。

serverPort:服务器端口,默认8123。PS. 选择8123是因为这蕴含着作者儿子的生日。

numPartitions:系统默认情况下每个topic的分区数目,默认为1,可被topic配置覆盖。单个服务器的总分区数目不建议超过1000,太多将导致频繁的磁盘寻道严重影响IO性能。

dataPath: 服务器数据文件路径,默认在~home/meta下,每个topic可以覆盖此配置,对于多块磁盘的机器,可设置不同topic到不同磁盘来提升IO效率。

dataLogPath:数据日志文件路径,主要存放事务日志,默认跟dataPath一致,最好单独设置到不同的磁盘或者目录上。如果为空,使用指定的dataPath

getProcessThreadCount: 处理get请求的并发线程数,默认为CPUS*10。

putProcessThreadCount: 处理put请求的并发线程数,默认为CPUS*10。

maxSegmentSize: 单个数据文件的大小,默认为1G。默认无需修改此选项。

maxTransferSize: 传输给消费者的最大数据大小,默认为1M,请根据你的最大消息大小酌情设置,如果太小,每次无法传输一个完整的消息给消费者,导致消费者消费停滞。可设置成一个大数来取消限制。

1.4.3引入的新参数:

acceptPublish: 是否接收消息,默认为true;如果为false,则不会注册发送信息到zookeeper上,客户端当然无法发送消息到该broker。本参数可以被后续的topic配置覆盖。

acceptSubscribe: 与acceptPublish类似,默认也为true;如果为false,则不会注册消费信息到zookeeper上,消费者无法发现该broker,当然无法从该broker消费消息。本参数可以被后续的topic配置覆盖。

数据可靠性参数

Meta保证消息可靠性是建立在磁盘可靠性的基础上,发送的每一条消息都保证是在“写入磁盘”的情况下才返回给客户端应答。这里有两个关键参数可以控制:

- unflushThreshold: 每隔多少条消息做一次磁盘sync,强制将更改的数据刷入磁盘。默认为1000。也就是说在掉电情况下,最多允许丢失1000条消息。可设置为0,强制每次写入都sync。在设置为0的情况下,服务器会自动启用group commit技术,将多个消息合并成一次sync来提升IO性能。经过测试,group commit情况下消息发送者的TPS没有受到太大影响,但是服务端的负载会上升很多。

- unflushInterval: 间隔多少毫秒定期做一次磁盘sync,默认是10秒。也就是说在服务器掉电情况下,最多丢失10秒内发送过来的消息。不可设置为小于或者等于0。

请注意,上述两个参数都可以被topic单独配置说覆盖,也就是说每个topic可以配置不同的数据可靠级别。

数据删除策略配置

默认情况下,meta是会保存不断添加的消息,然后定期对“过期”的数据进行删除或者归档处理,这都是通过下列参数控制的:

deleteWhen: 何时执行删除策略的cron表达式,默认是 0 0 6,18 * * ? ,也就是每天的早晚6点执行处理策略。- deletePolicy: 数据删除策略,默认超过7天即删除,这里的168是小时,10s表示10秒,10m表示10分钟,10h表示10小时,不明确指定单位默认为小时。

delete是指删除,超过指定时间的数据文件将被彻底从磁盘删除。也可以选择archive策略,即不对过期的数据文件做删除而是归档,当使用archive策略的时候可以选择是否压缩数据文件,如167,archive,true即选择将更改时间超过7天的数据文件归档并压缩为zip文件,如果不选择压缩,则重命名为扩展名为arc的文件。

上述两个参数都可以被topic单独配置所覆盖,也就是每个topic可以指定自己独特的删除策略。通常来说,对于不重要的topic可以将更早地将他们删除来节省磁盘空间。

事务相关配置

- maxCheckpoints: 最大保存事务checkpoint数目,默认为3,服务器在启动的时候会从最近一次checkpoint回访事务日志文件,恢复重启前的事务状态。不建议修改此参数。

- checkpointInterval:事务checkpoint时间间隔,单位毫秒,默认1小时。间隔时间太长,会导致启动的时候replay事务日志占用了太多时间,太短则可能影响到性能。

- maxTxTimeoutTimerCapacity:最大事务超时timer的数量。服务端会为每个事务启动一个定时器监控事务是否超时,定时器的数目上限通过本参数限制。限制了本参数,也变相地控制了最大可运行的事务数。默认为30000个。

- maxTxTimeoutInSeconds:最大事务超时时间,单位为秒,默认为60秒。客户端设置的事务超时时间不能超过此设定,超过将被强制限制为此设定。

- flushTxLogAtCommit:服务端对事务日志的sync策略,0表示让操作系统决定,1表示每次commit都刷盘,2表示每隔1秒刷盘一次。此参数严重影响事务性能,可根据你需要的性能和可靠性之间权衡做出一个合理的选择。通常建议设置为2,表示每隔1秒刷盘一次,也就是最多丢失一秒内的运行时事务。这样的可靠级别对大多数服务是足够的。最安全的当然是设置为1,但是将严重影响事务性能。而0的安全级别最低。安全级别上

1>=2>0,而性能则是0 >= 2 > 1。

zookeeper配置

meta服务端会将自身id,topic信息和socket地址发送到zookeeper上,让客户端可以发现并连接服务器。Zookeeper相关的配置放在[zookeeper]模块下面:

- zk.zkEnable: 是否启用zookeeper,也就是是否将信息注册到zookeeper上。默认为true。对于同步复制的slave来说,本参数会被强制设置为false。

- zk.zkConnect: zookeeper服务器列表,例如

localhost:1281这样的字符串。默认也是localhost:2181。请设置你的zk集群地址列表。 - zk.zkSessionTimeoutMs: zookeeper的session timeout,默认为30秒。单位毫秒。

- zk.zkConnectionTimeoutMs: zookeeper的连接超时时间,默认同样为30秒,单位毫秒。

- zk.zkSyncTimeMs: 预期的zk集群间数据同步延迟,默认为5秒,这个参数对服务器无意义。

Topic配置

服务器将提供哪些topic服务都是通过topic配置来实现的,topic配置都是在[topic=xxx]的模块下面,其中xxx就是topic名称,一个示范配置如下:

[topic=meta-test]

stat=true

numPartitions=1

这里配置了一个名为meta-test的topic,并针对该topic启用实时统计,并将topic的在本服务器的分区数目设置为1。可见,topic配置可覆盖服务器的部分配置,包括:

- stat:是否启用实时统计,启用则会在服务端对该topic的请求做实时统计,可以通过stats topic-name协议观察到该topic运行状况,可选。

- numPartitions: 该topic在本服务器的分区总数,覆盖系统配置,可选。

- unflushInterval:每隔多少条消息做一次磁盘sync,覆盖系统配置,可选。

- unflushThreshold:每隔多少秒做一次磁盘sync,覆盖系统配置,可选。

- deletePolicy:topic的删除策略,覆盖系统配置,可选。

- deleteWhen:删除策略的执行时间,覆盖系统配置,可选。

- dataPath:设置数据文件路径,覆盖系统配置,可选。

1.4.3新增参数:

- acceptPublish: 是否接收该topic的消息,覆盖系统配置,可选。

- acceptSubscribe: 是否接受消费者的订阅,覆盖系统配置,可选。

新增Topic热部署

在新增或者删除topic并保存server.ini之后,可以通过下列命令热加载新的配置文件并生效: bin/metaServer.sh reload

Java客户端例子

使用maven,引用metaq的java client非常简单:

<dependency>

<groupId>com.taobao.metamorphosis</groupId>

<artifactId>metamorphosis-client-extension</artifactId>

<version>1.4.3</version>

</dependency>

也可以引用 client-extend

<dependency>

<groupId>com.taobao.metamorphosis</groupId>

<artifactId>metamorphosis-client-extension</artifactId>

<version>1.4.3</version>

</dependency>

直接用git 将metamorphosis-example clone 下载页面:https://github.com/killme2008/metamorphosis-example 。

请注意,1.4.3及以上版本的java客户端只能连接1.4.3及以上版本的MetaQ服务器,而1.4.3之前的老客户端则没有限制。主要是因为1.4.3引入了发布和订阅topic的分离,1.4.3的新客户端只能查找到新版本的broker

消息会话工厂类

在使用消息生产者和消费者之前,需要用到消息会话工厂类——MessageSessionFactory,由这个工厂帮你创建生产者或者消费者。除了这些,MessageSessionFactory还默默无闻地在后面帮你做很多事情,包括:

1.服务的查找和发现,通过diamond和zookeeper帮你查找日常的meta服务器地址列表,diamond可以忽略。

2.连接的创建和销毁,自动创建和销毁到meta服务器的连接,并做连接复用,也就是到同一台meta的服务器在一个工厂内只维持一个连接。

3.消费者的消息存储和恢复。

4.协调和管理各种资源,包括创建的生产者和消费者的。

因此,我们首先需要创建一个会话工厂类,MessageSessionFactory仅是一个接口,它的实现类常用的是MetaMessageSessionFactory:

MessageSessionFactory sessionFactory = new MetaMessageSessionFactory(new MetaClientConfig());

请注意,

MessageSessionFactory应当尽量复用,也就是作为应用中的单例来使用,简单的做法是交给spring之类的容器帮你托管。

消息生产者

package com.taobao.metamorphosis.example;

import java.io.BufferedReader;

import java.io.InputStreamReader;

import com.taobao.metamorphosis.Message;

import com.taobao.metamorphosis.client.MessageSessionFactory;

import com.taobao.metamorphosis.client.MetaClientConfig;

import com.taobao.metamorphosis.client.MetaMessageSessionFactory;

import com.taobao.metamorphosis.client.producer.MessageProducer;

import com.taobao.metamorphosis.client.producer.SendResult;

import com.taobao.metamorphosis.utils.ZkUtils.ZKConfig;

public class Producer {

public static void main(String[] args) throws Exception {

final MetaClientConfig metaClientConfig = new MetaClientConfig();

final ZKConfig zkConfig = new ZKConfig();

//设置zookeeper地址

zkConfig.zkConnect = "127.0.0.1:2181";

metaClientConfig.setZkConfig(zkConfig);

// New session factory,强烈建议使用单例

MessageSessionFactory sessionFactory = new MetaMessageSessionFactory(metaClientConfig);

// create producer,强烈建议使用单例

MessageProducer producer = sessionFactory.createProducer();

// publish topic

final String topic = "matatest";

producer.publish(topic);

BufferedReader reader = new BufferedReader(new InputStreamReader(System.in));

String line = null;

while ((line = reader.readLine()) != null) {

// send message

SendResult sendResult = producer.sendMessage(new Message(topic, line.getBytes()));

// check result

if (!sendResult.isSuccess()) {

System.err.println("Send message failed,error message:" + sendResult.getErrorMessage());

}

else {

System.out.println("Send message successfully,sent to " + sendResult.getPartition());

}

}

}

}

消息生产者的接口是MessageProducer,你可以通过它来发送消息。创建生产者很简单,通过MessageSessionFactory的createProducer方法即可以创建一个生产者。在Meta里,每个消息对象都是Message类的实例,Message表示一个消息对象,它包含这么几个属性:

- id: Long型的消息id,消息的唯一id,系统自动产生,用户无法设置,在发送成功后由服务器返回,发送失败则为0。

- topic: 消息的主题,订阅者订阅该主题即可接收发送到该主题下的消息,生产者通过指定发布的topic查找到需要连接的服务器地址,必须。

- data: 消息的有效载荷,二进制数据,也就是消息内容,meta永远不会修改消息内容。消息内容通常限制在1M以内,作者的建议是最好不要发送超过上百K的消息,必须。数据是否压缩也完全取决于使用方。

- attribute: 消息属性,一个字符串,可选。生产者可通过设置消息属性来让消费者简单过滤。

在sendMessage之前必须调用 MessageProducer的publish(topic)方法

producer.publish(topic);

这一步在发送消息前是必要的,必须先发布将要发送消息的topic(另外,metaq的broker必须要先通过配置文件设置好topic,启动broker后,客户端才可能发布消息成功,不然就会报出异常),这是为了让会话工厂帮你去查找接收这些topic的meta服务器地址并初始化连接。这个步骤针对每个topic只需要做一次,多次调用无影响。

总结下这个例子,从标准输入读入你输入的数据,并将数据封装成一个Message对象,发送到[localhost:8123]服务的 topic为metatestbroker 上。

请注意,MessageProducer是线程安全的,完全可重复使用,因此最好在应用中作为单例来使用,一次创建,到处使用,配置为spring里的singleton bean。MessageProducer创建的代价昂贵,每次都需要通过zk查找服务器并创建tcp长连接。

消息消费者

发送消息后,消费者可以接收消息了,下面的代码创建异步消费者并订阅test这个主题,等待消息送达并打印消息内容

package com.taobao.metamorphosis.example;

import java.util.concurrent.Executor;

import com.taobao.metamorphosis.Message;

import com.taobao.metamorphosis.client.MessageSessionFactory;

import com.taobao.metamorphosis.client.MetaClientConfig;

import com.taobao.metamorphosis.client.MetaMessageSessionFactory;

import com.taobao.metamorphosis.client.consumer.ConsumerConfig;

import com.taobao.metamorphosis.client.consumer.MessageConsumer;

import com.taobao.metamorphosis.client.consumer.MessageListener;

import com.taobao.metamorphosis.utils.ZkUtils.ZKConfig;

public class AsyncConsumer {

public static void main(String[] args) throws Exception {

final MetaClientConfig metaClientConfig = new MetaClientConfig();

final ZKConfig zkConfig = new ZKConfig();

//设置zookeeper地址

zkConfig.zkConnect = "127.0.0.1:2181";

metaClientConfig.setZkConfig(zkConfig);

// New session factory,强烈建议使用单例

MessageSessionFactory sessionFactory = new MetaMessageSessionFactory(metaClientConfig);

// subscribed topic

final String topic = "metatest";

// consumer group

final String group = "meta-example";

// create consumer,强烈建议使用单例

MessageConsumer consumer = sessionFactory.createConsumer(new ConsumerConfig(group));

// subscribe topic

consumer.subscribe(topic, 1024 * 1024, new MessageListener() {

public void recieveMessages(Message message) {

System.out.println("Receive message " + new String(message.getData()));

}

public Executor getExecutor() {

// Thread pool to process messages,maybe null.

return null;

}

});

// complete subscribe

consumer.completeSubscribe();

}

}

通过createConsumer方法来创建MessageConsumer,请注意传入一个ConsumerConfig参数,这是消费者的配置对象。每个消息者都必须有一个ConsumerConfig配置对象,这里只设置了group属性,这是消费者的分组名称。Meta的Producer、Consumer和Broker都可以为集群。消费者可以组成一个集群共同消费同一个topic,发往这个topic的消息将按照一定的负载均衡规则发送给集群里的一台机器。同一个消费者集群必须拥有同一个分组名称,也就是同一个group。我们这里将分组名称设置为meta-example。

订阅消息通过subscribe方法,这个方法接受三个参数

- topic,订阅的主题

- maxSize,因为meta是一个消费者主动拉取的模型,这个参数规定每次拉取的最大数据量,单位为字节,这里设置为1M,默认最大为1M。

- MessageListener,消息监听器,负责消息消息。

MessageListener的接口方法如下:

public interface MessageListener {

/**

* 接收到消息列表,只有message不为空并且不为null的情况下会触发此方法

*

* @param message

*/

public void recieveMessages(Message message);

/**

* 处理消息的线程池

*

* @return

*/

public Executor getExecutor();

}

消息的消费过程可以是一个并发处理的过程,getExecutor返回你想设置的线程池,每次消费都会在这个线程池里进行。recieveMessage方法用于实际的消息消费处理,message参数即为消费者收到的消息,它必不为null。

这里简单地打印收到的消息内容就完成消费。如果在消费过程中抛出任何异常,该条消息将会在一定间隔后重新尝试提交给MessageListener消费。在多次消费失败的情况下,该消息将会存储到消费者应用的本次磁盘,并在后台自动恢复重试消费。

在调用subscribe之后,我们还调用了completeSubscribe方法来完成订阅过程。请注意,subscribe仅是将订阅信息保存在本地,并没有实际跟meta服务器交互,要使得订阅关系生效必须调用一次completeSubscribe,completeSubscribe仅能被调用一次,多次调用将抛出异常。 为什么需要completeSubscribe方法呢,原因有二:

- 首先,subscribe方法可以被调用多次,也就是一个消费者可以消费多种topic

- 其次,如果每次调用subscribe都跟zk和meta服务器交互一次,代价太高

因此completeSubscribe一次性将所有订阅的topic生效,并处理跟zk和meta服务器交互的所有过程。

同样,MessageConsumer也是线程安全的,创建的代价不低,因此也应该尽量复用。

2012年11月22日

1、首先下载最新版本https://github.com/killme2008/Metamorphosis/downloads

2、下载后解压缩

tar -zxvf metamorphosis-server-wrapper-x.x.x.x.tar.gz

3、解压缩后,文件结构如下:

启动脚本放在bin目录,主要的脚本是metaServer.sh,而配置文件主要是conf目录下server.ini,lib存放所有的依赖jar包。

taobao

--metamorphosis-server-wrapper

--bin

env.bat

env.sh

log4j.properties

metaServer.bat

metaServer.sh

tools_log4j.properties

--conf

async_slave.properties

gregor_slave.properties

jettyBroker.properties

notifyadaper

notifySlave.properties

sample.server.ini

samsa_master.properties

server.ini

timetunnel.properties

--lib

4、zookeeper依赖

metamorphosis 必须要依赖zookeeper,也就是说要想启动meta,不能没有zookeeper,使用zookeeper发布和订阅服务,并默认使用zookeeper存储消费者offset 。虽然conf/server.ini 中有这样的说明

;zk配置

[zookeeper]

;是否注册到zk,默认为true

;zk.zkEnable=true

但是笔者尝试将zkEnable属性设置为false,metamorphosis可以启动。但是在client端程序也没找到相应地不依赖于zookeeper的meta的调用方式(可能需要自己实现客户端)。于是乎,还是要下载zookeeper, 如何配置和启动zookeeper,详见地址

假设你在本机安装并启动了一个zookeeper,端口在默认的2181,请修改conf/server.ini文件,保证zookeeper地址正确

;zk的服务器列表

zk.zkConnect=localhost:2181

;zk心跳超时,单位毫秒,默认30秒

zk.zkSessionTimeoutMs=30000

;zk连接超时时间,单位毫秒,默认30秒

zk.zkConnectionTimeoutMs=30000

;zk数据同步时间,单位毫秒,默认5秒

zk.zkSyncTimeMs=5000

其它重要参数,详情见服务器配置

http://www.blogjava.net/livery/articles/391800.htmlbrokerId 服务器唯一标志,必须要有,不能重复

dataPath 指定数据文件路径,默认user.home/meta

dataLogPath 日志文件路径,默认跟dataPath一样

numPartitions 默认topic的分区数目

hostName 服务器hostname,可以为空,默认将取本机IP

serverPort 服务器端口 默认8123

其它具体参数信息请看conf/sample_server.ini示范文件。

5、启动、重启、关闭、检查运行状态

确保你的机器上安装了JDK并正确设置JAVA_HOME和PATH变量。

修改JAVA_HOME,JMX等变量,请修改 bin/env.sh 。

启动服务: bin/metaServer.sh start

重启服务:

bin/metaServer.sh restart

关闭服务:

bin/metaServer.sh stop

查询服务状态

bin/metaServer.sh stats

查询结果

也可以telnet到默认的8123端口执行stats命令查看。

STATS

pid 16637

broker_id 1001

port 8123

uptime 11604

version 1.4.3

slave false

curr_connections 1

threads 125

cmd_put 2050

cmd_get 946

cmd_offset 0

tx_begin 0

tx_xa_begin 0

tx_commit 0

tx_rollback 0

get_miss 944

put_failed 0

total_messages 2050

topics 3

config_checksum 2176933603

END

2012年11月19日

准备替换掉现实服务中使用的activemq,又开始调研消息队列。初步选中metaQ和ZeroMQ,因为这两款听人介绍得很多,耳朵都快出茧子了。

简单研究后,发现这两个消息队列的不同之处太多,不太适合用来对比。ZeroMQ和metaQ都是支持多语言客户端,性能都很好;相对于activemq这种企业级使用的消息队列,提高了消息的处理性能 ,尽量弱化broker 的功能,而ZeroMQ比较极致,甚至去掉了单独broker,采用类库依赖,客户端实现逻辑。

metaQ 的基础逻辑是消息生产者负责创建消息并发送到metaQ 服务器,meta服务器会将消息持久化到磁盘,消息消费者从metaQ服务器拉取消息并提交给应用消费 。与activemq相比弱化了broker的功能,将消息的消费保存、出错、重试等机制都尽可能放在了客户端上;使broker的处理逻辑尽量简单,来提高数据传输和处理的速度。metaQ还支持XA事务;当然XA事务还不是很成熟,另外事务还是对性能有一点影响的。

ZeroMQ并不像是一个传统意义上的消息队列服务器,事实上,它也根本不是一个服务器,它更像是一个底层的网络通讯库,在Socket API之上做了一层封装,将网络通讯、进程通讯和线程通讯抽象为统一的API接口。。所以它的性能也很好,相比metaQ来说,需要自己来实现大量的容错机制的代码。

硬件配置

metaq服务器(activemq也在其中)

型号 DELL 510

CPU Intel(R)Xeon(R) CPU E5606 @ 2.13GHz *4

Mem 12G

网卡 100M

客户端服务器

型号 DELL 710

CPU Intel(R)Xeon(R) CPU E5606 @ 2.13GHz *8

Mem 8G

网卡 100M

例子和相关源码稍后再补充

MessageSessionFactory接口

常用实现类 MetaMessageSessionFactory

MessageProducer接口

常用实现类SimpleMessageProducer

PartitionSelector接口

分区选择器,用于从分区列表中选中将要发送消息的分区。

主要实现类,轮询分区选择器 RoundRobinPartitionSelector

客户端可自定义分区选择器,并在创建生产者的时候注入

SendResult类

发送结果消息类

MessageConsumer接口

主要实现类SimpleMessageConsumer

MessageListener接口

消息监听器,处理消费消息

OffsetStorage接口

offset存储器

默认提供下列三种存储器

1、ZkOffsetStorage 存储在zookeeper

2、MysqlOffsetStorage 存储在mysql数据库

3、LocalOffsetStorage 存储在本地文件,适合消费者分组只有一个消费者的情况,无需共享offset信息。

用户可以自定义实现自己存储器。

客户端最佳实践

复用MessageSessionFactory,最好作为全局单例来使用。

生产者最佳实践

- 尽量复用MessageProducer,最好也是使用单例。可以单个MessageProducer发送多个topic,或者多个MessageProducer每个发送一种topic,尽量减少重复创建producer。

- 消息data的序列化方式锦衣不要使用特定语言的序列化方式(如java序列化),可以考虑 自定义协议、json、protocolbuffer、hessian等序列化协议,以便跨语言消费。

- 实现发送顺序所需要的PartitionSelector,推荐使用业务id。如:交易订单id来取模,分区列表选择固定分区发送。

- 单条消息大小最好限制在100k以下。

- 如无顺序等特殊需求,不要实现自己的PartitionSelector,默认的轮询策略足够。

消费者最佳实践- 尽量复用MessageConsumer,最好也是使用单例。可以单个MessageConsumer订阅多种topic,或者多个MessageConsumer每个订阅一种topic,尽量减少重复创建consumer。

- 单次拉取的数据不宜过大。如果对消息实时性要求较高的应用,应将单次拉取的数据缩小,但至少要大于单条消息的大小。如果对吞吐量要求较高,可以将该值设置大一些。

- 假设消费过程非常轻量级(如:只是打印log),可以不设置MessageListener线程池,减少资源耗费。

- 假设消息发送量巨大,消费能力不高,可适当提高拉取消息线程数 fetchRunnerCount和MessageListener的线程池大小。

- 尽量在消息的消费过程中,扑捉所有异常,减少消息在本地的堆积和恢复,前提是不要遗漏消息。如确实无法处理,请主动抛出异常,以便重试。

2012年11月12日

最近开始调研metamorphosis,官方文档很是详尽。于是边学习边做笔记。

基本概念

消息生产者

也称为Message Producer,一般简称为producer,负责产生消息并发送消息到meta服务器。

消息消费者

也称为Message Consumer,一般简称为consumer,负责消息的消费,meta采用pull模型,由消费者主动从meta服务器拉取数据并解析成消息并消费。

Topic

消息的主题,由用户定义并在服务端配置。producer发送消息到某个topic下,consumer从某个topic下消费消息。

分区(partition)

同一个topic下面还分为多个分区,如meta-test这个topic我们可以分为10个分区,分别有两台服务器提供,那么可能每台服务器提供5个分区,假设服务器分别为0和1,则所有分区为0-0、0-1、0-2、0-3、0-4、1-0、1-1、1-2、1-3、1-4。分区跟消费者的负载均衡机制相关。

Message

消息,负载用户数据并在生产者、服务端和消费者之间传输。

Broker

就是meta的服务端或者说服务器,在消息中间件中也通常称为broker。

消费者分组(Group)

消费者可以是多个消费者共同消费一个topic下的消息,每个消费者消费部分消息。这些消费者就组成一个分组,拥有同一个分组名称,通常也称为消费者集群

Offset

消息在broker上的每个分区都是组织成一个文件列表,消费者拉取数据需要知道数据在文件中的偏移量,这个偏移量就是所谓offset。Offset是绝对偏移量,服务器会将offset转化为具体文件的相对偏移量。

可靠性

Metamorphosis的可靠性保证贯穿客户端和服务器。

生产者的可靠性保证

消息生产者发送消息后返回SendResult,如果isSuccess返回为true,则表示消息已经确认发送到服务器并被服务器接收存储。整个发送过程是一个同步的过程。保证消息送达服务器并返回结果。

服务器的可靠性保证

消息生产者发送的消息,meta服务器收到后在做必要的校验和检查之后的第一件事就是写入磁盘,写入成功之后返回应答给生产者。因此,可以确认每条发送结果为成功的消息服务器都是写入磁盘的。

写入磁盘,不意味着数据落到磁盘设备上,毕竟我们还隔着一层os,os对写有缓冲。Meta有两个特性来保证数据落到磁盘上

- 每1000条(可配置),即强制调用一次force来写入磁盘设备。

- 每隔10秒(可配置),强制调用一次force来写入磁盘设备。

因此,Meta通过配置可保证在异常情况下(如磁盘掉电)10秒内最多丢失1000条消息。当然通过参数调整你甚至可以在掉电情况下不丢失任何消息。

服务器通常组织为一个集群,一条从生产者过来的消息可能按照路由规则存储到集群中的某台机器。Meta已经实现高可用的HA方案,类似mysql的同步和异步复制,将一台meta服务器的数据完整复制到另一台slave服务器,并且slave服务器还提供消费功能(同步复制不提供消费)。

消费者的可靠性保证

消息的消费者是一条接着一条地消费消息,只有在成功消费一条消息后才会接着消费下一条。如果在消费某条消息失败(如异常),则会尝试重试消费这条消息(默认最大5次),超过最大次数后仍然无法消费,则将消息存储在消费者的本地磁盘,由后台线程继续做重试。而主线程继续往后走,消费后续的消息。因此,只有在MessageListener确认成功消费一条消息后,meta的消费者才会继续消费另一条消息。由此来保证消息的可靠消费。

消费者的另一个可靠性的关键点是offset的存储,也就是拉取数据的偏移量。我们目前提供了以下几种存储方案

- zookeeper,默认存储在zoopkeeper上,zookeeper通过集群来保证数据的安全性。

- mysql,可以连接到您使用的mysql数据库,只要建立一张特定的表来存储。完全由数据库来保证数据的可靠性。

- file,文件存储,将offset信息存储在消费者的本地文件中,适合消费者分组只有一个消费者的情况,无需共享offset信息。

Offset会定期保存,并且在每次重新负载均衡前都会强制保存一次。

顺序

很多人关心的消息顺序,希望消费者消费消息的顺序跟消息的发送顺序是一致的。比如,我发送消息的顺序是A、B、C,那么消费者消费的顺序也应该是A、B、C。乱序对某些应用可能是无法接受的。

Metamorphosis对消息顺序性的保证是有限制的,默认情况下,消息的顺序以谁先达到服务器并写入磁盘,则谁就在先的原则处理。并且,发往同一个分区的消息保证按照写入磁盘的顺序让消费者消费,这是因为消费者针对每个分区都是按照从前到后递增offset的顺序拉取消息。

Meta可以保证,在单线程内使用该producer发送的消息按照发送的顺序达到服务器并存储,并按照相同顺序被消费者消费,前提是这些消息发往同一台服务器的同一个分区。为了实现这一点,你还需要实现自己的PartitionSelector用于固定选择分区

public interface PartitionSelector {

public Partition getPartition(String topic, List<Partition> partitions, Message message) throws MetaClientException;

}

选择分区可以按照一定的业务逻辑来选择,如根据业务id来取模。或者如果是传输文件,可以固定选择第n个分区使用。当然,如果传输文件,通常我们会建议你只配置一个分区,那也就无需选择了。

消息的顺序发送可以使用这个OrderedMessageProducer,自定义管理分区信息,并提供故障情况下的本地存储功能。

消息重复

消息的重复包含两个方面,生产者重复发送消息以及消费者重复消费消息。

针对生产者来说,有可能发生这种情况,生产者发送消息,等待服务器应答,这个时候发生网络故障,服务器实际已经将消息写入成功,但是由于网络故障没有返回应答。那么生产者会认为发送失败,则再次发送同一条消息,如果发送成功,则服务器实际存储两条相同的消息。这种由故障引起的重复,meta是无法避免的,因为meta不判断消息的data是否一致,因为它并不理解data的语义,而仅仅是作为载荷来传输。

针对消费者来说也有这个问题,消费者成功消费一条消息,但是此时断电,没有及时将前进后的offset存储起来,则下次启动的时候或者其他同个分组的消费者owner到这个分区的时候,会重复消费该条消息。这种情况meta也无法完全避免。

Meta对消息重复的保证只能说在正常情况下保证不重复,异常情况无法保证,这些限制是由远程调用的语义引起的,要做到完全不重复的代价很高,meta暂时不会考虑。

2012年10月23日

苹果基本授权原理:

为了防止盗版,苹果在所有的iPhone软件中也加入了DRM内容数字版权加密保护技术。类似于iTunes媒体文件,每一个IPA软件都带有DRM。安装程序时,若发现电脑未授权,即私钥不存在,安装程序就会自动终止。若发现授权账号和购买账号不一致,即公钥与私钥不相匹配,安装程序也会自动终止。如果通过某种方法将软件直接塞进设备,运行程序的结果将会是自动退出,ios6开始弹出账号,请求输入账号和密码。这就是数字签名验证。

因此,路人甲购买的软件除了有他账号的人可以使用之外,其他任何人都使用不了(因此想要分享自己购买的软件,分享之前一定要把IPA破解掉)。这样一来,苹果就最大程度上减少了盗版的可能性。

破解软件说明:

破解软件实际上就是去除了DRM保护的软件。破解软件的过程就是去除软件DRM数字签名的过程。

这就是为什么未越狱机器不能安装破解软件的原因。没有公钥,安装程序就会自动停止,并且出现“应用程序"XXX"未安装在iPhone"XXX"上,因为发生未知错误(0xE8008001)”的提示。所以安装破解软件的必要条件就是设备要越狱。设备越狱之后,系统最高权限被打开,系统文件就可以被修改了。安装破解软件,就需要把数字签名验证这一机制给去掉。这就是为什么在安装破解IPA之前,2.X时代要替换MobileInstallation文件,3.X ,4.X ,5.X系统要安装AppSync的原因,原理就是骗过iTunes的数字签名验证,允许没有合法签名的程序在设备上运行。

苹果软件通用的破解过程如下:

1.通过输入信息在var/mobile/Applications下定位待破解软件所在位置

2.复制软件目录下所有的文件到一个临时目录

3.通过toolchain中的otool分析程序主文件,找出cryptsize和cryptid

4.运行待破解程序,通过gdb调试程序监测程序内存

5.因为程序已经运行,所以此时是解密状态。dump当前未加密的内存

6.将dunp结果输出到一个bin文件,退出gdb调试程序

7.将主程序文件的cryptid字串改为0,改加密状态为未加密

8.将dump出来的bin文件中的未加密内存的内容覆盖到原主程序文件的相应位置

9.对主程序签名

10.删除一些垃圾文件

11.打包IPA

苹果itunes授权过程:

1.首先申请了一个appstore帐号,itunes会在C盘生成SCinfo (xp下的C:\Documents and Settings\All Users\Application Data\Apple Computer\iTunes\SC Info就是)

2.每在appstore下一个程序,itunes会自动更新sc里的授权信息授权信息里包括系统序列号、C盘ID、网卡MAC等,当然还有你帐户下购买所有的软件列表

3.当利用itunes同步软件时,itunes会同时把该帐号下的授权导入ipad,所以大神们分享授权也是这个原理,只要同步一个帐号下的授权就可以了,当然有新授权除外

4.itunes只认scinfo下的授权文件,所以用不同用户的scinfo可以得到不同人的授权信息并同步给ipad或iphone

多账号授权注意要点:

1.如果有多用户授权文件,如大V、大S、大A等三个人授权文件时(大A跟大V的授权帐号非常多,大概有20多个)先修改硬盘序列号为各授权文件的硬盘序列号(打开各自己授权人的.ini文件可以看到硬盘序列号,在最下边),然后再COPY授权文件到授权软件目录,导入相应的授权文件,如大V下有13个授权帐号(下过的清楚123个文件夹每个4个授权人软件)这时需要itunes同步13个授权(即内置的13个应用软件)到ipad,每次同步不超过5个应用,同步后,从itunes内删除应用,然后从ipad删除刚安装授权的几个应用,得到13个授权。这时ipad内除了本有的应用外,应该是空的。

2.打开第二个授权人文件,按步骤1的方法导入第二个授权人软件(注意授权人发布授权时一般都有注明有多少个授权帐号,都需要相应的授权帐号软件依次同步导入删除),然后删除ipad内的刚安装授权的应用(如果只有单一授权帐号时不需要删除原有软件)。

3.打开大S授权后重复以上步骤。最终可得到所有坛子上比较热门的所有授权人的帐号授权。

以上每次从itunes同步后,下次同步前,需将ipad内为得到授权而同步内的应用全部删除,或者说把除了系统自带的应用外的所有应用删除。

Control+SHIFT 快速放大dock的图标会暂时放大,而如果你开启了dock放大

Command+Option+W 将所有窗口关闭

Command+W 将当前窗口关闭(可以关闭Safari标签栏,很实用)

Command+Option+M 将所有窗口最小化

Command+Q 关闭当前应用程序(相当于Dock鼠标右键推出.很实用)

Command+M 将目前使用的窗口最小化

Command+H 隐藏当前窗口或者软件

Command+tab 为切换当前工作任务

Control+Command+S 切换控制条的显示和隐藏

Command+i 常规信息(显示及设置图标属性)

Command+delete 移到废纸篓(删除)

Optionion+鼠标 拖图像或文件夹可以将图像或文件夹拷贝到其它文件夹中,而不是移动

Command+Shift+backspace 清空废纸篓(再加上option一起按能跳过确认对话框)

Command+N 键可以建立新文件夹 “return”或“enter”或“O”键可以打开所选项目

Command+Option+esc 键可以强行退出死机程序

Command+Shift+3 截图(当前屏幕)

Command+Shift+4 截图(自由选取范围)

Option+F12 关机窗口(能选择关机、重起、睡眠)

Command+1 以图标方式显示

Command+2 以分栏方式显示

Command+3 以列表方式显示

Command+4 以Cover Flow方式显示

return或enter 键可以编辑所选图像或文件夹的名称

Control+Option+Command+8 屏幕颜色反转(晚上看书使用)

2010年4月21日

Linux 常用的查看系统信息的命令:

查看CPU信息:cat /proc/cpuinfo

查看硬盘信息: df -lh

查看内存信息: free -m

|

在LINUX环境开发驱动程序,首先要探测到新硬件,接下来就是开发驱动程序。

常用命令整理如下:

用硬件检测程序kuduz探测新硬件:service kudzu start ( or restart)

查看CPU信息:cat /proc/cpuinfo

查看板卡信息:cat /proc/pci

查看PCI信息:lspci (相比cat /proc/pci更直观)

例子: lspci |grep Ethernet 查看网卡型号

查看内存信息:cat /proc/meminfo

查看USB设备:cat /proc/bus/usb/devices

查看键盘和鼠标:cat /proc/bus/input/devices

查看系统硬盘信息和使用情况:fdisk & disk - l & df

查看各设备的中断请求(IRQ):cat /proc/interrupts

查看系统体系结构:uname -a |

dmidecode查看硬件信息,包括bios、cpu、内存等信息

|

Dmidecode

dmidecode以一种可读的方式dump出机器的DMI(Desktop Management Interface)信息。这些信息包括了硬件以及BIOS,既可以得到当前的配置,也可以得到系统支持的最大配置,比如说支持的最大内存数等。

DMI有人也叫SMBIOS(System Management BIOS),这两个标准都由DMTF(Desktop Management Task Force)开发。

dmidecode的输出格式一般如下:

----------------------------------------

Handle 0x0002

DMI type 2, 8 bytes

Base Board Information

Manufacturer:Intel

Product Name: C440GX+

Version: 727281-0001

Serial Number: INCY92700942

----------------------------------------

其中的前三行都称为记录头(recoce Header), 其中包括了:

1、recode id(handle): DMI表中的记录标识符,这是唯一的,比如上例中的Handle 0x0002。

2、dmi type id: 记录的类型,譬如说:BIOS,Memory,上例是type 2,即"Base Board Information"

3、recode size: DMI表中对应记录的大小,上例为8 bytes.(不包括文本信息,所有实际输出的内容比这个size要更大。)

记录头之后就是记录的值:

4、decoded values: 记录值可以是多行的,比如上例显示了主板的制造商(manufacturer)、model、version以及serial Number。

dmidecode的使用方法

1. 最简单的的显示全部dmi信息:

# dmidecode

这样将输出所有的dmi信息,你可能会被一大堆的信息吓坏,通常可以使用下面的方法。

2.更精简的信息显示:

# dmidecode -q

-q(--quite) 只显示必要的信息,这个很管用哦。

3.显示指定类型的信息:

通常我只想查看某类型,比如CPU,内存或者磁盘的信息而不是全部的。这可以使用-t(--type TYPE)来指定信息类型:

# dmidecode -t bios

# dmidecode -t bios, processor (这种方式好像不可以用,必须用下面的数字的方式)

# dmidecode -t 0,4 (显示bios和processor)

dmidecode到底支持哪些type?

这些可以在man dmidecode里面看到:

文本参数支持:

bios, system, baseboard, chassis, processor, memory, cache, connector, slot

数字参数支持很多:(见附录)

4.通过关键字查看信息:

比如只想查看序列号,可以使用:

# dmidecode -s system-serial-number

-s (--string keyword)支持的keyword包括:

-------------------------------------------------------------------------------------

bios-vendor,bios-version, bios-release-date,

system-manufacturer, system-product-name, system-version, system-serial-number,

baseboard-manu-facturer,baseboard-product-name, baseboard-version, baseboard-serial-number, baseboard-asset-tag,

chassis-manufacturer, chas-sis-version, chassis-serial-number, chassis-asset-tag,

processor-manufacturer, processor-version.

-------------------------------------------------------------------------------------

5.示例

5.1 查看当前内存和支持的最大内存

Linux下,可以使用free或者查看meminfo来获得当前的物理内存:

# free

total used free shared buffers cached

Mem: 8182532 8010792 171740 0 148472 4737896

-/+ buffers/cache: 3124424 5058108

Swap: 4192956 3304 4189652

# grep MemTotal /proc/meminfo

MemTotal: 8182532 kB

这里显示了当前服务器的物理内存是8GB。

服务器到底能扩展到多大的内存?

#dmidecode -t 16

# dmidecode 2.7

SMBIOS 2.4 present.

Handle 0x0013, DMI type 16, 15 bytes.

Physical Memory Array

Location: System Board Or Motherboard

Use: System Memory

Error Correction Type: Multi-bit ECC

Maximum Capacity: 64 GB (可扩展到64GB)

Error Information Handle: Not Provided

Number Of Devices: 4

但是,事实不一定如此,因此插槽可能已经插满了。也就是我们还必须查清这里的8G到底是4*2GB, 2*4GB还是其他?

如果是4*2GB,那么尽管可以扩展到64GB,但是插槽已经插满,无法扩展了:

#dmidecode -t 17

# dmidecode 2.7

SMBIOS 2.4 present.

Handle 0x0015, DMI type 17, 27 bytes.

Memory Device

Array Handle: 0x0013

Error Information Handle: Not Provided

Total Width: 72 bits

Data Width: 64 bits

Size: 2048 MB 【插槽1有1条2GB内存】

Form Factor: DIMM

Set: None

Locator: DIMM00

Bank Locator: BANK

Type: Other

Type Detail: Other

Speed: 667 MHz (1.5 ns)

Manufacturer:

Serial Number: BZACSKZ001

Asset Tag: RAM82

Part Number: MT9HTF6472FY-53EA2

Handle 0x0017, DMI type 17, 27 bytes.

Memory Device

Array Handle: 0x0013

Error Information Handle: Not Provided

Total Width: 72 bits

Data Width: 64 bits

Size: 2048 MB 【插槽2有1条2GB内存】

Form Factor: DIMM

Set: None

Locator: DIMM10

Bank Locator: BANK

Type: Other

Type Detail: Other

Speed: 667 MHz (1.5 ns)

Manufacturer:

Serial Number: BZACSKZ001

Asset Tag: RAM83

Part Number: MT9HTF6472FY-53EA2

Handle 0x0019, DMI type 17, 27 bytes.

Memory Device

Array Handle: 0x0013

Error Information Handle: Not Provided

Total Width: 72 bits

Data Width: 64 bits

Size: 2048 MB 【插槽3有1条2GB内存】

Form Factor: DIMM

Set: None

Locator: DIMM20

Bank Locator: BANK

Type: Other

Type Detail: Other

Speed: 667 MHz (1.5 ns)

Manufacturer:

Serial Number: BZACSKZ001

Asset Tag: RAM84

Part Number: MT9HTF6472FY-53EA2

Handle 0x001B, DMI type 17, 27 bytes.

Memory Device

Array Handle: 0x0013

Error Information Handle: Not Provided

Total Width: 72 bits

Data Width: 64 bits

Size: 2048 MB 【插槽4有1条2GB内存】

Form Factor: DIMM

Set: None

Locator: DIMM30

Bank Locator: BANK

Type: Other

Type Detail: Other

Speed: 667 MHz (1.5 ns)

Manufacturer:

Serial Number: BZACSKZ001

Asset Tag: RAM85

Part Number: MT9HTF6472FY-53EA2

根据上面输出可以发现,如果要扩展,只有将上面的内存条换成16GB的,才能达到4*16GB=64GB的最大支持内存。

附录:

dmidecode支持的数字参数:

Type Information

----------------------------------------

0 BIOS

1 System

2 Base Board

3 Chassis

4 Processor

5 Memory Controller

6 Memory Module

7 Cache

8 Port Connector

9 System Slots

10 On Board Devices

11 OEM Strings

12 System Configuration Options

13 BIOS Language

14 Group Associations

15 System Event Log

16 Physical Memory Array

17 Memory Device

18 32-bit Memory Error

19 Memory Array Mapped Address

20 Memory Device Mapped Address

21 Built-in Pointing Device

22 Portable Battery

23 System Reset

24 Hardware Security

25 System Power Controls

26 Voltage Probe

27 Cooling Device

28 Temperature Probe

29 Electrical Current Probe

30 Out-of-band Remote Access

31 Boot Integrity Services

32 System Boot

33 64-bit Memory Error

34 Management Device

35 Management Device Component

36 Management Device Threshold Data

37 Memory Channel

38 IPMI Device

39 Power Supply

|

dmesg | more 查看硬件信息

对于“/proc”中文件可使用文件查看命令浏览其内容,文件中包含系统特定信息:

Cpuinfo 主机CPU信息

Dma 主机DMA通道信息

Filesystems 文件系统信息

Interrupts 主机中断信息

Ioprots 主机I/O端口号信息

Meninfo 主机内存信息

Version Linux内存版本信息

|

2010年3月23日

1 使用jms需要注意的问题

一下所述的问题,不仅是对ActiveMQ,对于其他的JMS也一样有效。

1.1 不要频繁的建立和关闭连接

JMS使用长连接方式,一个程序,只要和JMS服务器保持一个连接就可以了,不要频繁的建立和关闭连接。频繁的建立和关闭连接,对程序的性能影响还是很大的。这一点和jdbc还是不太一样的。

1.2 Connection的start()和stop()方法代价很高

JMS的Connection的start()和stop()方法代价很高,不能经常调用。我们试用的时候,写了个jms的connection

pool,每次将connection取出pool时调用start()方法,归还时调用stop()方法,然而后来用jprofiler发现,一般的

cpu时间都耗在了这两个方法上。

1.3 start()后才能收消息

Connection的start()方法调用后,才能收到jms消息。如果不调用这个方法,能发出消息,但是一直收不到消息。不知道其它的jms服务器也是这样。

1.4 显示关闭Session

如果忘记了最后关闭Connection或Session对象,都会导致内存泄漏。这个在我测试的时候也发现了。本来以为关闭了

Connection,由这个Connection生成的Session也会被自动关闭,结果并非如此,Session并没有关闭,导致内存泄漏。所以一

定要显示的关闭Connection和Session。

1.5 对Session做对象池

对Session做对象池,而不是Connection。Session也是昂贵的对象,每次使用都新建和关闭,代价也非常高。而且后来我们发现,

原来Connection是线程安全的,而Session不是,所以后来改成了对Session做对象池,而只保留一个Connection。

2 集群

ActiveMQ有强大而灵活的集群功能,但是使用起来还是会有很多陷阱。

2.1 broker cluster和 master-slave

ActiveMQ可以做broker的集群,也可以做master-slave方式的集群。前者能在多个broker之前fail-over和

load-balance,但是在某个节点出故障时,可能导致消息丢失;而后者能实时备份消息,和fail-over,但是不能load-

balance。broker

cluser的方式,在一个broker上发送的消息可以在其它的broker上收到。当一个broker失效时,客户端可以自动的转到别的broker

上运行,多个broker可以同时提供服务,但是消息只存储在一个broker上,如果那个broker失效了,那么客户端直到它重新启动后才能收到该

broker上的消息,假如很不幸,那个broker的存储介质坏了,那么消息就丢失掉了。

Master-slave方式中,只有master提供服务,slave只是实时的备份master的数据,所以消息不会丢失。当master失效

时,slave会自动升为master,客户端会自动转到slave上工作,所以能fail-over。由于只有master提供服务,所以不能将负载分

到多个broker上。

其实单个broker的性能已经是相当的惊人了,在我们公司的机器上能达到每秒收发4000个消息,没个消息4K字节这样的速度,足够公司目前的需要了,而公司并不希望丢失任何数据,所以我们选择使用master-slave模式。

2.2 多种master-slave模式

master-slave也有多种实现方式。它们的不同只是在共享数据和锁机制上。

2.2.1 Pure master-slave

Pure

master-slave,显示的在配置文件中指定一个broker做为另一个broker的slave。运行时,slave同过网络自动从master

出复制数据,同时在和master失去连接时自动升级为master。当master失效,slave成为master后,如果要让原先的master重

新投入运行,需要停掉运行中的slave(现在升级为master了),手动复制slave中的数据到master中。再重新启动master和

slave。这种方式最简单,效率也不错,但是只能有两台做集群,只能fail-over一次,而且需要停机回复master-slave结构。

2.2.2 JDBC master-slave

这种方式不需要特殊的配置,只要让所有的节点都把数据存储到同一个数据库中。先拿到数据库表的锁的节点成为master,一旦它失效了,其它的节点

获得锁,就可以成为master。因为数据通过数据库共享,放在一个地方,不需要停机恢复master-slave。这种方式,需要额外的数据库服务器,

如果数据库失效了,那么就全失效了,而且速度不是很快。我们在用mysql测试时,并没有成功,master失效后,其他的节点始终没有升级成

slave,可能是数据库配置的问题。

2.2.3 Share file master-slave

这种方式类似于前者,也不需要特别的配置,只是通过共享文件系统来共享数据,靠文件锁实现只有一台成为master。共享文件系统的方式有很多,我们测试了nfs v4 (v3有bug,不行), 最终在稳定性,效率等方面不是很满意,可能是通过网络太慢了。

测试过众多master-slave模式后发现,pure方式管理起来麻烦,jdbc方式成本高,效率低,share

file方式需要高性能的共享文件,都有缺点。鉴于单台activeMQ很可靠,而我们的基础平台组愿意用硬件备份,最终还是决定不用master-

slave了,也不用broker cluster,就用单台,通过硬件冗余保证数据不会丢失,并找另外一台刀片机做冷备,在主服务器失效时顶替。

2009年3月28日

JProfiler 是一个著名的用于 java 系统监控分析的软件,功能很强大,可以监控普通的 java application, applet, java web start, application server 等等。除了可以监控本地的程序,还可以对远程服务器上跑的应用进行监控。本文以 JBoss 为例,对 JProfiler 的安装、配置和使用做个简单介绍。

先说一下环境:

服务器:RedHat Linux 3.4.3-9.EL4(内核版本 2.6.9-5.ELsmp),JBoss 4.0.3,Sun JDK 1.5.0_08,JProfiler 4.3.2 for linux(安装包:jprofiler_linux_4_3_2.sh)

客户端:Windows XP,JProfiler 4.3.2 for windows(安装包:jprofiler_windows_4_3_2.exe)

客户端 JProfiler 安装:直接运行安装程序即可,没啥可说的。有一点就是安装过程中,norton 曾经报警,不理他,安完之后也没发现有什么问题

服务器端 JProfiler 安装:把 jprofiler_linux_4.3.2.sh 上传到到服务器,假设路径为 /opt/jprofiler4 (后文用 $JPROFILER_HOME指代)。用如下命令: # cd /opt/jprofiler4 # chmod +x *.sh # ./jprofiler_linux_4.3.2.sh -c

按照提示来安装,提示都很简单,不在多说。安装路径选择 $JPROFILER_HOME 。注意,这里的 -c 意思是用字符方式来安装,如果机器上没有 X 则加上该参数。

服务器端的配置:

1. 修改系统配置,在 LD_LIBRARY_PATH 里加入 JProfiler 的库文件所在路径 $JPROFILER_HOME/bin/linux-x86 ,如果是 64 位服务器,则选择 $JPROFILER_HOME/bin/linux-x64。

2. 修改 JBoss 的启动脚本,加入如下参数:

-agentlib:jprofilerti=port=8849 -Xbootclasspath/a:$JPROFILER_HOME/bin/agent.jar

例如: $JAVA_HOME/bin/java $JAVA_OPTS -agentlib:jprofilerti=port=8849 -Xbootclasspath/a:/opt/jprofiler-4.3.2/bin/agent.jar -Djava.endorsed.dirs="$JBOSS_ENDORSED_DIRS" -Djava.library.path=$JBOSS_HOME/server/default/lib -classpath "$JBOSS_CLASSPATH" org.jboss.Main -c default 1>$JBOSS_CONSOLE 2>&1 </dev/null &

8849 是默认的端口号

3. 重新 login linux ,启动 jboss 。查看一下 $JBOSS_HOME/server/default/log/server.log ,可以看到 JBoss 并未启动,原因是上边的配置选择的启动模式,只有当一个 JProfiler GUI(指 Windows XP 下安装的 jprofiler )的监听请求发过来时候,JProfiler才会真正的启动被监控的应用程序也就是 JBoss 。另外有一种启动模式与此不同,它可以直接启动被监控的应用程序而不必等待。这种配置稍微麻烦一点,以后在说。

客户端的配置和使用:

1. 运行 JProfiler 。第一次打开会有向导,忽略它。

2. 选择 Session->Integration Wizard->New Remote Integratation

3. 选择 On a remote computer;Platform of remote computer 选择 Linux x86/AMD 64;Next

4. 输入服务器 IP ;Next

5. 输入服务器上的 jprofiler 的安装路径,如 /opt/jprofiler4 ;next

6. 选择服务器的 JDK 环境,这里是:Sun,1.5.0,hotspot;next

7. 输入端口:这里是默认值 8849;next

8. 选择启动模式:这里选第一种 wait for a connection from the jprofiler GUI;next

9. 这里会列出需要在服务器端做的配置。上一步“服务器端的配置”我们已经做过了。如果在第 8 步选择了第二种启动方式 Don't wiat, start immediately ,这里也会列出相应的服务器端配置方法,可以参考。next

10. Finish

此时 session 会被启动。在 profiling settings 对话框里,不用做任何修改,ok 即可。此时 session 被启动。观察一下服务器,发现 JBoss 也启动了。这时就可以在客户端看到 jboss 的运行情况,比如内存的占用等等。

我用 jprofiler 主要是监控内存占用情况看是否有 member leak 。点左侧的 “VM Telemetry Views”可以看到 jboss 占用的内存情况。

ActiveMQ本身是开源项目,所以采用ActiveMQ的项目往往也是以其他开源软件共同构建,目前主流开源应用服务器有Boss,geronimo,JOnAs,而其中geronimo 默认的JMS Provider就是ActiveMQ,那我们就着重介绍ActiveMQ与JBoss,JOnAs的整合方案。

整合需要的环境.

jdk1.5

jboss-4.0.5.GA

activemq-ra-4.1.0-incubator.rar (在ActiveMQ 4.* lib\optional 目录里面有对应的ra的压缩包)

开始整合前请确保jboss能够正确的启动起来。

整合步骤

1. 步骤一: 解压activemq-rar-4.1.0-incubator.rar 到 jboss-4.0.5.GA\server\default\deploy\activemq-ra.rar (这个是目录名字) 下面是activemq-rar.rar目录下面的文件和子目录,请注意红色标记的地方(后面会逐一说明,整合的过程)

activeio-core-3.0.0-incubator.jar activemq-core-4.1.0-incubator.jar activemq-ra-4.1.0-incubator.jar backport-util-concurrent-2.1.jar commons-logging-1.0.3.jar derby-10.1.1.0.jar geronimo-j2ee-management_1.0_spec-1.0.jar spring-2.0.jar spring-1.2.6.jar xbean-spring-2.7.jar broker-config.xml META-INF

2.步骤二. 删除多余的spring-1.2.6.jar,由于4.1.0的ra里面包含了2个不同版本的spring会触发一个exception的产生,https://issues.apache.org/activemq/browse/AMQ-1124, 而且为了以后能够使用新的spring schema配置方式,我们这里会删除spring-1.2.6.jar,保留spring-2.0.jar。(最新的snapshot version的ra已经去掉了这个多余的spring-1.2.6.jar).

3.步骤三: 修改META-INF\ra.xml,让JBoss使用broker-config.xml 作为默认的配置文件配置borker. 修改下面的地方

<config-property-value>config-property-value> <!-- <config-property-value>xbean:broker-config.xml</config-property-value>-->

改为: <!-- <config-property-value></config-property-value> --> <config-property-value>xbean:broker-config.xmlconfig-property-value>

表示使用broker-config.xml来配置启动ActiveMQ.

4.步骤四: 修改borker-config.xml,默认的borker-config.xml会产生一个错误,无论是我使用的版本还是最后的snapshot版本,默认的borker-config.xml都会让xbean-spring 2.7(snapshot 使用的是2.8)抛出exception.解决的办法如下,将 <beans xmlns="http://activemq.org/config/1.0"> <broker useJmx="true" >

改为 <beans> <broker useJmx="true" xmlns="http://activemq.org/config/1.0">

即可

5.步骤五: 将xbean-spring-2.7.jar (或者是2.8) 复制到jboss-4.0.5.GA\server\default\lib下面

使用整合完毕的ActiveMQ作为ds绑定到JBoss的JNDI服务。

编写jboss-4.0.5.GA\server\default\depoly\activemq-ds.xml,xml 代码

<? xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE connection-factories PUBLIC "-//JBoss//DTD JBOSS JCA Config 1.5//EN" "http://www.jboss.org/j2ee/dtd/jboss-ds_1_5.dtd">

<connection-factories>

<tx-connection-factory>

<jndi-name>activemq/QueueConnectionFactory</jndi-name>

<xa-transaction />

<track-connection-by-tx />

<rar-name>activemq-ra.rar</rar-name>

<connection-definition>javax.jms.QueueConnectionFactory</connection-definition>

<serverurl>tcp://localhost:61616</serverurl>

<min-pool-size>1</min-pool-size>

<max-pool-size>200</max-pool-size>

<blocking-timeout-millis>30000</blocking-timeout-millis>

<idle-timeout-minutes>3</idle-timeout-minutes>

</tx-connection-factory>

<tx-connection-factory>

<jndi-name>activemq/TopicConnectionFactory</jndi-name>

<xa-transaction />

<track-connection-by-tx />

<rar-name>activemq-ra.rar</rar-name>

<connection-definition>javax.jms.TopicConnectionFactory</connection-definition>

<serverurl>tcp://localhost:61616</serverurl>

<min-pool-size>1</min-pool-size>

<max-pool-size>200</max-pool-size>

<blocking-timeout-millis>30000</blocking-timeout-millis>

<idle-timeout-minutes>3</idle-timeout-minutes>

</tx-connection-factory>

<mbean code="org.jboss.resource.deployment.AdminObject" name="activemq.queue:name=outboundQueue">

<attribute name="JNDIName">activemq/queue/outbound</attribute>

<depends optional-attribute-name="RARName">

jboss.jca:service=RARDeployment,name='activemq-ra.rar'

</depends>

<attribute name="Type">javax.jms.Queue</attribute>

<attribute name="Properties">PhysicalName=queue.outbound</attribute>

</mbean>

<mbean code="org.jboss.resource.deployment.AdminObject" name="activemq.topic:name=inboundTopic">

<attribute name="JNDIName">activemq/topic/inbound</attribute>

<depends optional-attribute-name="RARName">

jboss.jca:service=RARDeployment,name='activemq-ra.rar'

</depends>

<attribute name="Type">javax.jms.Topic</attribute>

<attribute name="Properties">PhysicalName=topic.inbound</attribute>

</mbean>

</connection-factories>

启动JBoss.如果看见以下信息就表示ActiveMQ已经成功启动,并且使用上面的ds配置文件成功地将topic/queue绑定到了JNDI服务上。

.....

[TransportConnector] Connector tcp://localhost:61616 Started

[NetworkConnector] Network Connector bridge Started

[BrokerService] ActiveMQ JMS Message Broker (localhost, ID:MyNoteBook-2165-1173250880171-1:0) started ......

[ConnectionFactoryBindingService] Bound ConnectionManager 'jboss.jca:service=ConnectionFactoryBinding,name=activemq/QueueConnectionFactory' to JNDI name 'java:activemq/QueueConnectionFactory'

[ConnectionFactoryBindingService] Bound ConnectionManager 'jboss.jca:service=ConnectionFactoryBinding,name=activemq/TopicConnectionFactory' to JNDI name 'java:activemq/TopicConnectionFactory'

[AdminObject] Bound admin object 'org.apache.activemq.command.ActiveMQQueue' at 'activemq/queue/outbound'

[AdminObject] Bound admin object 'org.apache.activemq.command.ActiveMQTopic' at 'activemq/topic/inbound ......

验证ActiveMQ+JBoss

这里你可以使用简单的jms client连接到broker-config.xml里面的协议连接器上面,默认的是tcp://localhost:61616

在后面我们会在此整合基础上开发Message Driver Bean和使用spring MDP 2种构架 来验证本次ActiveMQ+JBoss的整合。

$JBOSS-HOME/bin:

放置各种脚本文件以及相关文件,包括jboss 启动和停止的可执行脚本文件。

$JBOSS-HOME/client:

存储配置信息和可能被Java客户端应用程序或外部Web容器用到的jar文件,通常包括EJB客户端运行时所需要的jar

$JBOSS-HOME/docs:

保存在JBoss中引用到的XML文件和DTD文件(这里也提供了在JBoss中如何写配置文件的例子)、测试脚本。$JBOSS-HOME/docs/examples目录下有针对不通的数据库(如MySql、Oracle、SQL Server、Postgres等)配置数据源的JCA配置文件。 相关DTD定义文件位于$JBOSS-HOME/docs/dtd,在其下的文件中可以查阅某个XML配置文件中某个元素或属性的意义。

$JBOSS-HOME/lib:

这里存储运行JBoss微内核所需的jar文件。该目录下不要存储任何你自己的jar文件。

$JBOSS-HOME/server:

这里的每一个子目录对应着一个服务器配置。该配置由运行脚本文件时的参数"-c <配置名称>"来确定。在server目录下有三个配置例子,即all、default和minimal,每一个配置安装的服务都不一样。其中default下是缺省配置。

minimal:仅加载启动JBoss所需的最少服务,如日志服务、JNDI和URL部署扫描器(发现新的部署),不包含Web容器、EJB和JMS。

all:启动所有的服务,包括RMI/IIOP、集群服务和Web服务部署器(默认配置不会被加载)。

启动JBoss时,如果run.bat不带任何参数,则使用的配置是server/default目录下的配置。如果要以其它目录下的配置启动JBoss,可以使用如下参数:

run -c all

上述命令将以all目录下的配置信息启动JBoss。也可以在server目录下新建目录,按自己的需要写配置文件。

下面以default目录为例,介绍服务器配置的目录结构。

conf:该目录下有指定核心服务的jboss-service.xml文件,也可以放其它服务配置的文件。例如:jboss-log4j.xml 是log4j的配置文件

data:该目录是JBoss内置的数据库Hypersonic存储数据的地方,也是JBossMQ(the JBoss implementation of JMS)存储相关信息的地方。

deploy:这是部署J2EE应用程序(jar、war和ear文件)的位置,只需将相应文件拷贝到该目录下即可。该目录也用来热部署服务和JCA资源适配器。默认已经有一些服务部署到这个目录。

jmx-console,你启动JBoss后即可访问。JBoss会周期性的扫描deploy目录,当有任何组件改变,JBoss会重新部署该程序。

jboss-web.deployer就是jboss集成tomcat所在的位置。启动端口号可以通过修改该目录下的server.xml来进行配置。

数据源配置文件文件格式必须是*-ds.xml的样式。不同的数据库配置参数可参考$JBOSS-HOME/docs/examples/jca/下的示例文档。有关参数的细节在下面会有一定的描述。

lib:存放服务器配置所需的jar文件、公共的jar文件,比如,你可以将JDBC jar文件、log4j的jar文件等等放在该目录下。 如果这些jar已经在该lib下存在,那么web应用的WEB-INF/lib下不用再次放置。

log:存放日志信息。JBoss使用Jakarta log4j包存储日志,在程序中你也可以直接使用该信息。默认的log4j.xml配置是将日志输出到该文件夹下的server.log文件。 jboss-log4j.xml是默认配置文件

tmp:存储在部署过程中解压时产生的临时文件。

work:Tomcat编译JSP文件时的工作目录。如果JSP出错了,可以到该目录下去找对应的文件,定位问题。

目录data、log、tmp和work在JBoss安装后并不存在,当JBoss运行时自动建立。

启动JBOSS成功后

查看 http://localhost:8083 会出现一个没有错误的空白页,正常,应该是这样。

查看 http://localhost:1099 会出现一大堆乱字符,当然,里面包含了你的 IP 地址等等类似的信息。 1099 是 jnp 协议监听名字服务的缺省端口, RMI 的缺省端口也是一样的。在 JNDI 中,我们需要用到此端口。

2008年9月6日

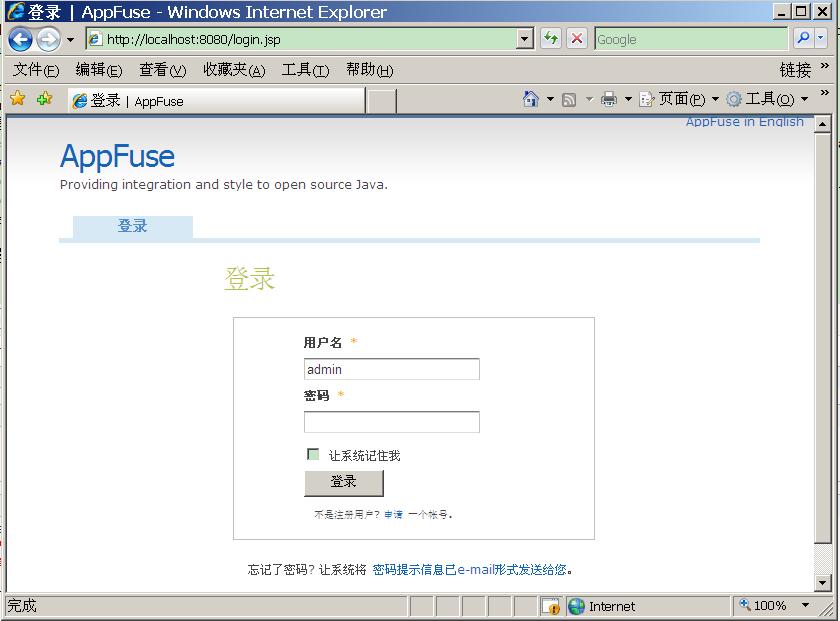

AppFuse

是一个开源项目,主要目的是使用开源工具来帮助开发者快速有效的建立Web应用项目。使用AppFuse可以减少开发人员在建立新web应用时候花费大量

时间在项目结构的建立上。 最核心的是, AppFuse是一个项目的骨架,类似图使用IDE的向导方式来创建web项目。

AppFuse 2 的环境配置:

a. 安装JDK 5+ (确保JAVA_HOME 指向JDK目录, 而不是JRE目录).

b. 安装 MySQL 5.x.

c. 建立本地SMTP服务或者修改mail.properties (在src/main/resources) 的use为一个不同的主机名- it 缺省是 "localhost".

d. 安装Maven 2.0.9+.

因为AppFuse 2使用了Maven 2 的支持。一般的Maven2 会再你使用AppFuse的包的时候会下载这些包,但是如果你的网络不好的话。你也可以自己下载AppFuse2的依赖包,其下载地址为:https://appfuse.dev.java.net/servlets/ProjectDocumentList?folderID=9173&expandFolder=9173&folderID=9173,现在版本是AppFuse2.02.大小为80M多。

然后解压到某个文件夹下,然后修改Maven_Home下的/conf/settings.xml里的相应配置,设置本地资源库。

<!-- localRepository

The path to the local repository maven will use to store artifacts.

Default: ~/.m2/repository

<localRepository>/path/to/local/repo</localRepository>

-->

<localRepository>E:/appfusedeps/repository</localRepository>

需要注意的上面的配置里说默认的资源库路径为~/.m2/repository,这是指用户的home目录,但如果这样设置在windows下,会

产生一些问题,因为windows的用户目录在C:\Documents and

Settings下,而这个目录有空格,所以最好直接指定另外的没有空格的英文路径。

下面是创建不同种类项目的Archetype Command:

1.JSF Basic

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-basic-jsf

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

2.Spring MVC Basic

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-basic-spring

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

3. Struts 2 Basic

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-basic-struts

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

4. Tapestry Basic

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-basic-tapestry

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

5. JSF Modular

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-modular-jsf

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

6.Spring MVC Modular

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-modular-spring

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

7.Struts 2 Modular

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-modular-struts

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

8.Tapestry Modular

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-modular-tapestry

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

9.Core(backend only)

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-core

-DremoteRepositories=http://static.appfuse.org/releases-DarchetypeVersion=2.0

-DgroupId=com.mycompany.app -DartifactId=myproject

下面将举一个例子:

1. 在D盘创建一个目录D:\projects\

2. 启动cmd。进入目录D:\projects\.

3.执行如下建构命令创建基本的:

mvn archetype:create -DarchetypeGroupId=org.appfuse.archetypes

-DarchetypeArtifactId=appfuse-basic-struts

-DremoteReposities=http://static.appfuse.org/release

-Darchetypeversion=2.0.1 -DgroupId=com.zhangjr.framework

-DartifactId=myproject

4.执行结束后将会看到D:\projects\myproject目录结构,编辑D:\projects\myproject\pom.xml,修改mysql数据连接信息,主要是修改root的密码为你自己数据库用户密码

因为缺省为空<jdbc.password></jdbc.password>。

5.在cmd中进入目录D:\projects\myproject

6.执行mvn jetty:run-war

7.等执行结束后,在浏览器地址栏输入